In diesem Artikel erfahren wir mehr über:

- Die Herausforderungen, die sich Entwicklern stellen, wenn die von Websites gescrapten Daten unzuverlässig oder veraltet sind

- Die Ursachen für schlechte Scraping-Ergebnisse erkennen

- Vorschläge, wie man saubere, vertrauenswürdige Daten erhält

Tauchen wir ein!

Einige Ursachen für ungenaue Web-Scraping-Daten

Bevor Sie erfahren, wie Sie die Genauigkeit Ihrer gescrapten Daten verbessern können, müssen Sie einige der Ursachen für diese Probleme kennen. In diesem Abschnitt werden Sie einige der Probleme kennenlernen, die beim Scraping auftreten können. Einige davon sind dynamische Inhalte, häufige DOM-Änderungen usw.

JavaScript-gerenderte Inhalte erzeugen Datenlücken

JavaScript-lastige Websites laden Inhalte asynchron nach der anfänglichen HTML-Antwort, so dass herkömmliche HTTP-Scraper unvollständige Seitenstrukturen vorfinden. Wenn Sie eine Seite anfordern, erhalten Sie nur das anfängliche HTML-Skelett, bevor JavaScript ausgeführt wird. Produktlisten auf E-Commerce-Websites, Benutzerkommentare auf sozialen Plattformen und Infinite-Scroll-Inhalte werden in der Regel durch AJAX-Aufrufe geladen, die Millisekunden oder Sekunden nach dem Laden der Seite erfolgen.

Diese zeitliche Diskrepanz führt dazu, dass Scraper Platzhalterelemente, Ladespinner oder leere Container anstelle der eigentlichen Daten extrahieren. Das gescrapte HTML kann <div class="product-list" data-loading="true"></div> anstelle der ausgefüllten Produktdaten enthalten.

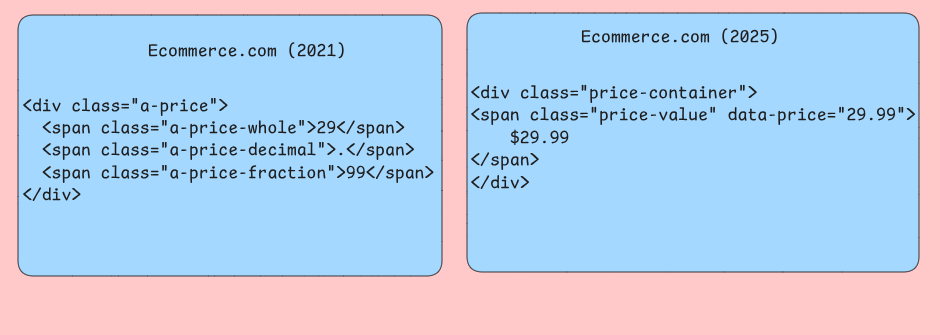

Inkonsistente Entwicklung der DOM-Struktur

Websites ändern häufig ihre HTML-Struktur, ohne die Abwärtskompatibilität für automatisierte Tools zu gewährleisten. Sie haben vielleicht CSS-Selektoren, die monatelang zuverlässig funktionierten und plötzlich leere Ergebnisse liefern, wenn Entwickler Klassennamen ändern, Layouts umstrukturieren oder Elemente in andere übergeordnete Container verschieben. Ihr Scraper könnte auf .product-price-Selektoren abzielen, die bei einer Umgestaltung der Website in .item-cost umbenannt werden.

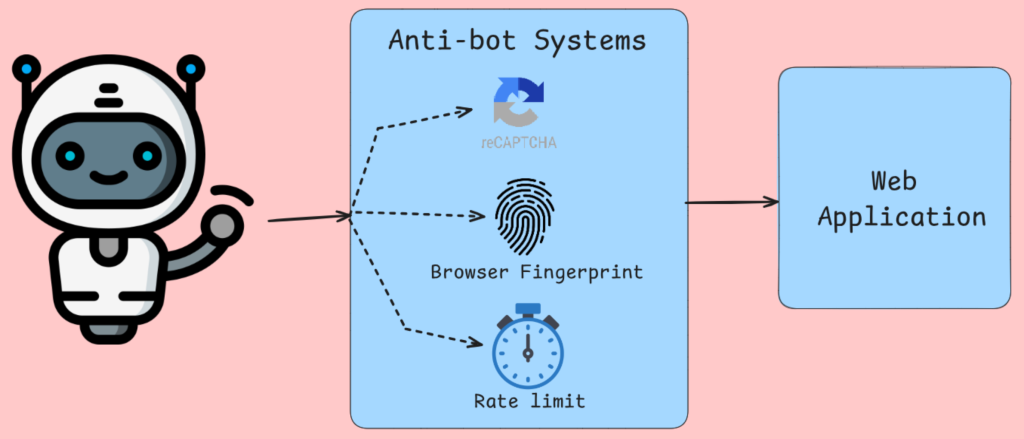

Anti-Bot-Systeme, die die Datenerfassung beeinträchtigen

Die Bot-Erkennung beschränkt sich nicht nur auf IP-Blockierung, die Analyse von Browser-Fingerabdrücken, Mausbewegungen und die anderen bekannten Prüfungen. Tools wie Cloudflare und ähnliche Dienste injizieren JavaScript-Herausforderungen, die die Ausführung des Browsers erfordern, um den Vorgang abzuschließen. Nach der Browserprüfung werden Ihnen alternative Inhalte oder Fehlerseiten für Anfragen angezeigt, die diese Tests nicht bestehen. Ihr Scraper erhält CAPTCHA-Seiten, Meldungen über verweigerten Zugriff oder absichtlich irreführende Daten anstelle von legitimen Inhalten.

Algorithmen zur Ratenbegrenzung verfolgen die Häufigkeit von Anfragen pro IP-Adresse, User-Agent-String usw. Mit diesen Informationen wird der Traffic gedrosselt oder blockiert, wenn er den Eindruck einer menschlichen Aktivität erweckt.

Serverseitige Rendering-Probleme

Beim Rendering auf dem Server mit Frameworks wie Next.js werden unterschiedliche HTML-Ausgaben auf der Grundlage verschiedener Kriterien erzeugt. Dieselbe URL kann völlig unterschiedliche Inhaltsstrukturen zurückgeben, abhängig von Faktoren, die Ihr Scraper nicht kontrolliert oder genau simuliert. Personalisierte Inhalte, geografisch abgegrenzte Informationen und benutzerspezifische Preise führen zu Szenarien, in denen Ihr Scraper andere Daten als die vorgesehenen Benutzer sieht.

Caching-Ebenen zwischen Ihrem Scraper und den Ursprungsservern führen zu zeitlichen Inkonsistenzen, bei denen kürzlich aktualisierte Inhalte Zeit brauchen, um sich über CDN-Knoten zu verbreiten. Ihr Scraper könnte veraltete Produktpreise, veraltete Lagerbestände oder zwischengespeicherte Fehlerseiten abrufen, die nicht den aktuellen Zustand der Website widerspiegeln. Edge-Server in verschiedenen geografischen Regionen können unterschiedliche Cache-Versionen bereitstellen, sodass die Datenkonsistenz davon abhängt, welcher Server auf Ihre Anfragen antwortet.

Datenbeschädigung auf Netzwerkebene

Instabile Netzwerkverbindungen, Proxy-Server-Probleme und DNS-Auflösungsprobleme führen zu subtilen Datenverfälschungen, die durch die Standardfehlerbehandlung nur schwer zu erkennen sind. Teilweise heruntergeladene Inhalte erzeugen abgeschnittene HTML-Antworten, die zwar erfolgreich geparst werden, aber wichtige Seitenabschnitte auslassen. Ihr Scraper empfängt möglicherweise die ersten 80 % einer Produktseite und scheint korrekt zu arbeiten, lässt aber systematisch Elemente aus, die am Ende längerer Seiten geladen werden.

Komprimierungsalgorithmen beschädigen gelegentlich die Daten während der Übertragung, insbesondere bei Verwendung rotierender Proxys mit unterschiedlichen Komprimierungseinstellungen.

Welche Auswirkungen haben ungenaue Daten auf Anwendungen?

Ungenaue Web-Scraping-Daten wirken sich auf Systeme in einer Weise aus, die die Geschäftslogik und das Benutzererlebnis grundlegend beeinträchtigt. Das Verständnis dieser Fehler hilft Entwicklern, widerstandsfähigere Datenpipelines und Validierungsschichten zu erstellen.

Verschlechterung von Analyse-Pipelines

Datenqualitätsprobleme treten am deutlichsten in Analysesystemen auf, wo Aggregationen die zugrunde liegenden Fehler verstärken. Wenn gescrapte E-Commerce-Preisdaten Parsing-Fehler enthalten, die aufgrund von Fehlern bei der Verarbeitung von Währungssymbolen “29,99 $” in “2999 $” umwandeln, werden Durchschnittspreisberechnungen sinnlos.

Datenbank-Joins können ohne Ihr Wissen fehlschlagen, wenn die ausgelesenen Produktbezeichner unsichtbare Unicode-Zeichen oder Leerzeichen am Ende enthalten. In einem Produktverfolgungssystem wird ein und derselbe Artikel möglicherweise als getrennte Einträge angezeigt, was die Bestandszahlen in die Höhe treibt und die Modelle für die Nachfrageprognose verzerrt. Diese Normalisierungsfehler sind überall in Ihren ETL-Prozessen zu finden und führen dazu, dass nachgelagerte Berichte den Umsatz verdoppeln.

Fehler im Entscheidungsfindungssystem

Automatisierte Entscheidungsfindungssysteme, die auf gescrapten Daten basieren, können katastrophale Fehlentscheidungen treffen, wenn sich die Qualität der Eingaben verschlechtert. Anwendungen zur Preisüberwachung, die sich auf Daten von Wettbewerbern aus dynamischen Websites stützen, erfassen häufig Platzhalterwerte wie “Loading…” oder JavaScript-Fehlermeldungen anstelle der tatsächlichen Preise. Wenn diese nicht numerischen Zeichenfolgen die Validierungsebenen umgehen, können die Preisalgorithmen auf Nullwerte zurückgreifen.

Wenn Sie an einer Recommendation Engine arbeiten, leiden Sie unter unvollständig gescrapten Datensätzen, bei denen bestimmte Produktkategorien aufgrund von Paginierungsproblemen oder Authentifizierungsbarrieren systematisch nicht erfasst werden. Die daraus resultierende Ausrichtung der Empfehlungen auf erfolgreich gescrapte Kategorien führt zu Echokammern, die die Entdeckung verschiedener Produkte durch die Kunden einschränken, was letztlich das Umsatzwachstum und die Kundenzufriedenheit beeinträchtigt.

Verschlechterung der Anwendungsleistung

Anwendungen, die gescrapte Daten verwenden, leiden unter Leistungsproblemen, wenn Datenqualitätsprobleme zu ineffizienten Datenbankoperationen führen. Ausgelesene Textfelder, die nicht abgeschnittene HTML-Tags enthalten, können die Suchindizierung beeinträchtigen, was zu vollständigen Tabellenscans anstelle von optimierten Indexsuchen führt. Benutzerorientierte Suchfunktionen reagieren nicht mehr, wenn sich diese Leistungseinbußen bei mehreren gleichzeitigen Abfragen häufen.

Cache-Invalidierungsstrategien schlagen fehl, wenn die gescrapten Daten inkonsistente Formatierungen enthalten, die eine Erkennung von Duplikaten unmöglich machen. Dieselben Produktinformationen, die zu verschiedenen Zeitpunkten abgefragt werden, können aufgrund der unterschiedlichen Behandlung von Leerzeichen als unterschiedliche Cache-Einträge erscheinen, was den Speicherverbrauch erhöht und die Cache-Trefferraten verringert. Diese Cache-Verschmutzung zwingt Anwendungen zu wiederholten teuren Datenbankaufrufen, was die Reaktionsfähigkeit des Systems insgesamt beeinträchtigt.

Probleme bei der Datenintegration

Die gescrapten Daten kommen selten isoliert an. In der Regel werden sie mit internen Datenbanken und APIs von Drittanbietern kombiniert, um umfassende Datensätze zu erstellen. Schemaabweichungen treten häufig auf, wenn sich die Feldstrukturen der gescrapten Daten aufgrund einer Neugestaltung der Website unerwartet ändern. Ein Produktkatalogsystem kann wichtige Spezifikationen verlieren, wenn sich die Scraping-Logik nicht an neue HTML-Layouts anpasst und nachgelagerte Anwendungen mit unvollständigen Produktinformationen zurücklässt, die sich auf Suchergebnisse und Kaufentscheidungen der Kunden auswirken.

Inkonsistenzen bei der Datenaktualität führen dazu, dass die gescrapten Daten andere Zeiträume widerspiegeln als die zugehörigen internen Daten. Finanzanwendungen, die gescrapte Marktdaten mit internen Transaktionsdatensätzen kombinieren, können falsche Portfoliobewertungen erzeugen, wenn Scraping-Verzögerungen dazu führen, dass die Preisinformationen hinter den Zeitstempeln der Transaktionen zurückbleiben. Diese zeitlichen Inkonsistenzen erschweren die Erstellung genauer Prüfpfade.

Verschiedene Möglichkeiten zur Verbesserung der Datengenauigkeit

Die Datengenauigkeit beim Web-Scraping hängt von der Implementierung mehrerer Techniken ab, die zusammenarbeiten, um verschiedene Fehlerpunkte in der Extraktionspipeline zu beheben.

Dynamische Inhalte mit Headless-Browsern verarbeiten

Herkömmlichen HTTP-basierten Scrapern entgehen beträchtliche Teile der Daten, da viele Websites stark auf JavaScript angewiesen sind, um Inhalte nach dem ersten Laden der Seite zu rendern. Headless-Browser wie Puppeteer oder Playwright führen JavaScript genau wie normale Browser aus und stellen sicher, dass Sie alle dynamisch generierten Inhalte erfassen.

Puppeteer bietet durch seine Chrome DevTools Protocol-Integration die Kontrolle über das Rendering von Seiten. Sie können auf die Fertigstellung bestimmter Netzwerkanforderungen warten, DOM-Änderungen überwachen und sogar API-Aufrufe abfangen, die Inhalte auffüllen. Dieser Ansatz erweist sich als besonders wertvoll für Single-Page-Anwendungen, die nach dem ersten Rendering Daten über AJAX-Anfragen laden.

Bei der Verwendung von Headless-Browsern sollten Sie Bilder, CSS und unnötige Plugins deaktivieren, um den Speicherverbrauch zu reduzieren und die Ladezeiten zu verbessern. Konfigurieren Sie die Größe des Ansichtsfensters entsprechend, da einige Websites je nach Bildschirmgröße unterschiedliche Inhalte wiedergeben.

Schnelle Anpassung an Änderungen der Website-Struktur

Website-Strukturen ändern sich häufig und behindern Scraper, die sich auf feste CSS-Selektoren oder XPath-Ausdrücke verlassen. Die Entwicklung adaptiver Scraper erfordert die Implementierung von Fallback-Strategien und Überwachungssystemen, die strukturelle Änderungen erkennen, bevor sie zu Datenverlusten führen.

Erstellen Sie Selektorhierarchien, die mehrere Ansätze zum Auffinden desselben Datenelements versuchen. Beginnen Sie mit dem spezifischsten Selektor und greifen Sie nach und nach auf allgemeinere Selektoren zurück.

class AdaptiveSelector:

def __init__(self, selectors_list, element_name):

self.selectors = selectors_list

self.element_name = element_name

self.successful_index = 0

def extract_data(self, soup):

for i, selector in enumerate(self.selectors[self.successful_index:], self.successful_index):

elements = soup.select(selector)

if elements:

self.successful_index = i

return [elem.get_text(strip=True) for elem in elements]

raise ValueError(f "Kein Selektor für {self.element_name} gefunden")

# Verwendung

preis_selektor = AdaptiveSelektor([

'div.preis-aktuell .preis-wert', # Sehr spezifisch

'.preis-aktuell', # Zwischenstufe

'[class*="price"]' # Broad fallback

], 'product_price')Implementierung von Systemen zur Erkennung von Änderungen, die Fingerabdrücke der Seitenstruktur im Laufe der Zeit vergleichen.

Validierung und Bereinigung der gescrapten Daten

Rohdaten enthalten viele Ungereimtheiten, die die Genauigkeit Ihrer Daten beeinträchtigen. Um dies zu beheben, müssen Sie eine umfassende Validierungs- und Bereinigungspipeline implementieren. Dadurch werden unordentliche Webdaten in zuverlässige Datensätze umgewandelt, die sich für die nachfolgende Verarbeitung eignen.

DieDatenvalidierung beginnt mit der Typ- und Formatüberprüfung. Preise sollten mit Währungsmustern übereinstimmen, Datumsangaben sollten korrekt geparst werden, und numerische Felder sollten gültige Zahlen enthalten.

import re

from datetime import datetime

from typing import Optional, Dict, Any

class DataValidator:

def __init__(self):

self.patterns = {

'preis': re.compile(r'[$€£¥]?[d,]+.?d*'),

'email': re.compile(r'^[a-zA-Z0-9._%+-]+@[a-zA-Z0-9.-]+.[a-zA-Z]{2,}$'),

'phone': re.compile(r'^+?[ds-()]{10,}$'),

'date': re.compile(r'd{4}-d{2}-d{2}|d{2}/d{2}/d{4}')

}

def validate_record(self, record: Dict[str, Any]) -> Dict[str, Any]:

cleaned_record = {}

for field, value in record.items():

if value is None oder str(value).strip() == '':

bereinigter_Datensatz[feld] = None

weiter

gereinigter_Wert = self._clean_field(feld, str(wert))

if self._is_valid_field(field, cleaned_value):

gereinigter_Datensatz[Feld] = gereinigter_Wert

sonst:

gereinigter_Datensatz[feld] = keine

return gereinigter_Datensatz

def _clean_field(self, field_name: str, value: str) -> str:

# Extra Leerzeichen entfernen

cleaned = re.sub(r's+', ' ', value.strip())

# Bereinigungslogik

return gereinigt

def _is_valid_field(self, field_name: str, value: str) -> bool:

if 'preis' in feld_name.lower():

return bool(self.patterns['price'].match(value))

elif 'email' in feld_name.niedriger():

return bool(self.patterns['email'].match(value))

# Weitere feldspezifische Überprüfungen hinzufügen

return len(Wert) > 0Implementieren Sie eine Ausreißererkennung, um verdächtige Datenpunkte zu identifizieren, die auf Scraping-Fehler hindeuten könnten. Statistische Methoden wie die Analyse des Interquartilsbereichs helfen, Preise, Mengen oder andere numerische Werte zu erkennen, die außerhalb der erwarteten Bereiche liegen. Algorithmen zur Ähnlichkeit von Zeichenfolgen können beschädigte Textfelder oder Extraktionsfehler erkennen.

Implementierung von Fehlerbehandlung und Wiederholungsversuchen

Netzwerkausfälle, Serverfehler und Parsing-Ausnahmen sind bei Web-Scraping-Vorgängen unvermeidlich. Durch eine umfassende Fehlerbehandlung in Ihrem Web Scraper wird verhindert, dass einzelne Fehler zu kompletten Scraper-Ausfällen führen, während Wiederholungsmechanismen vorübergehende Probleme automatisch behandeln.

Exponentielles Backoff ist eine wirksame Strategie für den Umgang mit Ratenbegrenzungen und vorübergehender Serverüberlastung. Beginnen Sie mit kurzen Verzögerungen und erhöhen Sie schrittweise die Wartezeiten für nachfolgende Wiederholungsversuche. Dieser Ansatz gibt den Servern Zeit, sich zu erholen, und vermeidet aggressive Wiederholungsmuster, die Anti-Bot-Maßnahmen auslösen könnten.

asyncio importieren

importiere aiohttp

from typing import Optional, Callable

class ResilientScraper:

def __init__(self, max_attempts=3, base_delay=1.0):

self.max_attempts = max_attempts

self.base_delay = base_delay

self.session = Keine

async def fetch_with_retry(self, url: str, parse_func: Callable) -> Optional[Any]:

for attempt in range(self.max_attempts):

try:

if attempt > 0:

delay = self.base_delay * (2 ** attempt)

await asyncio.sleep(delay)

async mit self.session.get(url) als Antwort:

if response.status == 200:

content = await response.text()

return parse_func(Inhalt)

elif response.status == 429: # Rate begrenzt

weiter

elif response.status >= 500: # Serverfehler

weiter

else: # Client-Fehler

return Keine

except (aiohttp.ClientError, asyncio.TimeoutError):

continue

return KeineCircuit-Breaker-Muster verhindern, dass Scraper ausfallende Dienste überfordern. Verfolgen Sie die Fehlerraten für einzelne Domains und deaktivieren Sie vorübergehend Anfragen, wenn die Fehlerraten akzeptable Schwellenwerte überschreiten. Dieser Ansatz schützt sowohl Ihren Scraper als auch die Ziel-Website vor unnötiger Belastung bei Ausfällen.

Verwenden Sie rotierende Proxys und User Agents

IP-Blockierung ist eines der häufigsten Hindernisse beim Web-Scraping. Rotierende Proxys und User Agents verteilen die Anfragen auf verschiedene offensichtliche Quellen, was die Erkennung erheblich erschwert und gleichzeitig die Scraping-Geschwindigkeit aufrechterhält.

Die Proxy-Rotation erfordert eine sorgfältige Verwaltung der Verbindungspools und der Verteilung der Anfragen. Vermeiden Sie die Verwendung desselben Proxys für aufeinanderfolgende Anfragen an dieselbe Domäne, da dieses Muster nachweisbar bleibt. Implementieren Sie stattdessen Round-Robin- oder Zufallsauswahlalgorithmen, die eine gleichmäßige Verteilung über Ihren Proxy-Pool sicherstellen.

importieren random

from typing import List, Dict, Optional

class ProxyRotator:

def __init__(self, proxies: List[str], user_agents: List[str]):

self.proxies = proxies

self.user_agents = user_agents

self.failed_proxies = set()

def get_next_proxy_and_headers(self) -> tuple[Optional[str], Dict[str, str]]:

available_proxies = [p for p in self.proxies if p not in self.failed_proxies]

if not available_proxies:

self.failed_proxies.clear()

available_proxies = self.proxies

proxy = random.choice(available_proxies)

user_agent = random.choice(self.user_agents)

headers = {

'Benutzer-Agent': user_agent,

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

Accept-Language': 'en-US,de;q=0.5',

'Verbindung': 'keep-alive'

}

return proxy, headers

def mark_proxy_failed(self, proxy: str):

self.failed_proxies.add(proxy)Die Rotation der Benutzer-Agenten sollte eine realistische Browser-Verteilung nachahmen, wie sie in Webanalyse-Daten zu finden ist. Gewichten Sie Ihre User-Agent-Liste nach den tatsächlichen Marktanteilsstatistiken und stellen Sie sicher, dass Chrome-Varianten häufiger vorkommen als weniger verbreitete Browser. Fügen Sie mobile User Agents für Websites hinzu, die unterschiedliche Inhalte für mobile Geräte bereitstellen.

KI-gesteuerte Proxy-Verwaltung

Beim Scraping von Daten werden IP-Sperren zu einer Herausforderung, die Ihren Betrieb komplett zum Erliegen bringen kann. Wenn Sie z. B. auf einer Reise-Website nach Flugpreisen suchen, können Websites leicht mehrere Anfragen erkennen, die mit hoher Geschwindigkeit von derselben IP-Adresse kommen, so dass es für sie ein Leichtes ist, Ihren Scraper zu kennzeichnen und zu sperren.

Die Lösung liegt in einer KI-gesteuerten Proxy-Verwaltung und nicht in einer einfachen Proxy-Rotation. Bei diesem Ansatz wird ein Pool von Proxys verwendet, um die Anfragen auf verschiedene IP-Adressen zu verteilen und so Ihre Identität effektiv zu verschleiern. Professionelle Dienste wie Bright Data bieten Zugang zu über 150 Millionen Residential-IPs aus etwa 195 Ländern.

Ein intelligentes Proxy-Management bietet mehrere wichtige Vorteile. Es gewährleistet Anonymität, so dass Websites verdächtige Aktivitäten nicht direkt zu Ihnen zurückverfolgen können, und implementiert eine dynamische Ratenbegrenzung, die die Häufigkeit von Anfragen anpasst, um menschliches Verhalten zu imitieren.

Diese Strategien wirken zusammen, um Scraper zu entwickeln, die die Datengenauigkeit in verschiedenen Webumgebungen aufrechterhalten. Headless-Browser erfassen den gesamten Inhalt, adaptive Selektoren verarbeiten strukturelle Änderungen, Validierungspipelines bereinigen die extrahierten Daten, eine umfassende Fehlerbehandlung verhindert Ausfälle und das KI-gesteuerte Proxy-Management optimiert die Bereitstellung.

Tools und Best Practices für zuverlässiges Scraping

Die Auswahl des richtigen Scraping-Tools hängt von der Komplexität Ihrer Zielwebsites und Ihren Anforderungen an die Skalierbarkeit ab. In diesem Abschnitt werden vier Kategorien von Tools untersucht, die unterschiedliche technische Herausforderungen beim Web-Scraping angehen.

Python-Bibliotheken für statische Inhalte

Beautiful Soup eignet sich hervorragend für das Parsing von HTML-Dokumenten, deren Inhalt direkt in der ersten Serverantwort geladen wird. Die Bibliothek kommt mit fehlerhaftem HTML gut zurecht und bietet intuitive Navigationsmethoden für die Extraktion von Daten aus verschachtelten Elementen. Requests passt natürlich zu Beautiful Soup, wenn es um die Handhabung von Site-Eigenschaften geht, die viele Websites für den richtigen Datenzugriff benötigen.

Scrapy arbeitet als komplettes Framework und nicht als einfache Bibliothek. Es verwaltet gleichzeitige Anfragen durch seinen eingebauten Scheduler und verarbeitet komplexe Crawling-Szenarien durch seine Pipeline-Architektur. Sie können das Middleware-System für benutzerdefinierte Anfrageverarbeitung, User-Agent-Rotation und automatische Wiederholungsmechanismen nutzen.

Browser-Automatisierung für dynamische Inhalte

Selenium steuert reale Browser über WebDriver-Protokolle und eignet sich daher für Websites, die bei der Darstellung von Inhalten stark von der Ausführung von JavaScript abhängen. Das Tool verarbeitet Benutzerinteraktionen wie das Einreichen von Formularen, das Anklicken von Schaltflächen und das Umblättern von Seiten, die das Laden zusätzlicher Inhalte auslösen. Sie müssen Ihre Wartebedingungen explizit eingeben, um die Ausführung zu unterbrechen, bis bestimmte Elemente verfügbar sind oder bestimmte Kriterien erfüllen.

Playwright bietet ähnliche Funktionen für die Browser-Automatisierung mit verbesserten Leistungsmerkmalen und integrierter Handhabung für moderne Webfunktionen. Die automatische Wartefunktion des Tools beseitigt die meisten Timing-Probleme, indem automatisch gewartet wird, bis Elemente verfügbar sind, bevor mit Interaktionen fortgefahren wird. Playwrights Funktionen zum Abfangen von Netzwerken ermöglichen es Ihnen, API-Aufrufe zu überwachen, die den Seiteninhalt auffüllen, was oft effizientere Methoden für den Datenzugriff offenbart als das Parsen von gerendertem HTML.

Headless-Browser-Lösungen

Puppeteer zielt speziell auf Chromium-basierte Browser ab und bietet durch seine DevTools Protocol-Integration eine gute Kontrolle über das Browserverhalten. Das Tool zeichnet sich neben der Datenextraktion durch die Erstellung von Screenshots, PDFs und Leistungsmetriken aus. Es verfügt über eine Funktion zum Abfangen von Anfragen, mit der Sie unnötige Ressourcen wie Bilder und Stylesheets blockieren und die Scraping-Geschwindigkeit für die Extraktion von Inhalten verbessern können.

Playwright ist eine browserübergreifende Funktion, die es für das Scraping über verschiedene Rendering-Engines hinweg wertvoll macht. Die Codegen-Funktion des Tools zeichnet Benutzerinteraktionen auf und generiert entsprechende Automatisierungsskripte.

Proxy-Management-Plattformen für Unternehmen

Bright Data bietet die Rotation von Wohn-IPs über globale Standorte hinweg mit Sitzungspersistenzfunktionen, die konsistente Identitäten während Scraping-Sitzungen auf mehreren Seiten aufrechterhalten. Der Web Unlocker Service handhabt automatisch gängige Anti-Bot-Maßnahmen, einschließlich CAPTCHA-Lösung und Browser-Fingerprint-Randomisierung. Der Scraping-Browser kombiniert Proxy-Rotation mit vorkonfigurierten Browser-Instanzen, die für die Vermeidung von Erkennung optimiert sind.

Anforderungsmanagement und Ratenbegrenzung

Die Implementierung von Backoff-Strategien verhindert, dass die Zielserver überlastet werden, während vorübergehende Ausfälle angemessen behandelt werden. So bietet beispielsweise urllib3, einer der führenden Python-HTTP-Clients, Wiederholungsmechanismen mit konfigurierbaren Verzögerungen zwischen den Versuchen. Eine benutzerdefinierte Ratenbegrenzung unter Verwendung von Token-Bucket-Algorithmen stellt sicher, dass die Abstände zwischen den Anfragen der Serverkapazität entsprechen, anstatt feste Verzögerungen anzuwenden, die entweder zu aggressiv oder unzureichend sein können.

Die Sitzungsverwaltung kann für Websites wichtig werden, die eine Authentifizierung oder die Beibehaltung des Status über mehrere Anfragen hinweg erfordern. Persistente Cookie-Speicherung und Header-Verwaltung stellen sicher, dass Scraper auch bei längeren Scraping-Sitzungen Zugriff auf geschützte Inhalte haben. Verbindungspooling reduziert den Overhead durch die Wiederverwendung bestehender Netzwerkverbindungen bei mehreren Anfragen an dieselbe Domain.

Datenüberprüfung

Schema-Validierungsbibliotheken wie Pydantic sorgen für eine konsistente Datenstruktur und fangen Parsing-Fehler ab, bevor sie sich in den Verarbeitungspipelines ausbreiten. Die Implementierung einer Prüfsummenvalidierung für gescrappte Inhalte hilft dabei, zu erkennen, wenn Websites ihre Struktur oder Inhaltsformatierung ändern, und löst Warnmeldungen für die Scraper-Wartung aus.

Die Wahl zwischen diesen Tools hängt von Ihren spezifischen technischen Anforderungen ab. So bieten beispielsweise Scraper für statische Inhalte maximale Leistung für einfache Extraktionsaufgaben, während Browser-Automatisierungstools komplexe interaktive Szenarien auf Kosten eines erhöhten Ressourcenverbrauchs bewältigen.

Fazit

In diesem Artikel haben wir die Herausforderungen kennengelernt, mit denen Entwickler beim Scrapen von Daten aus Websites konfrontiert werden, und wir haben die Ergebnisse von schlechtem Scraping identifiziert. Schließlich haben wir Tools und Strategien kennengelernt, die Ihnen bei der Lösung dieser Probleme helfen können.