Dieser ausführliche Leitfaden behandelt Folgendes:

- Die Definition eines Web-Scraping-Tools

- Worauf Sie beim Vergleich der besten Scraping-Tools achten sollten

- Welche sind die besten Web-Scraping-Tools?

Legen wir also gleich los!

Was ist ein Web-Scraping-Tool?

Bei einem Web-Scraping-Tool handelt es sich um eine Bibliothek, Software oder einen Service, der die automatische Extraktion von Daten aus einer Website vereinfacht. Anders ausgedrückt: Es erleichtert die Durchführung von Web-Scraping.

Heutzutage wissen Unternehmen, wie wertvoll Daten sind, daher pflegen sie diese zu schützen, selbst wenn sie auf ihren Websites öffentlich zugänglich sind. Sie wollen sie einfach nicht umsonst herausgeben. Aus diesem Grund führen immer mehr Websites Anti-Scraping-Lösungen ein. Einige der effektivsten Lösungen, die Sie kennen sollten, sind CAPTCHAs, Fingerprinting und Ratenbegrenzung.

Wenn diese Lösungen nicht angemessen eingesetzt werden, können sie Ihre Datenerfassung leicht stoppen. Web-Scraping-Tools sind eben genau darauf ausgerichtet, diese Lösungen weniger effektiv umzusetzen. Im Wesentlichen rüsten diese Tools Sie mit sämtlichen Funktionen aus, die Sie benötigen, um problemlos Daten von einer Website zu sammeln.

Doch zunächst einmal wollen wir herausfinden, wie man die besten Web-Scraping-Tools auswählt.

Zu berücksichtigende Aspekte bei der Bewertung der besten Web-Scraping-Tools

Im Folgenden finden Sie die wichtigsten Elemente, die Sie beim Vergleich der besten Web-Scraping-Tools berücksichtigen sollten:

- Vor- und Nachteile: Die Hauptvor- und -nachteile, die mit dem analysierten Scraping-Tool verbunden sind.

- Funktionen: Eine Übersicht der von dem Tool angebotenen Funktionen.

- Kosten: Kosten für den einfachsten Premium-Plan des Scraping-Tools

- Hauptziel: In knappen Worten, wozu das Tool nützlich ist.

- Plattformen: Für welche Betriebssysteme das Tool verfügbar ist.

- Bewertungen: Die Bewertung des Tools durch Nutzer auf Websites wie Capterra.

- Integrationen: Mit welchen Technologien, Tools und Programmiersprachen die Tools eingesetzt werden können.

Werfen wir nun einen Blick auf die Liste der besten Scraping-Bibliotheken, -Technologien und -Tools auf dem Markt!

Die 11 besten Web-Scraping-Tools

Erfahren Sie, welche Tools die besten für das Web-Scraping von Daten aus dem Internet sind und warum sie hier auf der Liste aufgeführt sind.

1. Bright Data!

Bright Data nimmt in der Branche der Web-Datenerfassung eine führende Position ein und verwaltet weltweit ein umfangreiches und vielfältiges Proxy-Netzwerk. Dieses Netzwerk umfasst Millionen von Residential-Proxys, die sich hervorragend für die Durchführung von IP-Rotationsstrategien anbieten, welche für erfolgreiches Web-Scraping unerlässlich sind.

Auf dieser Infrastruktur gestützt, bietet Bright Data eine Vielzahl von Web-Scraping-Tools und -Services an, darunter seine Web-Scraper-APIs. Dieses Cloud-basierte Tool bietet anpassbare API-Endpunkte, die zur Extraktion von Webdaten aus gängigen Domains entwickelt wurden und den komplexen Anforderungen von Datenerfassungsprojekten entsprechen.

Die Web Scraper-APIs wurden für eine hohe Skalierbarkeit und Zuverlässigkeit ausgelegt und bewältigen häufig auftretende technische Problembereiche beim Web-Scraping, wie zum Beispiel die Umgehung von Anti-Bot-Mechanismen.

Somit wird sie zur bevorzugten Scraping-Lösung für Unternehmen, die ihre datengesteuerten Initiativen optimieren und gleichzeitig die Betriebskosten senken sowie die Effizienz bei der Erfassung von Webdaten steigern möchten.

- IP-Rotation über Proxys

- Automatische CAPTCHA-Auflösung

- Rotation von User-Agents

- JavaScript-Rendering-Funktionen

- Datenexport in für Menschen lesbare Formate

Anders ausgedrückt: Scraper API vereint die besten Web-Scraping-Tools in einem einzigen Service. Dadurch wird es zur idealen Lösung, um die Herausforderungen des Scrapings zu umgehen, die Gesamtkosten zu senken und gleichzeitig Zeit zu sparen.

👍 Vorteile:

👍 Vorteile:

- 99.9 % Verfügbarkeit

- Unbegrenzte Skalierbarkeit

- 100 % rechtskonform und ethisch unbedenklich

- Menschliche Unterstützung rund um die Uhr

👎 Nachteile:

👎 Nachteile:

- Nicht kostenlos

💰 Kosten:

💰 Kosten:

Die Tarife richten sich nach der Anzahl der Datensätze und der Art der Domain. Ab 0,001 $.

Kostenlose Testversion verfügbar.

🛠️F unktionen:

🛠️F unktionen:

- Bearbeitung von Massenanfragen

- Sofort einsatzbereite API-Endpunkte

- Skalierbare Infrastruktur

- Datenerkennung

- Automatisches Parsen

- Datenüberprüfung

- Automatische IP-Rotation

- Benutzerdefinierte Header

- CAPTCHA-Auflösung

- Javascript-Rendering

- User-Agent-Rotation

- Proxies von Privatanwender

- Webhook-Zustellung

🎯 Hauptziel: Bereitstellung eines konfigurierbaren Endpunkts, der die in einer Webseite enthaltenen Daten in strukturiertem Format zurückliefert. Gleichermaßen kann er den HTML-Quelltext einer beliebigen Seite zurücksenden, selbst wenn diese durch Anti-Bot-Maßnahmen abgeschirmt ist

🎯 Hauptziel: Bereitstellung eines konfigurierbaren Endpunkts, der die in einer Webseite enthaltenen Daten in strukturiertem Format zurückliefert. Gleichermaßen kann er den HTML-Quelltext einer beliebigen Seite zurücksenden, selbst wenn diese durch Anti-Bot-Maßnahmen abgeschirmt ist

💻 Plattformen: Windows, macOS, Linux

💻 Plattformen: Windows, macOS, Linux

💬 Bewertungen: 4,8/5 auf Capterra

💬 Bewertungen: 4,8/5 auf Capterra

⚙️ Integrationen:

Integrationen:

- Jegliche für die Webentwicklung geeignete Programmiersprache (z. B. JavaScript, Python, Java, Rust, Go, C#, usw.)

- Jeder HTTP-Client

- Jede Scraping-Bibliothek

2. ScrapingBee

ScrapingBee bietet eine hochwertige Web-Scraping-API, welche die Datenextraktion im Internet vereinfacht. Sie verwaltet insbesondere Proxys und die Headless-Browser-Konfiguration für Sie, sodass Sie sich auf die Datenextraktion konzentrieren können. Zur Zielgruppe gehören Entwickler, die den Scraping-Endpunkt in ihre Skripte integrieren werden. Diese API greift auf einen umfassenden Pool von Proxys zu, um Ratenbegrenzungen zu umgehen und das Risiko einer Sperrung zu verringern.

👍 Vorteile:

👍 Vorteile:

- Ihnen werden lediglich erfolgreiche Anfragen in Rechnung gestellt

- Ausführliche Dokumentation und eine Fülle von Blogbeiträgen

- Einfach zu konfigurierender Scraping-Endpunkt

- Zahlreiche Funktionen

- Auf den meisten Websites effektiv

👎 Nachteile:

👎 Nachteile:

- Nicht die schnellste Scraping-API

- Eingeschränkte Parallelität

- Erfordert Fachwissen

🛠️F unktionen:

🛠️F unktionen:

- Unterstützung für interaktive Websites, die das Ausführen von JavaScript erfordern

- Automatische Umgehung des Anti-Bot-Systems, einschließlich der Auflösung von CAPTCHA

- Anpassbare Header und Cookies

- Geografische Ausrichtung

- Abfangen von XHR/AJAX-Anfragen

- Datenexport in HTML, JSON, XML und mehr

- Planung von Scraping-API-Aufrufen

💰 Kosten: 49 $ pro Monat für den Einstiegsplan (begrenzte kostenlose Testversion verfügbar)

💰 Kosten: 49 $ pro Monat für den Einstiegsplan (begrenzte kostenlose Testversion verfügbar)

🎯 Hauptziel: Bereitstellung eines umfassenden Endpunkts, über den Entwickler Daten von jeder beliebigen Website extrahieren können

🎯 Hauptziel: Bereitstellung eines umfassenden Endpunkts, über den Entwickler Daten von jeder beliebigen Website extrahieren können

💻 Plattformen: Windows, macOS, Linux

💻 Plattformen: Windows, macOS, Linux

💬 Bewertungen: 4,9/5 auf Capterra

Bewertungen: 4,9/5 auf Capterra

⚙️ Integrationen:

Integrationen:

- Jeder HTTP-Client

- Jede Web-Scraping-Bibliothek

3. Octoparse

Octoparse gehört zu den besten Web-Scraping-Tools in der No-Code-Kategorie. Sie bietet eine Scraping-Software, die unstrukturierte Daten von beliebigen Websites abrufen und in strukturierte Datensätze umwandeln kann. Die Festlegung der Datenextraktionsaufgaben basiert auf einer einfachen Point-and-Click-Benutzeroberfläche, die auch für technisch weniger versierte Benutzer gedacht ist.

👍 Vorteile:

👍 Vorteile:

- No-Code Scraping-Tool

- Unmengen von Integrationen

- Sowohl kostenloser Plan als auch kostenlose Testversion für erweiterte Funktionen

- Dokumentation und Hilfecenter sind in mehreren Sprachen verfügbar, darunter Spanisch, Chinesisch, Französisch und Italienisch

- OpenAPI-Unterstützung

- Bewältigt für Sie Scraping-Herausforderungen

👎 Nachteile:

👎 Nachteile:

- Keine Linux-Unterstützung

- Einige nur schwer verständliche Funktionen

🛠️F unktionen:

🛠️F unktionen:

- Automatische Schleifenfunktionen

- Zahlreiche Vorlagen zum Scrapen von Daten aus beliebten Websites

- KI-gesteuerter Assistent für Web-Scraping

- Cloud-Automatisierung rund um die Uhr zur Planung von Scrapern

- Scraping-Herausforderungen mit IP-Rotation, CAPTCHA-Auflösung

- Automatische IP-Rotation und CAPTCHA-Auflösung

- Unterstützung für endloses Scrollen, Paginierung, Dropdown, Hover und zahlreiche andere Simulationen

💰 Kosten: 75 $ pro Monat für den Premium-Einstiegsplan (kostenloser Plan und Testversion verfügbar)

Kosten: 75 $ pro Monat für den Premium-Einstiegsplan (kostenloser Plan und Testversion verfügbar)

🎯 Hauptziel: Bereitstellung einer Desktop-Anwendung, mit der auch technisch nicht versierte Benutzer Web-Scraping durchführen können, wobei für Entwickler fortgeschrittene Integrationen verfügbar sind.

🎯 Hauptziel: Bereitstellung einer Desktop-Anwendung, mit der auch technisch nicht versierte Benutzer Web-Scraping durchführen können, wobei für Entwickler fortgeschrittene Integrationen verfügbar sind.

💻 Plattformen: Windows, macOS

💻 Plattformen: Windows, macOS

💬 Bewertungen: 4.5/5 auf Capterra

Bewertungen: 4.5/5 auf Capterra

⚙️ Integrationen:

Integrationen:

- Zapier

- Google Drive

- Google Sheets

- Benutzerdefinierte Proxy-Anbieter

- Cloudmersive API

- Airtable

- Dropbox

- Slack

- Hubspot

- Salesforce

4. ScraperAPI

ScraperAPI ist ein Web-Scraping-Tool, mit dem Sie den HTML-Code jeder beliebigen Webseite abrufen können, selbst wenn diese durch Anti-Scraping-Systeme geschützt ist. Aufgrund seines fortschrittlichen Anti-Bot-Erkennungs- und Umgehungssystems kann es eine Verbindung zu den meisten Websites herstellen, ohne dass Ihre Anfragen blockiert werden. Diese Scraping-API gewährleistet unbegrenzte Bandbreite für schnelle Web-Crawler.

👍 Vorteile:

👍 Vorteile:

- Ausführliche Dokumentation in diversen Programmiersprachen

- Über 10k Kunden

- Kostenlose Webinare, Fallstudien und Ressourcen für den Einstieg in die Nutzung des Tools

- Unbegrenzte Bandbreite

- 99,9 % garantierte Verfügbarkeit

- Kompetente Unterstützung

👎 Nachteile:

👎 Nachteile:

- Weltweites Geotargeting ausschließlich im Business-Plan verfügbar

- Erfordert Fachwissen

🛠️F unktionen:

🛠️F unktionen:

- JavaScript-Rendering-Funktionen

- Unterstützung Premium-Proxys

- Automatische JSON-Parsing-Funktionalität

- Intelligente Proxy-Rotation

- Benutzerdefinierte Header

- Automatische Wiederholungen

- Unterstützung für benutzerdefinierte Sitzungen

- Umgehung von CAPTCHA und Anti-Bot-Erkennung

💰 Kosten: 49 $ pro Monat für den Premium-Einsteigerplan (begrenzte kostenlose Testversion verfügbar)

💰 Kosten: 49 $ pro Monat für den Premium-Einsteigerplan (begrenzte kostenlose Testversion verfügbar)

🎯 Hauptziel: Bereitstellung eines umfassenden Scraping-Endpunkts, über den Entwickler Daten von jeder beliebigen Webseite abrufen können

🎯 Hauptziel: Bereitstellung eines umfassenden Scraping-Endpunkts, über den Entwickler Daten von jeder beliebigen Webseite abrufen können

💻 Plattformen: Windows, macOS, Linux

💻 Plattformen: Windows, macOS, Linux

💬 Bewertungen: 4,6/5 auf Capterra

Bewertungen: 4,6/5 auf Capterra

⚙️ Integrationen:

Integrationen:

- Jeder HTTP-Client

- Jede Web-Scraping-Bibliothek

5. Playwright

Playwright gilt als eine der besten Headless-Browser-Bibliotheken. Sie wird von Microsoft verwaltet und zählt mehr als 60k Sterne auf GitHub!

Playwright stellt eine umfassende API für E2E-Tests und Web-Scraping bereit. Sie bietet vor allem eine funktionsreiche Erfahrung zur nahtlosen Steuerung von Browsern und zur Simulation von Benutzerinteraktionen auf Websites. Dies macht Playwright zum idealen Instrument zum Scraping von Daten aus Websites mit dynamischen Inhalten, die JavaScript zum Rendern oder Abrufen von Daten verwenden. Ein besonderes Merkmal von Playwright ist seine konsistente sprach-, browser- und plattformübergreifende Natur.

Erleben Sie es in Aktion in unserem Artikel über Web-Scraping mit Playwright.

👍 Vorteile:

👍 Vorteile:

- Das derzeit vollständigste Tool zur Browser-Automatisierung

- Von Microsoft entwickelt und gewartet

- Plattform-, Browser- und Sprach-übergreifend

- Modern, schnell und leistungsfähig

- Eine beachtliche Anzahl von Funktionen, einschließlich automatischer Wartezeiten, visuellem Debugging, Wiederholungen, konfigurierbaren Reportern und vielem mehr

- Intuitive und sprach konsistente API

👎 Nachteile:

👎 Nachteile:

- Die Einrichtung ist nicht ganz einfach

- Die Beherrschung aller Funktionen erfordert Zeit

💰 Kosten: Kostenlos

Kosten: Kostenlos

🎯 Hauptziel: Automatisierung von Vorgängen in einem Browser durch programmgesteuerte Simulation von Benutzerinteraktionen

🎯 Hauptziel: Automatisierung von Vorgängen in einem Browser durch programmgesteuerte Simulation von Benutzerinteraktionen

💻 Plattformen: Windows, macOS, Linux

💻 Plattformen: Windows, macOS, Linux

🛠️F unktionen:

🛠️F unktionen:

- Simulation von Webbrowser-Interaktionen, einschließlich Navigation, Ausfüllen von Formularen und Datenextraktion

- APIs für das Klicken, Tippen, Ausfüllen von Formularen und mehr

- Sowohl Headed- als auch Headless-Unterstützung

- Native Unterstützung für die parallele Testausführung über mehrere Browserinstanzen hinweg

- Integrierte Debugging-Funktionen

- Integrierte Reporter

- Automatisch wartendes API

💬 Bewertungen: –

💬 Bewertungen: –

⚙️ Integrationen:

Integrationen:

- JavaScript und TypeScript

- Java

- .NET

- Python

- Chrome, Edge, Chromium-basierte Browser, Firefox, Safari, WebKit-basierte Browser

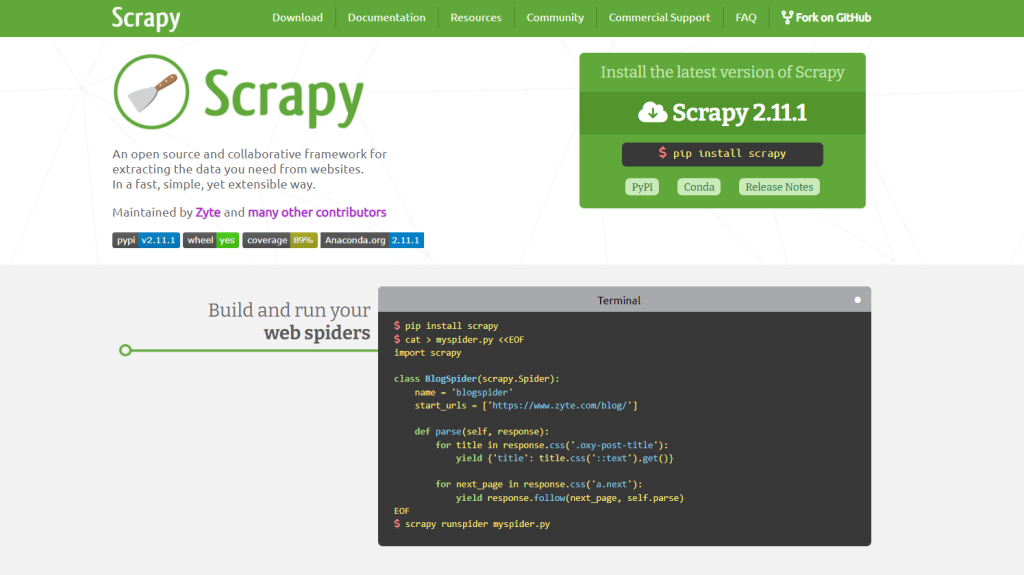

6. Scrapy

Scrapy ist ein Open-Source-Framework mit einer umfassenden API für Web-Scraping und -Crawling in Python. Damit lassen sich automatisierte und effiziente Aufgaben für das Crawlen von Websites und das Extrahieren strukturierter Daten aus deren Seiten definieren.

Erfahren Sie in unserem Leitfaden zu Web-Crawling in Python mit Scrapy, wie Sie dieses Framework verwenden können.

👍 Vorteile:

- Hochleistungsfähiges Crawling- und Scraping-Framework

- Hervorragend geeignet für den Abruf großer Datenmengen

- Speichereffizient

- Äußerst anpassbar

- Über Middleware erweiterbar

- Reibungsloses Web-Scraping-Erlebnis

👎 Nachteile:

👎 Nachteile:

- Das Scraping interagierender Websites erfordert die Integration von Splash

- Keine integrierten Browser-Automatisierungsfunktionen

- Steile Lernkurve

🛠️ Funktionen:

Funktionen:

- Unterstützung von CSS-Selektoren und XPath-Ausdrücken

- Integrierter HTML-Parser

- Eingebauter HTTP-Client

- Automatische Crawling-Logik

- JSON-Parsing

💰 Kosten: Kostenlos

Kosten: Kostenlos

🎯 Hauptziel: Bereitstellung einer hochwertigen Web-Crawling und -Scraping-API für Python

🎯 Hauptziel: Bereitstellung einer hochwertigen Web-Crawling und -Scraping-API für Python

💻 Plattformen: Windows, macOS, Linux

💻 Plattformen: Windows, macOS, Linux

💬 Bewertungen: –

Bewertungen: –

⚙️ Integrationen:

Integrationen:

- Python

- Splash

7. Apify

Apify ist eine Plattform zur Durchführung von Scraping-Aufgaben. Sie bietet Tausende von vorgefertigten Web-Scrapern, unterstützt aber auch kundenspezifische Skripte in Python und JavaScript. Die Apify-Plattform verwandelt jede Website in eine API und ermöglicht die zuverlässige Extraktion von Daten in jedem beliebigen Umfang. Apify ist das Team hinter Crawlee, der beliebten Node.js-Bibliothek für Web-Scraping.

👍 Vorteile:

👍 Vorteile:

- Kostenlose Web-Scraping-Kurse, -Akademien und -Tutorials

- Ausführliche Dokumentation

- Integrierter Proxy-Pool

- Unmengen von Integrationen

- Über 1.5k vorgefertigte Web-Scraper-Vorlagen

- Von einer Vielzahl namhafter Partner vertraut

👎 Nachteile:

👎 Nachteile:

- Nicht gerade der beste Kundensupport

- Eingeschränkte Parallelität

🛠️ Funktionen:

Funktionen:

- Intelligente IP-Adressen-Rotation

- Automatische menschenähnliche Browser-Fingerprints

- Benutzerdefinierte Cookies und Header

- Integriertes Toolkit zur Umgehung von Anti-Bots

- Integration mit Python und JavaScript, einschließlich Playwright, Puppeteer, Selenium und Scrapy

💰 Kosten: 49 $ pro Monat für den Premium-Einsteigerplan (kostenlose Testversion verfügbar)

💰 Kosten: 49 $ pro Monat für den Premium-Einsteigerplan (kostenlose Testversion verfügbar)

🎯 Hauptziel: Bereitstellung einer Online-Plattform, über die Entwickler Scraping-Aufgaben erstellen, einsetzen und verwalten können

Hauptziel: Bereitstellung einer Online-Plattform, über die Entwickler Scraping-Aufgaben erstellen, einsetzen und verwalten können

💻 Plattformen: Windows, macOS, Linux

Plattformen: Windows, macOS, Linux

💬 Bewertungen: 4,8/5 auf Capterra

💬 Bewertungen: 4,8/5 auf Capterra

⚙️ Integrationen:

Integrationen:

- Jede Web-Scraping-Bibliothek

- Google Drive

- Asana

- GitHub

- Slack

- Gmail

- Zapier

8. ParseHub

ParseHub ist eine No-Code-Desktop-Anwendung für Web-Scraping, mit der man Daten einer Website über eine Point-and-Click-Schnittstelle abrufen kann. Mit diesem Web-Scraping-Tool lassen sich vollständige Aufgaben zur Datenextraktion in drei Schritten festlegen:

- Öffnen Sie Seiten in einem integrierten Browser

- Wählen Sie per Mausklick die zu extrahierenden Elemente aus und legen Sie fest, welche Daten extrahiert werden sollen

- Exportieren Sie die gescrapten Daten in für Menschen lesbare Formate wie CSV oder JSON.

👍 Vorteile:

- No-Code Aufgabenstellung für Web-Scraping

- Plattformübergreifend

- Plattformübergreifend Intuitive UI und UX

- Nahtlose Cloud-Integration

👎 Nachteile:

👎 Nachteile:

- Rechenintensiv

- Nicht für groß angelegte Einsätze geeignet

🛠️F unktionen:

🛠️F unktionen:

- Geplante Abläufe

- Automatische IP-Rotation

- Unterstützung für interaktive Websites

- Unterstützung für bedingte Anweisungen und Ausdrücke

- Unterstützt XPath, RegEx und CSS-Selektoren

- Automatische Datenextraktion aus Tabellen

- Datenextraktion aus Node-Text und HTML-Attributen

- REST API und Web-Hooks

💰 Kosten: 189 $ pro Monat für den einfachsten Premium-Plan (kostenloser Plan verfügbar)

Kosten: 189 $ pro Monat für den einfachsten Premium-Plan (kostenloser Plan verfügbar)

🎯 Hauptziel: Bereitstellung einer No-Code-Desktop-Anwendung, die es auch technisch nicht versierten Benutzern ermöglicht, Web-Scraping durchzuführen

🎯 Hauptziel: Bereitstellung einer No-Code-Desktop-Anwendung, die es auch technisch nicht versierten Benutzern ermöglicht, Web-Scraping durchzuführen

💻 Plattformen: Windows, macOS, Linux

💻 Plattformen: Windows, macOS, Linux

💬 Bewertungen: 4.5/5 auf Capterra

Bewertungen: 4.5/5 auf Capterra

⚙️ Integrationen:

Integrationen:

- ParseHub Cloud-Plattform zur Speicherung von Daten

- HTTP-Clients über die ParseHub REST API

- Dropbox

- Amazon S3-Speicher

9. Import.io

Import.io ist eine Cloud-Plattform, welche die Umwandlung von halbstrukturierten Informationen aus Webseiten in strukturierte Daten vereinfachen soll. Diese Daten können für beliebige Zwecke verwendet werden, von der Unterstützung bei Geschäftsentscheidungen bis hin zur Integration anderer Plattformen über ihre REST-API. Benutzer können Web-Scraping-Aktivitäten direkt auf der import.io-Website visuell festlegen, ohne eine Desktop-Anwendung dafür installieren zu müssen.

👍 Vorteile:

- Keine Desktop-Anwendungen oder zusätzliche Installationen erforderlich

- Leistungsstarke Datenmanipulation

- Intuitive Benutzeroberfläche

- Leistungsfähig bei großen Websites

👎  Nachteile:

Nachteile:

- Unübersichtliche Dokumente

- Viel kostspieliger als der Durchschnitt

🛠️F unktionen:

🛠️F unktionen:

- Hochwertige Proxy-Integration

- Länderspezifische Extraktoren

- Automatische CAPTCHA-Auflösung

- E-Mail-Benachrichtigungen

- Aufgabenplanung

- Automatische Paginierung

💰 Kosten: 399 $ pro Monat für den Premium-Einstiegsplan mit eingeschränkten Funktionen (kostenlose Testversion verfügbar)

Kosten: 399 $ pro Monat für den Premium-Einstiegsplan mit eingeschränkten Funktionen (kostenlose Testversion verfügbar)

🎯 Hauptziel: Bereitstellung einer Cloud-basierten Plattform zur Festlegung von Data Scraping-Aufgaben über eine Point-and-Click-Schnittstelle

🎯 Hauptziel: Bereitstellung einer Cloud-basierten Plattform zur Festlegung von Data Scraping-Aufgaben über eine Point-and-Click-Schnittstelle

💻 Plattformen: Windows, macOS, Linux

💻 Plattformen: Windows, macOS, Linux

💬 Bewertungen: 3,6/5 auf Capterra

💬 Bewertungen: 3,6/5 auf Capterra

⚙️ Integrationen:

Integrationen:

- Die meisten Scraping-Bibliotheken

- Funktionen zur Datenausarbeitung

- Programmgesteuerter Datenexport über API

- Datenexport in verschiedenen Formaten

10. WebScraper.io

WebScraper.io ist ein einfaches Point-and-Click-Tool zur Datenextraktion, das als Chrome-Browsererweiterung verfügbar ist. Benutzer haben hiermit die Möglichkeit, Daten entweder manuell oder automatisch direkt im Browser zu extrahieren. Diese Datenextraktionen können auch in der Cloud durchgeführt werden. Der Funktionsumfang des Produkts ist eher begrenzt und bietet nicht alle Funktionen der anderen bewährten Web-Scraping-Tools. Dennoch eignet es sich hervorragend für allgemeine Bedürfnisse und schnelles Daten-Scraping.

👍 Vorteile:

👍 Vorteile:

- Visuelle Auswahl von HTML-Elementen

- Benutzerfreundliche Schnittstelle

- Großartig geeignet für grundlegende Aufgaben

👎 Nachteile:

👎 Nachteile:

- Sehr eingeschränkte Parallelität

- Einfache E-Mail-Unterstützung

- Funktioniert nur unter Chrome

- Begrenzte Datenspeicherung in der Cloud

- Bedingt geeignet für anspruchsvolle Bedürfnisse

🛠️F unktionen:

🛠️F unktionen:

- CSV-, XLSX-, JSON-Export

- Scraping-Aufgabenplaner

- Proxy-Integration

- Point-and-Click-Parsing-Funktionen im Browser

- Lokale und Cloud-basierte Ausführung von Scraping-Aufgaben

💰 Kosten: 50 $ pro Monat für den Premium-Einsteigerplan (kostenloser Plan und Testversion verfügbar)

💰 Kosten: 50 $ pro Monat für den Premium-Einsteigerplan (kostenloser Plan und Testversion verfügbar)

🎯 Hauptziel: Bereitstellung einer Chrome-Erweiterung zur Festlegung von Web-Scraping-Aufgaben und deren Ausführung in der Cloud

🎯 Hauptziel: Bereitstellung einer Chrome-Erweiterung zur Festlegung von Web-Scraping-Aufgaben und deren Ausführung in der Cloud

💻 Plattformen: Windows, macOS, Linux

💻 Plattformen: Windows, macOS, Linux

💬 Bewertungen: 4.1/5 im Chrome Web Store

💬 Bewertungen: 4.1/5 im Chrome Web Store

⚙️ Integrationen:

Integrationen:

- Chrome

- Dropbox

- Google Sheets

- Google Drive

- Amazon S3

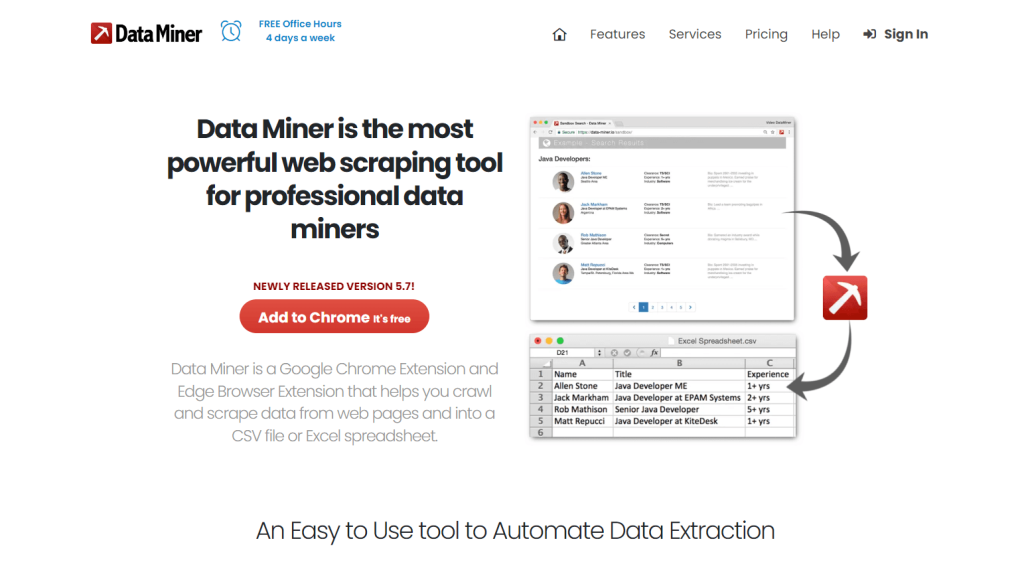

11. Data Miner

DataMiner bietet eine Web-Scraping-Erweiterung für Google Chrome mit der Bezeichnung Data Scraper. Mit dieser Erweiterung können Sie Daten von Websites direkt im Browser scrapen und in CSV-Dateien exportieren.

👍 Vorteile:

👍 Vorteile:

- Kostenlose Live-Support-Sitzungen

- Benutzerfreundliche Schnittstelle

👎 Nachteile:

👎 Nachteile:

- Begrenzter E-Mail-Support

- Nur für Chome verfügbar

- Eingeschränkt für erweiterte Datenabruf-Aufgaben

- Kostenpflichtige Fortbildung

🛠️F unktionen:

🛠️F unktionen:

- Crawling-Automatisierung

- Unterstützung für benutzerdefinierte Javascript-Skripte

- Funktioniert auf allen Domains

- Herunterladen von Bildern

- Unterstützung für Klick- und Scroll-Aktionen

💰 Kosten: 19,99 $ pro Monat für den Premium-Einsteigerplan (kostenloser Plan verfügbar)

💰 Kosten: 19,99 $ pro Monat für den Premium-Einsteigerplan (kostenloser Plan verfügbar)

🎯 Hauptziel: Bereitstellung einer Chrome-Erweiterung zum lokalen Extrahieren von Daten aus Webseiten

🎯 Hauptziel: Bereitstellung einer Chrome-Erweiterung zum lokalen Extrahieren von Daten aus Webseiten

💻 Plattformen: Windows, macOS, Linux

💻 Plattformen: Windows, macOS, Linux

💬 Bewertungen: 4,0/5 im Chrome Web Store

💬 Bewertungen: 4,0/5 im Chrome Web Store

⚙️ Integrationen:

Integrationen:

- Google Sheets

Die besten Web-Scraping-Tools: Übersichtstabelle

Wenn Sie nach schnellen Informationen zu den besten Web-Scraping-Tools suchen, werfen Sie einfach einen Blick auf die folgende Tabelle:

Fazit

In diesem Leitfaden haben wir Ihnen einige der besten Web-Scraping-Tools zur Erfassung von Online-Daten auf Websites vorgestellt. Die effektivsten Einrichtungen stützen sich meist auf mehr als eines der hier genannten Tools. Beispielsweise kann ein Browser-Automatisierungstool wie Playwright mit einem Antidetekt-Browser integriert werden. Dieser wiederum kann mit Proxys integriert werden. Eine ziemlich komplexe Sache, nicht wahr?

Wählen Sie den einfachen Weg und testen Sie Scraper API. Als umfassende Scraping-API der nächsten Generation bietet sie alles, was Sie zur Extraktion von Online-Daten benötigen, wobei gleichzeitig Anti-Bot-Technologien umgangen werden. Data-Scraping war noch nie so einfach!

Registrieren Sie sich gleich und lassen Sie sich von einem unserer Datenexperten über unsere Scraping-Lösungen beraten.