In diesem Leitfaden werden Sie sehen:

- Was ein MCP-Server ist und was diese Technologie zu bieten hat.

- Wie Sie die besten MCP-Server auf dem Markt auswählen.

- Eine Liste der 10 besten MCP-Server zur Unterstützung Ihrer KI-Agenten und -Workflows.

Lasst uns eintauchen!

Was ist ein MCP-Server?

MCP, kurz für “Model Context Protocol“, ist ein Open-Source-Protokoll, das die Kommunikation zwischen LLMs und externen Tools/Diensten standardisiert. Mit anderen Worten, es ist eine universelle Sprache, die KI-Agenten verwenden können, um sicher mit jedem Tool zu interagieren, das sie zur Erfüllung einer Aufgabe benötigen.

Ein MCP-Server implementiert das MCP-Protokoll und stellt eine Reihe von Tools zur Verfügung, die ein KI-Agent erkennen und nutzen kann. Dies ist dank der SSE- und Streamable-HTTP-Technologien möglich, auf die sich das Protokoll stützt.

Beachten Sie, dass MCP nur eines von vielen anderen verfügbaren AI-Protokollen ist.

Die wichtigsten Vorteile der Integration von MCP-Servern in Ihre KI-Workflows sind:

- Standardisierung: Sie bieten einer KI-Anwendung eine einheitliche Methode zur Interaktion mit Tools von Drittanbietern. Dadurch entfällt die Notwendigkeit, benutzerdefinierten Integrationscode für die einzigartige API, die Authentifizierung und das Datenformat der einzelnen Tools zu schreiben.

- Auffindbarkeit: Agenten können einen MCP-Server abfragen, um herauszufinden, welche Werkzeuge verfügbar sind und wie sie verwendet werden können. Dies ermöglicht eine dynamische und autonome Aufgabenausführung, die den Kern eines jeden KI-Agenten darstellt.

- Flexibilität: Dank der MCP-Server kommunizieren die KI-Agenten nur mit dem Server und nicht direkt mit den Endgeräten. So haben Sie die Kontrolle darüber, auf welche Tools die KI zugreifen kann.

Wie man die besten MCP-Server auswählt

Das Repository Awesome MCP Servers listet Hunderte von nützlichen MCP-Servern auf. Bei einer so großen Auswahl an Servern erfordert die Auswahl des besten Servers für Ihre Bedürfnisse klare Bewertungskriterien.

Bei der Auswahl der besten MCP-Server sind vor allem folgende Faktoren zu beachten:

- Typische Anwendungsfälle: Basiert der Server auf Diensten, an denen Sie interessiert sind oder die Sie bereits nutzen? Bietet er Tools, die Ihre häufigsten und zeitaufwändigsten Aufgaben abdecken? Der Wert eines MCP-Servers bemisst sich an seiner Fähigkeit, bestimmte Arbeitsabläufe zu automatisieren.

- Wichtige Werkzeuge: Die Liste der wichtigsten vom MCP-Server bereitgestellten Tools.

- Vertrauen und Popularität der Community: GitHub-Sterne sind ein starker Indikator für die Akzeptanz und das Vertrauen der Community. Außerdem korreliert eine höhere Anzahl von Sternen tendenziell mit einem stabileren und gut dokumentierten Server. Weitere zu berücksichtigende Faktoren sind die Anzahl der Mitwirkenden, die jüngsten Beiträge und Forks.

- Lizenz: MCP-Server sind in der Regel Open-Source. Neben der Lizenz des Servers sollten Sie auch die Lizenzen der Software von Drittanbietern prüfen, von denen der MCP abhängt. Wenn Sie diese Tools bereits verwenden und sie durch Ihre bestehenden Lizenzen abgedeckt sind, können Sie loslegen. Andernfalls müssen Sie deren Lizenzbedingungen prüfen und möglicherweise ein Budget für sie bereitstellen.

- Programmiersprache: Die für die Entwicklung des MCP-Servers verwendete Programmiersprache. Dies beeinflusst Ihre Anforderungen, die Installation und eventuelle Beiträge zum Quellcode.

Die 10 besten MCP-Server

Dieser Abschnitt enthält eine Liste der besten MCP-Server, die nach den oben genannten Kriterien ausgewählt und eingestuft wurden.

1. Helle Daten

Der MCP-Server von Bright Data bietet die für jede KI-Anwendung erforderlichen Datenerfassungsfunktionen. Da jedes KI-System Zugang zu hochwertigen Daten benötigt, ist dieser MCP-Server so konzipiert, dass er praktisch jeden Anwendungsfall unterstützt.

Insbesondere stattet es KI-Agenten und -Workflows mit leistungsstarken Tools zum Abrufen von Echtzeit-Webdaten aus. Diese Werkzeuge helfen der KI, ihre Antworten zu fundieren und während der Aufgabenausführung präzise mit Webseiten zu interagieren.

Die große Mehrheit der KI-gesteuerten Projekte benötigt frische, aktuelle Daten, um wettbewerbsfähig und effektiv zu bleiben. Aus diesem Grund ist der Bright Data MCP-Server eine erstklassige Lösung.

Wie Sie es integrieren können, erfahren Sie in den offiziellen Dokumenten.

Typische Anwendungsfälle:

- Abruf von Informationen in Echtzeit: Sie können aktuelle Informationen abfragen. Zum Beispiel: “Was sind die 5 aktuellsten Nachrichten auf The Guardian?”. Die KI würde das

search_engine-Toolmit einer Abfrage wie"top stories The Guardian"verwenden, um die aktuellen Schlagzeilen abzurufen. - Web Scraping und Datenextraktion: Der Server ist für Scraping-Aufgaben konzipiert. Er lässt sich mit dem Web Unlocker von Bright Data integrieren, um unter Umgehung aller Anti-Bot-Maßnahmen auf den Inhalt einer beliebigen Webseite zuzugreifen. Das bedeutet, dass Sie einen Agenten erstellen können, der Web-Scraping-Aufgaben durchführt, ohne sich Sorgen machen zu müssen, dass er blockiert wird.

- Umgehung von geografischen Einschränkungen: Viele Websites zeigen je nach Ihrem geografischen Standort unterschiedliche Inhalte an oder sind nur von bestimmten Regionen aus zugänglich. Um dies zu umgehen, kann der Bright Data MCP-Server seine Anfragen über ein riesiges Proxy-Netzwerk mit über 150 Millionen weltweit verteilten IPs leiten.

- Interaktive Browser-Automatisierung: Der Server stellt Werkzeuge für die “Browsersteuerung” bereit, d. h. ein KI-Agent kann mehr tun als nur den rohen HTML-Code einer Seite herunterladen. Er kann dynamisch mit einer Website interagieren.

- Extraktion strukturierter Daten: Dank der Web Scraper APIs ist der Server hervorragend in der Lage, strukturierte Daten in JSON von großen Plattformen abzurufen. Diese können in Echtzeit strukturierte Daten von Instagram, LinkedIn, Amazon und vielen anderen Websites über Web Scraping abrufen. Sie können zum Beispiel einen Agenten bitten, die Produktdetails einer Amazon-URL abzurufen. Der Agent würde dann ein Tool verwenden, um diese Daten abzurufen.

Wichtige Instrumente:

search_engine: Greift auf Suchergebnisse von Google, Bing oder Yandex zurück. Gibt SERP-Ergebnisse in Markdown zurück.scrape_as_markdown: Scraped eine einzelne Webseiten-URL mit erweiterten Optionen für die Extraktion von Inhalten und liefert die Ergebnisse in Markdown zurück. Dieses Tool kann jede Webseite freischalten, auch wenn sie Bot-Erkennung oder CAPTCHA verwendet.scrape_as_html: Scraped eine einzelne Webseiten-URL mit erweiterten Optionen für die Extraktion von Inhalten und liefert die Ergebnisse in HTML zurück. Dieses Tool kann jede Webseite freischalten, auch wenn sie Bot-Erkennung oder CAPTCHA verwendet.session_stats: Informiert den Benutzer über die Nutzung des Tools während dieser Sitzungweb_data_amazon_product: Liest schnell strukturierte Amazon-Produktdaten.web_data_amazon_product_reviews: Liest schnell strukturierte Amazon-Produktbewertungsdaten.web_data_linkedin_person_profile: Liest schnell strukturierte LinkedIn-Personenprofildaten.web_data_linkedin_unternehmen_profil: Liest schnell strukturierte LinkedIn-Firmenprofildaten.web_data_zoominfo_unternehmen_profil: Liest schnell strukturierte ZoomInfo-Firmenprofildaten.web_data_instagram_profiles: Liest schnell strukturierte Instagram-Profildaten.web_data_instagram_posts: Liest schnell strukturierte Instagram-Post-Daten.web_data_instagram_reels: Liest schnell strukturierte Instagram-Rollendaten.web_data_instagram_comments: Liest schnell strukturierte Instagram-Kommentardaten.web_data_facebook_posts: Liest schnell strukturierte Facebook-Post-Daten.web_data_facebook_marketplace_listings: Liest schnell strukturierte Facebook-Marktplatz-Listing-Daten.web_data_facebook_Unternehmensrezensionen: Liest schnell strukturierte Facebook-Firmenbewertungsdaten.web_data_x_posts: Liest schnell strukturierte X-Post-Daten. Erfordert eine gültige X-Post-URL.web_data_zillow_properties_listing: Liest schnell strukturierte Zillow-Eigenschaftslistendaten.web_data_booking_hotel_listings: Liest schnell strukturierte Daten von Hotelbuchungslisten.web_data_youtube_videos: Liest schnell strukturierte YouTube-Videodaten.scraping_browser_navigate: Navigiert eine Scraping-Browser-Sitzung zu einer neuen URL.scraping_browser_go_back: Kehrt zur vorherigen Seite zurück.scraping_browser_go_forward: Blättert zur nächsten Seite weiter.scraping_browser_click: Klicks auf ein Element.scraping_browser_links: Ermittelt alle Links auf der aktuellen Seite, Text und Selektoren.scraping_browser_type: Schreibt Text in ein Element.scraping_browser_wait_for: Wartet darauf, dass ein Element auf der Seite sichtbar istscraping_browser_screenshot: Macht einen Screenshot von der aktuellen Seitescraping_browser_get_html: Ruft den HTML-Inhalt der aktuellen Seite ab.scraping_browser_get_text: Ermittelt den Textinhalt der aktuellen Seiteweb_data_amazon_product_search: Liest schnell strukturierte Amazon-Produktsuchdaten.web_data_walmart_product: Liest schnell strukturierte Walmart-Produktdaten.web_data_walmart_seller: Liest schnell strukturierte Walmart-Verkäuferdaten.web_data_ebay_product: Liest schnell strukturierte eBay-Produktdaten.web_data_homedepot_products: Liest schnell strukturierte Homedepot-Produktdaten.web_data_zara_products: Liest schnell strukturierte Zara-Produktdaten.web_data_etsy_products: Liest schnell strukturierte Etsy-Produktdaten.web_data_bestbuy_products: Liest schnell strukturierte Best Buy-Produktdaten.web_data_linkedin_job_listings: Liest schnell strukturierte LinkedIn-Stellenanzeigen-Daten.web_data_linkedin_posts: Liest schnell strukturierte LinkedIn-Posts-Daten.web_data_linkedin_people_search: Liest schnell strukturierte LinkedIn-Leute-Suchdaten.web_data_crunchbase_company: Liest schnell strukturierte Crunchbase-Unternehmensdaten.web_data_facebook_events: Liest schnell strukturierte Facebook-Ereignisdaten.web_data_tiktok_profiles: Liest schnell strukturierte TikTok-Profildaten.web_data_tiktok_posts: Liest schnell strukturierte TikTok-Postdaten.web_data_tiktok_shop: Liest schnell strukturierte TikTok-Shop-Daten.web_data_tiktok_kommentare: Liest schnell strukturierte TikTok-Kommentardaten.web_data_google_maps_reviews: Liest schnell strukturierte Google Maps-Bewertungsdaten.web_data_google_shopping: Liest schnell strukturierte Google-Shopping-Daten.web_data_google_play_store: Liest schnell strukturierte Google Play Store-Daten.web_data_apple_app_store: Liest schnell strukturierte Apple App Store Daten.web_data_reuter_news: Liest schnell strukturierte Reuters-Nachrichtendaten.web_data_github_repository_file: Liest schnell strukturierte GitHub-Repository-Daten.web_data_yahoo_finance_business: Liest schnell strukturierte Yahoo Finance-Wirtschaftsdaten.web_data_youtube_profiles: Liest schnell strukturierte YouTube-Profil-Daten.web_data_youtube_comments: Liest schnell strukturierte YouTube-Kommentardaten.web_data_reddit_posts: Liest schnell strukturierte Reddit-Beitragsdaten.

Alle Tools finden Sie im offiziellen Repository des Bright Data MCP-Servers.

Vertrauen und Popularität der Gemeinschaft: Das Repository hat mehr als 700 Sterne. Es ist gut dokumentiert und weit verbreitet, wie die über 100 Forks zeigen.

Kompatible Websites: LinkedIn, Immobilien-Websites, Facebook, Reddit, YouTube und viele mehr.

Beliebte Integrationen: N8N, Claude, Cursor, Perplexity, OpenAI, VS Code, Windsurf, und mehr.

Lizenz: Der MCP-Server ist Open-Source (MIT-Lizenz). Unter der Haube basiert er auf den Produkten von Bright Data, die mit einer kostenlosen Testversion geliefert werden.

Programmiersprache: Node.js.

2. GitHub

Der GitHub MCP-Server ist ein unverzichtbares Werkzeug für jedes Team, das an der Softwareentwicklung beteiligt ist. Es hilft KI-Agenten dabei, aktive Teilnehmer im Entwicklungszyklus zu werden. Das bedeutet, dass sie in der Lage sind, Repositories zu verwalten, Probleme zu verfolgen und sogar mit dem Code zu interagieren.

Typische Anwendungsfälle:

- Automatisieren von GitHub-Workflows: Anstatt sich manuell durch die Oberfläche von GitHub zu klicken, können Sie Aktionen automatisieren. Sie könnten zum Beispiel fragen: “Wie ist der Status meines letzten PR?” und der Bot könnte die Tools

list_pull_requestsundget_pull_request_statusverwenden, um die Antwort zu finden und zu melden. - Extrahieren und Analysieren von Daten aus GitHub-Repositories: Dabei wird der Server verwendet, um Informationen aus GitHub für Analysen oder Berichte zu ziehen. Sie könnten zum Beispiel ein Dashboard erstellen, das alle offenen Pull-Requests und ihren aktuellen Status auflistet.

Wichtige Instrumente:

get_issue: Ruft den Inhalt einer Ausgabe innerhalb eines Repositorys ab.create_issue: Erzeugt einen neuen Eintrag in einem GitHub-Repository.add_issue_comment: Fügt einen Kommentar zu einem Problem hinzu.list_issues: Auflisten und Filtern von Repository-Ausgaben.update_issue: Aktualisiert einen bestehenden Eintrag in einem GitHub-Repository.get_pull_request: Liefert Details zu einer bestimmten Pull-Anfrage.list_pull_requests: Auflistung und Filterung von Repository Pull Requests.merge_pull_request: Führt eine Pull-Anfrage zusammen.get_pull_request_diff: Ermittelt den Diff einer Pull-Anfrage.create_pull_request: Erzeugt eine neue Pull-Anfrage.update_pull_request: Aktualisiert eine bestehende Pull-Anfrage in einem GitHub-Repository.delete_file: Löscht eine Datei aus einem GitHub-Repository.list_branches: Listet Zweige in einem GitHub-Repository auf.push_files: Verschiebt mehrere Dateien in einer einzigen Übertragung.search_repositories: Sucht nach GitHub-Repositories.create_repository: Erzeugt ein neues GitHub-Repository.fork_repository: Forks ein Repository.Zweig_erstellen: Erzeugt einen neuen Zweig.run_workflow: Löst einen Workflow über das Ereignis workflow_dispatch aus.get_workflow_run: Liefert Details zu einem bestimmten Workflow-Lauf.get_workflow_run_logs: Lädt Protokolle für einen Workflow-Lauf herunter.rerun_workflow_run: Führt einen gesamten Workflow erneut aus.rerun_failed_jobs: Führt nur die fehlgeschlagenen Aufträge in einem Workflow-Lauf erneut aus.cancel_workflow_run: Bricht einen laufenden Workflow ab.

Entdecken Sie alle verfügbaren Tools im offiziellen Repository von GitHub.

Vertrauen der Gemeinschaft und Popularität: Das Repository hat mehr als 16,4k Sterne und ist klar dokumentiert. Die hohe Anzahl von PRs (45+), Mitwirkenden (60+) und Forks (1,2k+) macht es zu einem weit verbreiteten und gepflegten Repository.

Lizenz: Dieser MCP-Server ist quelloffen (MIT-Lizenz). Er erfordert ein GitHub-Konto, für das es kostenlose und kostenpflichtige Stufen gibt.

Programmiersprache: Go.

3. Supabase

Supabase ist eine beliebte Open-Source-Backend-as-a-Service-Plattform. Ihr MCP-Server bietet KI-Agenten vollen programmatischen Zugriff auf die Datenbank, die Authentifizierung und den Speicher Ihres Projekts. Das öffnet die Tür zur Backend-Verwaltung in natürlicher Sprache.

Typische Anwendungsfälle:

- Datenbankverwaltung und -abfrage: Sie können mit Ihrer Postgres-Datenbank interagieren, ohne selbst SQL zu schreiben. Sie könnten zum Beispiel fragen: “Wie viele Benutzer haben sich letzte Woche angemeldet?”. Der Agent würde das Werkzeug

execute_sql`verwenden, um die erforderlichen Abfragen auszuführen. - Projekt- und Kontoverwaltung: Der Server bietet Tools zur Verwaltung Ihrer Supabase-Projekte und Organisationseinstellungen. Sie können z. B. einen Agenten haben, der ein neues Projekt erstellt, ein inaktives Projekt pausiert oder eine Liste aller Ihrer Projekte abruft.

- Fehlersuche und Überwachung: Wenn etwas schief läuft, können Sie den Agenten als erste Verteidigungslinie einsetzen. Sie könnten zum Beispiel fragen: “Zeigen Sie mir die API-Protokolle der letzten Stunde, um zu sehen, ob es irgendwelche Fehler gibt”. Dazu würde der Agent das Tool

get_logsverwenden.

Wichtige Instrumente:

suche_docs: Durchsucht die Supabase-Dokumentation nach aktuellen Informationen.list_tables: Listet alle Tabellen innerhalb des angegebenen Schemas auf.list_migrations: Listet alle Migrationen in der Datenbank auf.apply_migration: Wendet eine SQL-Migration auf die Datenbank an.execute_sql: Führt Roh-SQL in der Datenbank aus.get_project_url: Ruft die API-URL für ein Projekt ab.get_anon_key: Ruft den anonymen API-Schlüssel für ein Projekt ab.generate_typescript_types: Erzeugt TypeScript-Typen auf der Grundlage des Datenbankschemas.list_storage_buckets: Listet alle Storage Buckets in einem Supabase-Projekt auf.get_storage_config: Ruft die Speicherkonfiguration für ein Supabase-Projekt ab.update_storage_config: Aktualisiert die Speicherkonfiguration für ein Supabase-Projekt (erfordert einen kostenpflichtigen Tarif).

Die vollständige Liste der verfügbaren Tools finden Sie im entsprechenden Abschnitt des Repositorys.

Vertrauen und Popularität der Gemeinschaft: Das Repository hat mehr als 1,7k Sterne. Es ist gut dokumentiert und weit verbreitet (über 150 Forks).

Lizenz: Open-Source (Apache 2.0). Beachten Sie, dass Supabase sowohl kostenlose als auch kostenpflichtige Pläne anbietet.

Programmiersprache: Node.js.

4. Dramatiker

Der Playwright-MCP-Server ermöglicht LLMs die Interaktion mit Webseiten, indem er die Playwright-Browser-Automatisierungs-API nutzt. Hinter den Kulissen stützt er sich auf Schnappschüsse der Barrierefreiheit. Dadurch wird der Bedarf an Screenshots und KI-Modellen mit visuellen Fähigkeiten überflüssig.

Erfahren Sie mehr darüber, was Playwright zu bieten hat.

Typische Anwendungsfälle:

- Menschenähnliche Interaktion: Ihr KI-Agent erhält die Fähigkeit, mit Webseiten zu interagieren, z. B. zu klicken, zu navigieren, Screenshots zu machen und vieles mehr. Das bedeutet, dass Sie fortgeschrittene KI-Agenten erstellen können, die reale Aufgaben auf Webseiten mit nur einer Eingabeaufforderung ausführen (z. B. ähnlich wie bei Browser-Use).

- Automatisierte Testerstellung: Hierfür müssen Sie eine vollständige User Journey beschreiben. Die KI kann ihre Browser-Steuerungswerkzeuge verwenden, um die Schritte auszuführen, und das Werkzeug

browser_generate_playwright_testverwenden, um ein Playwright-Testskript auszugeben.

Wichtige Instrumente:

browser_snapshot: Erfasst einen Schnappschuss der aktuellen Seite.browser_klick: Führt einen Klick auf eine Webseite aus.browser_drag: Ermöglicht das Ziehen und Ablegen zwischen zwei Elementen.browser_hover: Bewegt den Mauszeiger über das Element auf der Seite.browser_type: Geben Sie Text in ein bearbeitbares Element ein.browser_select_option: Wählt eine Option in einer Auswahlliste aus.browser_wait_for: Wartet auf das Erscheinen oder Verschwinden von Text oder auf das Verstreichen einer bestimmten Zeit.browser_navigate: Navigiert zu einer URL.browser_pdf_save: Speichert die Seite als PDF.browser_tab_list: Listet Browser-Registerkarten auf.browser_tab_new: Öffnet eine neue Registerkarte.browser_tab_select: Wählt eine Registerkarte nach Index aus.browser_tab_close: Schließt eine Registerkarte.browser_generate_playwright_test: Erzeugt einen Playwright-Test für das angegebene Szenario.browser_screen_move_mouse: Bewegt die Maus an eine bestimmte Position.browser_screen_click: Klickt mit der linken Maustaste.browser_screen_drag: Zieht die linke Maustaste.browser_screen_type: Typen Text.browser_press_key: Drückt eine Taste auf der Tastatur.

Der Abschnitt “Tools” im Playwright-Repository beschreibt sie alle.

Vertrauen und Popularität der Gemeinschaft: Die 13,1k+ GitHub-Sterne zeigen, dass diesem Repository weithin vertraut wird und es angenommen ist. Es hat auch mehrere Mitwirkende und Forks (900+) sowie eine gute Dokumentation.

Lizenz: Open-Source (Apache 2.0).

Programmiersprache: Node.js.

5. Begriff

Der MCP-Server von Notion verwandelt Notion in eine dynamische Wissensbasis, aus der KI-Agenten lesen und in die sie schreiben können. Dies gibt Ihrer KI die Automatisierungskraft, um Aufgaben wie Dokumentation, Projektmanagement und Inhaltserstellung zu bewältigen.

Typische Anwendungsfälle:

- Automatisiertes Aufgabenmanagement: Sie können Ihre Projektpläne mit natürlicher Sprache verwalten. Die KI erstellt einen neuen Eintrag in Ihrer Datenbank mit den von Ihnen abgefragten Eigenschaften.

- Erstellung neuer Notion-Datenbanken: Der KI-Agent kann neue Notion-Datenbanken erstellen. Sie könnten eine Aufforderung verwenden wie: “Erstellen Sie eine neue Datenbank, um meine Bewerbungen zu verfolgen. Sie sollte Spalten für den Firmennamen, die Position und einen Link zur Stellenbeschreibung enthalten”.

- Abrufen von Wissen: Sie können Lösungen für technische Probleme finden, indem Sie den Agenten bitten, die gesamte Dokumentation zu durchsuchen.

Wichtige Instrumente:

Suchen: Findet alles in Ihrem Notion-Arbeitsbereich, in verbundenen Apps oder im Internet, indem Sie Fragen in einfachem Englisch stellen.Suche nach Titel: Fallback-Suchwerkzeug, wenn das AI-Abonnement nicht verfügbar ist. Führt eine Stichwortsuche nur für Seitentitel durch.Ansicht: Sieht sich jede Seite, Datenbank, Datei oder jeden Benutzer in Ihrem Notion-Arbeitsbereich an, um zu sehen, was sich darin befindet.Kommentare abrufen: Listet alle Kommentare zu einer bestimmten Seite oder einem Block auf, einschließlich der Diskussionen in einem bestimmten Thema.Get User: Ruft detaillierte Informationen über einen bestimmten Benutzer anhand seiner ID oder seiner Referenz ab.Seiten erstellen: Erzeugt neue Seiten in Ihrem Arbeitsbereich mit beliebigen Inhalten. Geben Sie an, wo diese Seite hinzugefügt werden soll, oder sie wird eine private Standardseite sein.Einen Kommentar erstellen: Fügt einen Kommentar zu einer Seite oder einem Block hinzu.Seite aktualisieren: Bearbeitet vorhandene Seiten, indem es ihren Titel, Inhalt oder andere Eigenschaften ändert.

In der Dokumentation zu den Notion MCP-Server-Tools wird beschrieben, wann die einzelnen Tools zu verwenden sind, und es werden nützliche Hinweise gegeben, damit Sie sofort loslegen können.

Vertrauen und Popularität der Gemeinschaft: Es hat 2,3k+ Sterne und eine gute Dokumentation. Es hat auch eine gute Menge an aktuellen Beiträgen, so dass es gut gewartet und angenommen wird.

Lizenz: Open-Source (MIT-Lizenz). Notion selbst bietet eine breite Palette von Funktionen mit dem kostenlosen Plan, aber einige sind für zahlende Nutzer zur Verfügung gestellt.

Programmiersprache: Node.js.

6. Atlassian

Atlassian MCP Server wurde speziell für die Automatisierung von Arbeitsabläufen entwickelt, die Confluence, Jira, Jira Cloud und Server/Data Center-Bereitstellungen mit LLMs umfassen. Diese Lösungen werden häufig für Dokumentation, Problemverfolgung und Teamzusammenarbeit verwendet. Die Integration dieser Lösungen mit KI ermöglicht es intelligenten Agenten, Tickets zu verwalten, die Dokumentation zu aktualisieren und vieles mehr.

Typische Anwendungsfälle:

- Intelligente Jira-Automatisierung: Durch die richtige Eingabeaufforderung des LLM können Sie Jira-Arbeitsabläufe für die Informationsbeschaffung und -suche sowie die Erstellung und Verwaltung von Problemen automatisieren.

- Verwaltung der Confluence-Dokumentation: Sie können Confluence in eine dynamische Wissensdatenbank verwandeln, mit der Sie sprechen können. Sie können die Dokumentation direkt vom Chat aus erstellen und verwalten. Sie können auch den Agenten bitten, die Dokumentation für Sie zu suchen und zusammenzufassen.

Wichtige Instrumente:

jira_search: Durchsucht Jira-Ausgaben.jira_erstellen_frage: Erzeugt eine neue Jira-Ausgabe.jira_update_issue: Aktualisiert eine bestehende Jira-Ausgabe.confluence_search: Durchsucht Confluence-Inhalte.confluence_get_page: Ruft den Inhalt einer bestimmten Seite ab.confluence_erstellen_seite: Erzeugt eine neue Seite.confluence_update_page: Aktualisiert eine bestehende Seite.

Lesen Sie alle verfügbaren Tools im Abschnitt über das Atlassian MCP-Server-Repository.

Vertrauen und Popularität der Gemeinschaft: Es hat 2,1k+ Sterne und eine gute Dokumentation. Es hat auch viele Mitwirkende (50+) und Forks (360+), wodurch es gut gewartet und angenommen wird.

Lizenz: Open-Source (MIT-Lizenz). Beachten Sie, dass es für Jira und Atlassian sowohl kostenlose als auch kostenpflichtige Versionen gibt.

Programmiersprache: Python, aber nur über Docker verteilt.

7. Serena

Serena MCP Server ist ein Coding Agent Toolkit, das direkt mit Ihrer Codebasis arbeitet. Es bietet alle Werkzeuge, die typisch für die Fähigkeiten einer IDE sind. Insbesondere sind das:

- Verwendet LSP(Language Server Protocols), um Code zu analysieren und semantisch zu verstehen.

- Kann Code lesen und schreiben, aber auch Shell-Befehle ausführen.

- Verfügt über ein beständiges Verständnis einer spezifischen Codebasis, da es über ein Onboarding- und Speichersystem verfügt.

Typische Anwendungsfälle:

- LLM-gestützte Kodierung: Serena ist für jede Codierungsaufgabe geeignet. Es kann Code lesen, schreiben und ausführen. Es kann auch Protokolle und die Terminalausgabe lesen. Es bietet direkte und indirekte Unterstützung für Programmiersprachen wie Python, JavaScript, Go und mehr.

Wichtige Instrumente:

Aktivieren_Projekt: Aktiviert ein Projekt nach Name.create_text_file: Erzeugt/überschreibt eine Datei im Projektverzeichnis.delete_lines: Löscht einen Bereich von Zeilen innerhalb einer Datei.delete_memory: Löscht einen Speicher aus dem projektspezifischen Speichersystem von Serena.execute_shell_command: Führt einen Shell-Befehl aus.find_symbol: Führt eine globale (oder lokale) Suche nach Symbolen durch, die einen bestimmten Namen/Substring enthalten (optional nach Typ gefiltert).get_active_project: Ermittelt den Namen des derzeit aktiven Projekts (falls vorhanden) und listet vorhandene Projekte aufget_current_config: Gibt die aktuelle Konfiguration des Agenten aus, einschließlich der aktiven Modi, Werkzeuge und des Kontexts.get_symbols_overview: Gibt einen Überblick über die Symbole der obersten Ebene, die in einer bestimmten Datei oder einem bestimmten Verzeichnis definiert sind.initial_instructions: Ruft die anfänglichen Anweisungen für das aktuelle Projekt ab.insert_after_symbol: Fügt den Inhalt nach dem Ende der Definition eines bestimmten Symbols ein.einfügen_an_Zeile: Fügt den Inhalt an einer bestimmten Zeile in eine Datei ein.list_dir: Listet Dateien und Verzeichnisse im angegebenen Verzeichnis auf (optional mit Rekursion).list_memories: Listet die Speicher im projektspezifischen Speicher von Serena auf.vorbereiten_für_neue_Gespräche: Enthält Anweisungen zur Vorbereitung eines neuen Gesprächs.read_file: Liest eine Datei innerhalb des Projektverzeichnisses.read_memory: Liest den Speicher mit dem angegebenen Namen aus dem projektspezifischen Speicherspeicher von Serena.replace_lines: Ersetzt einen Bereich von Zeilen innerhalb einer Datei durch neuen Inhalt.suche_nach_mustern: Führt eine Suche nach einem Muster im Projekt durch.summarize_changes: Bietet Anweisungen zum Zusammenfassen der an der Codebasis vorgenommenen Änderungen.

Entdecken Sie die vollständige Liste der Tools in Serenas Repository.

Vertrauen und Beliebtheit in der Gemeinschaft: Serena hat 2,9k+ Sterne und eine sehr umfangreiche Dokumentation.

Lizenz: Open-Source (MIT-Lizenz).

Programmiersprache: Python.

8. Dateisystem

Das Dateisystem-MCP-Server-Repository dient zur Erstellung von KI-Agenten, die Ihre Dateisystemoperationen verwalten.

Wichtige Instrumente:

read_file: Liest den gesamten Inhalt einer Datei.Datei_schreiben: Erzeugt eine neue Datei oder überschreibt eine bestehende.create_directory: Erzeugt ein neues Verzeichnis oder stellt sicher, dass es existiert.verschieben_datei: Verschiebt oder benennt Dateien und Verzeichnisse um.

Greifen Sie auf die umfassende Liste der verfügbaren Tools im Repository zu.

Vertrauen der Gemeinschaft und Popularität: Dieses Repository hat 56k+ Sterne, eine umfangreiche Dokumentation und eine hohe Anzahl von Mitwirkenden (580+). Beachten Sie, dass sich diese Kennzahlen auf das Repository des gesamten Projekts beziehen, in dem mehrere MCP-Server aufgeführt sind.

Lizenz: Open-Source (MIT-Lizenz).

Programmiersprache: Das Repository bietet Server in Node.js und Python.

9. Figma

Der Figma MCP-Server wurde entwickelt, um Cursor mit Hilfe von KI-gestützten Codierungswerkzeugen Zugang zu Ihren Figma-Dateien zu geben. Sein Ziel ist es, die Zeit zu verkürzen, die Sie benötigen, um One-Shot-Designs zu erstellen, ohne Screenshots einfügen zu müssen.

Typische Anwendungsfälle:

- Verringerung der POC-Zeit: Mit diesem Server können Sie die für die Erstellung eines POC(Proof of Concept) eines Figma-Entwurfs benötigte Zeit verkürzen, indem Sie einen LLM anfordern und den KI-Agenten die Arbeit selbständig erledigen lassen.

Wichtige Instrumente:

get_code: Liefert eine strukturierte React + Tailwind Darstellung Ihrer Figma Auswahl.get_variable_defs: Extrahiert die in Ihrer Auswahl verwendeten Variablen und Stile.

Vertrauen und Popularität der Gemeinschaft: Das Repository hat 8,6k+ Sterne.

Lizenz: Open-Source (MIT). Stattdessen bietet Figma kostenlose und kostenpflichtige Pläne an.

Programmiersprache: Node.js.

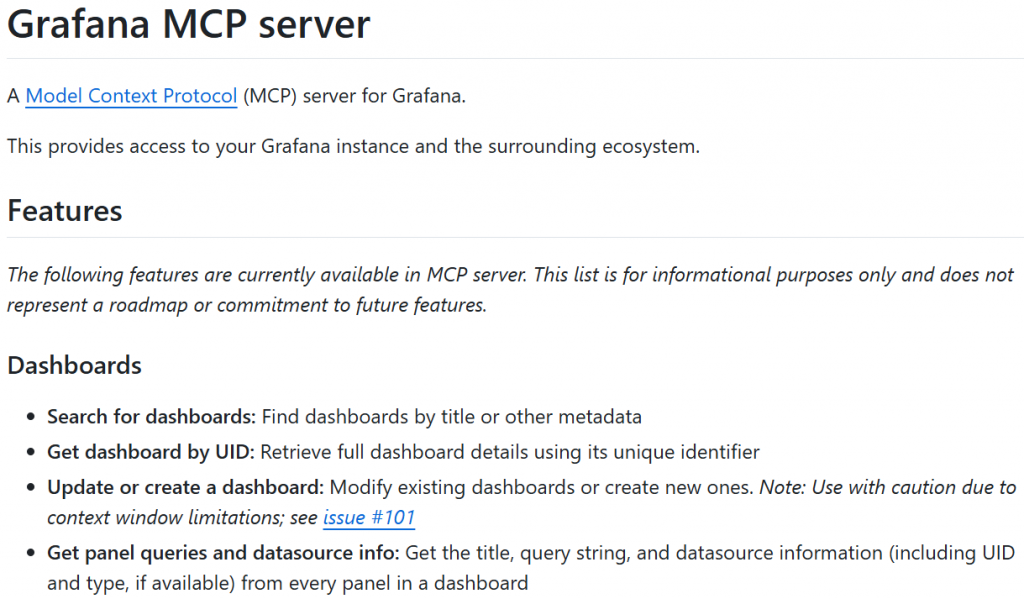

10. Grafana

Grafana ist eine Open-Source-Plattform für die Visualisierung, Überwachung und Analyse von Daten. Sie wird besonders für ihren Agnostizismus und ihre Erweiterbarkeit geschätzt, und weil sie ein offenes System ist. Das bedeutet, dass es als zentraler Knotenpunkt fungiert, der mit Dutzenden von verschiedenen Datenquellen verbunden ist. Mit dem Grafana MCP-Server können Sie einen KI-Agenten erstellen, der mit dem gesamten Grafana-Ökosystem interagiert.

Typische Anwendungsfälle:

- KI-Vorfallmanagement: Sie können Agenten erstellen, die Sie bei der Verwaltung des gesamten Lebenszyklus von Vorfällen direkt von Ihrer Chat-Oberfläche aus unterstützen. Außerdem wird die Einstiegshürde für die Abfrage von Systemen gesenkt, indem natürliche Sprache in spezifische PromQL- oder LogQL-Abfragen übersetzt wird.

Wichtige Instrumente:

search_dashboards: Sucht nach Dashboards.abfrage_prometheus: Führt eine Abfrage gegen eine Prometheus-Datenquelle aus.list_incidents: Listet Vorfälle in Grafana Incident auf.query_loki_logs: Abfragen und Abrufen von Protokollen mit LogQL.get_analysis: Ruft eine bestimmte Analyse aus einer Sift-Untersuchung ab.

Automatisieren Sie Ihr Grafana Incident Management mit allen verfügbaren Tools.

Vertrauen der Community und Beliebtheit: 1k+ Sterne, gute Dokumentation und häufige Beiträge.

Lizenz: Open-Source (Apache 2.0). Die Preise für Grafana finden Sie auf der Seite mit den Preisen.

Programmiersprache: Go.

Beste MCP-Server: Zusammenfassende Tabelle

Im Folgenden finden Sie eine Übersichtstabelle, die Ihnen einen umfassenden Überblick über die MCP-Server gibt, die Sie in diesem Artikel kennengelernt haben:

| Unternehmen | Kategorie | Programmiersprache | Link zum Repository | GitHub-Sterne | MCP-Server-Lizenz |

|---|---|---|---|---|---|

| Helle Daten | Daten für jede KI-Anwendung | Node.js | brightdata/brightdata-mcp |

700+ | MIT |

| GitHub | Versionierung von Arbeitsabläufen | Weiter | github/github-mcp-server |

16k+ | MIT |

| Supabase | Datenbank | Node.js | supabase-community/supabase-mcp |

1.7k+ | Apache 2.0 |

| Dramatiker | Browser-Automatisierung | Node.js | microsoft/playwright-mcp |

12.8k+ | Apache 2.0 |

| Begriff | Wissensmanagement | Node.js | makenotion/notion-mcp-server |

2.3k+ | MIT |

| Atlassian | Zusammenarbeit im Team | Python (nur über Docker) | sooperset/mcp-atlassian |

2.1k+ | MIT |

| Serena | Codierungs-Workflows | Node.js | oraios/serena |

2.9k+ | MIT |

| Dateisystem | Dateisystem-Operationen | Node.js, Python | modelcontextprotocol/servers/tree/main/src/filesystem |

56k+ (für das gesamte Projekt) | MIT |

| Figma | Arbeitsabläufe gestalten | Node.js | GLips/Figma-Kontext-MCP |

8.6k+ | MIT |

| Grafana | Beobachtbarkeit | Weiter | grafana/mcp-grafana |

1k+ | Apache 2.0 |

Jetzt, da Sie die besten MCP-Server kennen, können Sie lernen, wie man sie benutzt, indem Sie diese Anleitungen lesen:

- Integration von Qwen-Agent mit MCP zur Erstellung von Agenten mit Live-Datenzugriff

- Web Scraping mit MCP-Servern: Eine Schritt-für-Schritt-Anleitung

- Integration von Google ADK mit einem MCP-Server für die Entwicklung von KI-Agenten

- Aufbau von Web-Scraping-Agenten mit CrewAI und dem Model Context Protocol (MCP) von Bright Data

Schlussfolgerung

In diesem Artikel haben Sie erfahren, was ein MCP-Server ist und warum er nützlich ist. Sie haben die wichtigsten Faktoren untersucht, die bei der Auswahl der besten MCP-Server auf dem Markt zu berücksichtigen sind. Dann haben Sie gesehen, wie diese Kriterien auf eine Liste der 10 besten verfügbaren Optionen zutreffen.

Unter den aufgeführten Optionen sticht der MCP-Server von Bright Data als eine der besten hervor. Der Grund dafür ist einfach: Jedes KI-Projekt und jeder Arbeitsablauf hängt von qualitativ hochwertigen Daten ab!

Genau das ist die Stärke des Bright Data MCP-Servers. Er gibt der KI die Möglichkeit, die benötigten Daten auf ethische Weise aus dem Web, der größten und reichhaltigsten Informationsquelle der Welt, abzurufen.

Wenn Sie produktionsreife KI-Workflows erstellen, benötigen Sie Tools, die Webinhalte zuverlässig abrufen, validieren und umwandeln können. Genau das können Sie in der KI-Infrastruktur von Bright Data finden.

Erstellen Sie ein Bright Data-Konto und testen Sie alle unsere Produkte und Services für die KI-Entwicklung!