In diesem Leitfaden erfahren Sie:

- Warum die Welt sich über GenAI hinaus in Richtung einer Ära der agentenbasierten KI bewegt.

- Die größten Einschränkungen aktueller großer Sprachmodelle.

- Wie Sie diese Einschränkungen mit einer agentenbasierten Wissenspipeline überwinden können.

- Wo und warum KI-Agenten scheitern und was sie brauchen, um erfolgreich zu sein.

- Wie Bright Data eine vollständige Suite von Tools zur Beherrschung von KI-Agenten anbietet.

Lassen Sie uns eintauchen!

Das Zeitalter der agentenbasierten KI: Von generativer KI zu KI-Agenten

Laut McKinsey nutzen rund 88 % der befragten Unternehmen KI in mindestens einem Geschäftsbereich. Interessanterweise geben 23 % der Befragten an, dass ihre Unternehmen bereits ein agentenbasiertes KI-System in einem Bereich des Unternehmens einsetzen, während weitere 39 % aktiv mit KI-Agenten experimentieren.

Dies signalisiert eine allmähliche Abkehr von einfachen GenAI-Pipelines hin zu fortschrittlicheren, agentenbasierten Systemen. Unternehmen geben nicht mehr nur Modelle vor. Stattdessen testen sie KI-Agenten in realen Prozessen und Systemen.

Warum? Weil KI-Agenten im Vergleich zu herkömmlichen GenAI-Workflows autonom sind, Fehler beheben können und viel komplexere Ziele verfolgen können. Das ist es, was KI-gestützte Entscheidungsfindung und tiefere, umsetzbare Erkenntnisse wirklich ermöglicht.

Diese Verlagerung zahlt sich aus. In einer PwC-Studie unter 300 Führungskräften gaben zwei Drittel (66 %) an, dass KI-Agenten einen messbaren Mehrwert liefern, vor allem durch Produktivitätssteigerungen.

Es überrascht nicht, dass agentische KI nach wie vor einer der am schnellsten wachsenden Trends in diesem Bereich ist. Forbes schätzt, dass der Markt für agentische KI von 8,5 Milliarden US-Dollar im Jahr 2026 auf 45 Milliarden US-Dollar im Jahr 2030 wachsen wird, was unterstreicht, wie schnell dieses Paradigma an Bedeutung gewinnt.

Die größten Einschränkungen von KI-Agenten

„Agentische KI” bezieht sich auf die Verwendung von KI durch KI-Agenten. Dabei handelt es sich um autonome Systeme, die so konzipiert sind, dass sie bestimmte Ziele durch Planung, Schlussfolgerungen und Maßnahmen mit minimaler menschlicher Beteiligung oder vollständig im Namen des Benutzers erreichen.

Wie machen sie das? Indem sie einem aufgabenbasierten Fahrplan folgen, der aus klaren Anweisungen, Tool-Integrationen, optionalen Human-in-the-Loop-Schritten und der Ausführung durch Versuch und Irrtum besteht. Weitere Informationen finden Sie in unserem ausführlichen Leitfaden zum Aufbau von KI-Agenten.

Ein agentenbasiertes KI-System kann auch auf mehrere zugrunde liegende KI-Agenten zurückgreifen, die jeweils auf eine bestimmte Aufgabe spezialisiert sind. Das klingt leistungsstark, und das ist es auch. Es ist jedoch wichtig, sich vor Augen zu halten, dass das Gehirn und der Hauptmotor jedes KI-Agenten nach wie vor ein großes Sprachmodell ist.

LLMs haben unsere Arbeitsweise und unseren Umgang mit komplexen Problemen verändert, aber sie haben auch einige Einschränkungen. Die beiden wichtigsten sind:

- Begrenztes Wissen: Das Wissen eines LLM ist durch seine Trainingsdaten begrenzt, die eine Momentaufnahme der Vergangenheit darstellen. Daher ist es nicht über aktuelle Ereignisse oder jüngste Veränderungen informiert, es sei denn, es wird ausdrücklich aktualisiert oder erweitert. Es kann zwar die richtige Antwort ableiten, aber auch selbstbewusste, aber falsche oder halluzinierte Antworten produzieren.

- Keine direkte Interaktion mit der realen Welt: LLMs können ohne spezielle Tools und Integrationen nicht mit dem Internet, externen Systemen oder Live-Umgebungen interagieren. Ihre Hauptfunktion besteht darin, Inhalte wie Texte, Bilder, Code oder Videos auf der Grundlage ihres Wissens und der ihnen gestellten Aufgaben zu generieren.

Da KI-Agenten auf LLMs aufbauen, erben sie diese Einschränkungen, unabhängig davon, für welches agentenbasierte KI-Framework Sie sich entscheiden. Deshalb verhalten sich ohne die richtige Architektur und Steuerung nicht alle KI-Agenten wie beabsichtigt.

Die Lösung ist eine agentiale Wissenspipeline

Wie Sie vielleicht bereits vermutet haben, ist der einfachste und effektivste Weg, die inhärenten Einschränkungen der agentenbasierten KI zu überwinden, die Ausstattung der KI-Agenten mit den richtigen Tools. Diese Tools müssen die Live-Datensuche und -abfrage, die Interaktion mit der realen Welt und die Integration mit den Systemen und Diensten ermöglichen, auf denen die Agenten arbeiten sollen.

Es geht jedoch nicht nur darum, den Agenten Werkzeuge an die Hand zu geben. Ebenso wichtig ist es, ihren logischen Ablauf so zu strukturieren, dass sie produktiv, schnell und zuverlässig sind. Bevor wir uns also damit befassen, wo diese Werkzeuge zu finden sind und wie sie funktionieren, wollen wir uns zunächst einmal ansehen, wie ein erfolgreicher KI-Agent auf hoher Ebene arbeitet!

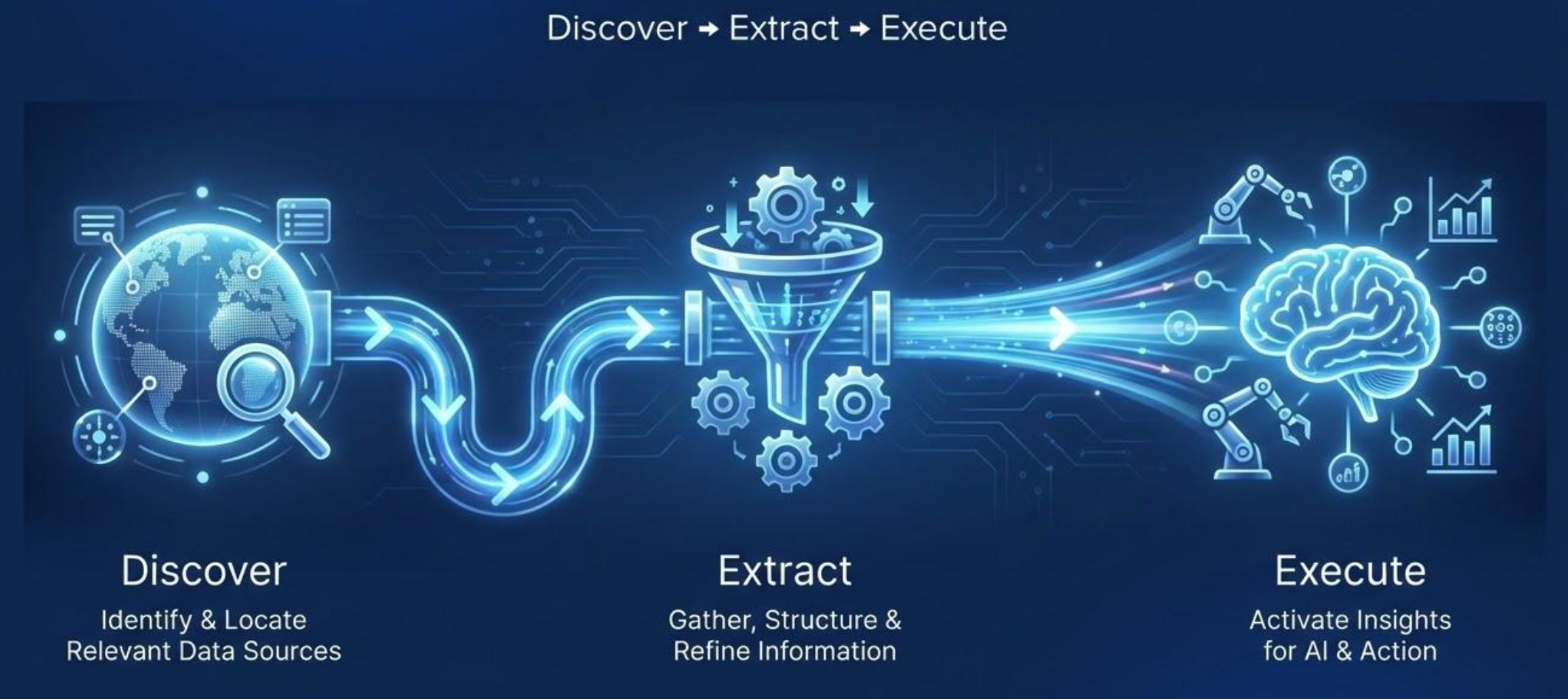

Agentische Wissenspipeline: Entdecken, extrahieren, ausführen

Denken Sie darüber nach, wie wir als Menschen die besten Ergebnisse erzielen. Wir arbeiten besser, wenn wir Zugang zu den richtigen Informationen und den richtigen Werkzeugen haben und wenn wir wissen, wie wir sie intelligent einsetzen können. Das gleiche Prinzip gilt für KI-Agenten.

Um unzuverlässiges Verhalten oder schlechte Ergebnisse zu vermeiden, benötigen agentenbasierte KI-Systeme Zugang zu aktuellen, überprüfbaren und genauen Informationen. Diese Informationen können dann mithilfe geeigneter Tools für die Interaktion mit der Außenwelt genutzt werden.

So intuitiv es auch klingt, ein fundiertes und praktisches agentenbasiertes KI-System folgt einer agentenbasierten Wissenspipeline. Diese besteht aus drei Kernphasen:

- Entdecken: Identifizieren und lokalisieren Sie relevante Datenquellen auf der Grundlage der jeweiligen Aufgabe. Das Ziel ist es, vertrauenswürdige und aktuelle Quellen zu finden, die die Entscheidungen des Agenten beeinflussen können.

- Extrahieren: Die Daten abrufen und in nutzbares Wissen umwandeln. Dazu gehört das Sammeln von Informationen, das Bereinigen und Filtern von Störsignalen, das Strukturieren unstrukturierter Daten und das Aggregieren der Ergebnisse in ein konsistentes Datenformat, das der Agent auswerten kann (in den meisten Fällen z. B. Markdown, Klartext oder JSON).

- Ausführen: Nutzen Sie das erworbene Wissen, um Entscheidungen und Maßnahmen voranzutreiben. Dazu kann das Generieren von Erkenntnissen, das Auslösen von Workflows oder die Interaktion mit Websites gehören, um das angestrebte Ziel zu erreichen.

Wichtig: Die ersten beiden Phasen werden im Allgemeinen als „agente Wissensakquisitionsphase” bezeichnet. In den meisten Anwendungen und Anwendungsfällen sind dies die wichtigsten Phasen (und, wie wir gleich sehen werden, auch die Phasen, in denen es häufig zu Problemen kommt).

Während der Phase der agentenbasierten Wissenserfassung sucht das System nach den für die Aufgabe relevantesten Daten, ruft sie ab und verfeinert sie. Dies wird in der Regel über ein spezielles agentenbasiertes RAG-System erreicht, das mehrere KI-Agenten koordiniert, um eine zielgerichtete und vertrauenswürdige Informationsgewinnung zu gewährleisten. Schließlich ergreift das agentenbasierte System Maßnahmen auf der Grundlage des zuvor gesammelten Kontexts und Wissens.

Wie KI-Agenten die agentenbasierte Wissenspipeline verfolgen

Beachten Sie, dass KI-Agenten in den allermeisten Fällen sehr autonom sind und über Denkfähigkeiten verfügen. Folglich folgen sie der Pipeline möglicherweise nicht immer streng linear. Stattdessen durchlaufen sie in der Regel einzelne Phasen und manchmal sogar alle drei Phasen.

Wenn beispielsweise die in der ersten Stufe gefundenen Daten als unzureichend oder von geringer Qualität angesehen werden, kann der Agent zusätzliche Suchvorgänge durchführen. Ebenso kann der Agent, wenn die Ergebnisse der Ausführungsstufe nicht zufriedenstellend sind, beschließen, zum Anfang zurückzukehren und seinen Ansatz zu verfeinern. Dies spiegelt wider, wie Menschen arbeiten, wenn sie nach qualitativ hochwertigen Ergebnissen streben.

Eine agentenbasierte Wissenspipeline ist daher nicht nur eine gerade Linie von „Entdecken” zu „Ausführen” (wie Sie es vielleicht in einer statisch codierten GenAI-Pipeline sehen). Gleichzeitig müssen Sie sich nicht um die manuelle Verwaltung dieses menschenähnlichen, iterativen Verhaltens kümmern. Das KI-Agenten-Framework oder die Bibliothek übernimmt das für Sie!

Unterstützte Anwendungsfälle

Agentische KI-Systeme, die auf kontinuierlicher Wissenserfassung basieren, sind tief in dem spezifischen Kontext verankert, in dem sie operieren müssen. Dieses Situationsbewusstsein hilft ihnen, eine lange Liste von Szenarien abzudecken, darunter:

| Anwendungsfall | Beschreibung |

|---|---|

| Agentische Anreicherung | Erweitern Sie Profile von Personen, Unternehmen oder Produkten in großem Umfang mit hoher Genauigkeit. |

| Alternative Daten | Agenten erfassen und verifizieren kontinuierlich Long-Tail-Marktsignale, um Erkenntnisse zu gewinnen, die über Standardquellen hinausgehen. |

| Automatisierte Marktanalyse | Analysieren Sie Trends, Preise und Nachfragesignale, um strategische Geschäftsentscheidungen zu treffen. |

| ESG-Tracking | Aggregieren Sie fragmentierte Umwelt-, Sozial- und Governance-Daten, um einen transparenten Überblick über die Nachhaltigkeitsauswirkungen eines Unternehmens zu erhalten. |

| IP- und Markenschutz | Durchsuchen Sie Marktplätze und Register, um unbefugte Markenverwendungen oder gefälschte Produkte aufzudecken. |

| Wettbewerbsanalyse | Erkennen Sie Veränderungen aus verschiedenen Quellen und decken Sie Trends und Wettbewerbsaktivitäten auf, die über das Offensichtliche hinausgehen. |

| Vertikale Suche | Durchsuchen und normalisieren Sie regelmäßig domänenspezifische Quellen in einem Live-Index, der stets auf dem neuesten Stand ist. |

| Überwachung gesetzlicher Vorschriften | Verfolgen Sie Vorschriften und Compliance-Aktualisierungen in Echtzeit über Regionen und Sektoren hinweg. |

| Bedrohungsinformationen | Identifizieren Sie Cybersicherheitsbedrohungen und aufkommende Risiken aus verschiedenen Online-Quellen. |

| Umfassende Recherche und Überprüfung | Sammeln Sie schnell Beweise, um Behauptungen in Dokumenten, Websites und Berichten genau zu überprüfen. |

| Einblicke in soziale Medien | Beobachten Sie Plattformen hinsichtlich Stimmung, aufkommenden Trends und Aktivitäten von Influencern. |

| Content-Kuration | Entdecken, filtern und fassen Sie relevante Artikel, Beiträge oder Nachrichten für Teams zusammen. |

| Analyse von Kundenfeedback | Aggregieren und analysieren Sie Bewertungen, Umfragen und Erwähnungen in sozialen Medien, um Produkte zu verbessern. |

| Patent- und IP-Recherche | Verfolgen Sie Patente, Anmeldungen und IP-Aktivitäten branchenübergreifend in Echtzeit. |

| Einblicke in Talente und Rekrutierung | Überwachen Sie die Verfügbarkeit von Kandidaten, deren Fähigkeiten und Markttrends, um fundiertere Einstellungsentscheidungen zu treffen. |

Wo KI-Agenten versagen und was sie zum Erfolg brauchen

Nachdem Sie nun die Bedeutung von agentenbasierter KI und die Erstellung eines effektiven Systems verstanden haben, ist es an der Zeit, die wichtigsten Herausforderungen und Anforderungen zu untersuchen.

Wichtigste Herausforderungen und Hindernisse

Zweifellos ist das Internet die größte, aktuellste und am häufigsten genutzte Datenquelle der Welt. Wir sprechen hier von geschätzten 64 Zettabyte (das sind 64 Billionen Gigabyte) an Informationen!

Für ein intelligentes agentenbasiertes KI-System gibt es praktisch keine Alternative zur direkten Suche und Abfrage von Daten aus dem Internet. Die Extraktion von Daten aus dem Internet (auch als Web-Scraping bezeichnet) ist jedoch mit zahlreichen Hindernissen verbunden…

Website-Betreiber sind sich des Wertes ihrer Daten sehr wohl bewusst. Deshalb werden die Informationen, selbst wenn sie öffentlich zugänglich sind, oft durch Anti-Scraping-Maßnahmen wie IP-Sperren, CAPTCHAs, JavaScript-Challenges, Fingerprinting-Analysen und andere Anti-Bot-Abwehrmaßnahmen geschützt.

Dies macht die Phase der agentenbasierten Wissenserfassung zu einer anspruchsvollen Aufgabe. KI-Agenten benötigen Tools, die nicht nur Daten aus den richtigen Webquellen lokalisieren und abrufen, sondern auch diese Schutzmaßnahmen automatisch umgehen und auf die erforderlichen Informationen in RAG-fähigen Datenformaten wie Markdown oder JSON zugreifen. Weitere Informationen finden Sie in unserem Tutorial zum Aufbau eines agentenbasierten RAG-Systems.

Die Ausführungsphase kann ebenso komplex sein, insbesondere wenn der Agent mit bestimmten Websites interagieren oder Online-Aktionen ausführen muss. Ohne die richtigen Tools können KI-Agenten leicht blockiert oder daran gehindert werden, ihre Aufgaben zu erfüllen.

Voraussetzungen für den Erfolg

Jetzt wissen Sie, dass KI-Agenten einen Internetzugang benötigen, um effektiv zu sein, und welche Herausforderungen sie bewältigen müssen. Aber was brauchen sie, um wirklich erfolgreich zu sein? Es reicht nicht aus, nur Tools für die Websuche, den Zugriff und die Interaktion bereitzustellen …

Um sinnvolle Ergebnisse zu erzielen, müssen die Tools, die KI-Agenten zur Verfügung stehen, stabil, skalierbar und widerstandsfähig sein. Denn ohne die richtige agentenbasierte KI-Technologie laufen Sie Gefahr, neue Probleme zu schaffen, anstatt Lösungen zu finden.

Um effektiv zu arbeiten, benötigen agentenbasierte KI-Systeme Tools für die Abfrage und Interaktion mit Webdaten, die Folgendes gewährleisten:

- Hohe Verfügbarkeit: Die zugrunde liegende Infrastruktur muss eine hohe Verfügbarkeit aufweisen, um Unterbrechungen oder Fehler während der Datenerfassung und -verarbeitung zu vermeiden.

- Hohe Erfolgsquote: Die Tools müssen Anti-Bot-Maßnahmen auf Websites umgehen, damit Agenten Suchmaschinen nutzen, Webdaten extrahieren und mit Seiten interagieren können, ohne blockiert zu werden.

- Hohe Parallelität: Viele Aufgaben umfassen das Abrufen von Daten aus mehreren Websites oder die gleichzeitige Durchführung mehrerer Suchanfragen. Eine skalierbare Infrastruktur ermöglicht es Agenten, viele Anfragen gleichzeitig auszuführen und so die Ergebnisse zu beschleunigen.

- Überprüfbare Informationen: KI-Agenten sollten mit den gängigen Suchmaschinen wie Google, Bing, Yandex und Baidu interagieren. So können sie unsere Art der Informationssuche nachahmen: Durchsuchen der Suchergebnisse und Verfolgen der relevantesten URLs. Dieser Ansatz führt zu einer Überprüfbarkeit der Daten, da Sie die gleichen Abfragen selbst wiederholen und die Informationen bis zu den ursprünglichen Seiten-URLs zurückverfolgen können.

- Aktuelle Daten: Web-Scraping-Tools müssen Informationen schnell aus jeder Webseite extrahieren, einschließlich Live-Datenfeeds.

- LLM-fähige Ausgabe: Daten sollten in strukturierten Formaten wie Markdown oder JSON geliefert werden. Die Einspeisung von rohem HTML in ein LLM führt zu schwächeren Ergebnissen, während saubere, strukturierte Daten genauere Schlussfolgerungen und Erkenntnisse ermöglichen.

Natürlich sind diese Anforderungen bedeutungslos, wenn der Anbieter keine klare Dokumentation, keinen reaktionsschnellen Support und keine nahtlose Integration mit KI-Tools bietet. Sie suchen nach der besten KI-fähigen Webdateninfrastruktur auf dem Markt? Genau hier kommt Bright Data ins Spiel!

Wie Bright Data KI-Agenten unterstützt, die Blockierungen vermeiden und ihre Ziele erreichen

Bright Data ist die führende Webdatenplattform und bietet KI-fähige Tools zum Auffinden, Abrufen, Extrahieren und Interagieren mit Daten von jeder öffentlichen Website.

Genauer gesagt unterstützt es agentenbasierte Pipelines durch ein umfassendes Angebot an Dienstleistungen und Lösungen. Mit diesen Tools können KI-Agenten das Web durchsuchen, Daten sammeln und mit Websites in großem Umfang interagieren, ohne blockiert zu werden. Sie lassen sich auch in eine Vielzahl von KI-Frameworks integrieren, darunter bekannte Optionen wie LangChain, LlamaIndex, CrewAI, Agno, OpenClaw und viele andere.

Alle diese Lösungen basieren auf einer unternehmensgerechten, unbegrenzt skalierbaren Infrastruktur, die von einem Proxy-Netzwerk mit über 150 Millionen IPs unterstützt wird. Die Plattform bietet eine Erfolgsquote von 99,99 % und eine Verfügbarkeit von 99,99 %. Darüber hinaus bietet Bright Data einen technischen Support rund um die Uhr sowie umfangreiche Dokumentationen und detaillierte Blog-Beiträge zu jeder Lösung.

Zusammen ermöglicht dies den Aufbau leistungsstarker KI-Agenten und KI-gestützter Systeme für den Live-Wissensgewinn. Lassen Sie uns nun untersuchen, wie Bright Data jede Phase der agentenbasierten Wissenspipeline unterstützt!

Entdecken

Bright Data unterstützt die Datenermittlungsphase mit:

- SERP-API: Liefert Echtzeit-Suchergebnisse aus mehreren Suchmaschinen, darunter Google, Bing, DuckDuckGo, Yandex und viele mehr. Gibt KI-Agenten die Möglichkeit, verifizierbare Quellen zu finden und kontextbezogene URLs zu verfolgen.

- Web Archive API: Bietet gefilterten Zugriff auf ein riesiges, kontinuierlich aktualisiertes Webarchiv mit mehreren Petabyte an Daten. Unterstützt das Abrufen von historischen HTML-Daten, Medien-URLs und mehrsprachigen Inhalten für Forschungs- und KI-Workflows.

Extrahieren

Bright Data unterstützt die Phase der Webdaten-Extraktion mit:

- Web Unlocker API: Umgeht automatisch Blockierungen mithilfe von KI-gesteuertem Fingerprinting, Rotierendem Proxy, Wiederholungsversuchen, CAPTCHA-Lösung und JavaScript-Rendering. Liefert zuverlässig öffentliche Webdaten in großem Umfang, in LLM-optimiertem Format und von jeder Webseite.

- Crawl API: Automatisiert das Crawlen der gesamten Website von einer einzigen URL aus. Entdeckt URLs, folgt ihnen und extrahiert statische und dynamische Inhalte in saubere, KI-fähige Formate wie JSON, Markdown oder HTML.

Ausführen

Bright Data unterstützt den Schritt der Agentenausführung mit:

- Agent Browser: Ein cloudbasierter, KI-fähiger Browser, mit dem autonome Agenten Websites navigieren, klicken, Formulare ausfüllen, Sitzungen verwalten und Daten extrahieren können, während CAPTCHAs, Anti-Bot-Abwehrmaßnahmen und Skalierung automatisch gehandhabt werden.

- Web MCP: Bietet KI-Agenten Zugriff auf über 60 Tools für die Datenextraktion, das Abrufen von Web-Feeds und die Seiteninteraktion innerhalb eines Cloud-Browsers. Unterstützt schnelle, vereinfachte Integrationen mit einer Vielzahl von KI-Lösungen und wird mit einer kostenlosen Stufe angeboten.

Fazit

In diesem Blogbeitrag haben Sie erfahren, warum agentenbasierte KI-Systeme auf dem Vormarsch sind und wie ihre zugrunde liegenden KI-Agenten produktionsreif, zuverlässig und erfolgreich sein können. Insbesondere haben Sie gesehen, wie wichtig es ist, Zugang zu den richtigen Tools zu bieten, um eine agentenbasierte Wissenspipeline zu unterstützen.

Es geht jedoch nicht nur um die Tools, die KI-Agenten verwenden können. Es geht auch um die zugrunde liegende Infrastruktur, die es diesen Tools ermöglicht, wertvoll und robust zu arbeiten. In dieser Hinsicht bietet Bright Data eine Architektur für KI auf Unternehmensniveau und Lösungen, die das gesamte Spektrum agentenbasierter Workflows unterstützen.

Melden Sie sich noch heute bei Bright Data an und beginnen Sie mit der Integration unserer agentenfähigen Webdaten-Tools!