Browser-Automatisierungstools sind für Entwickler, die Web-Scraper, Bots oder KI-Agenten entwickeln, die mit Websites interagieren müssen, unverzichtbar geworden. Während Open-Source-Tools wie Puppeteer und Playwright weit verbreitet sind, bietet der Agent Browser von Bright Data einen anderen Ansatz, der für Stealth, Skalierung und KI-native Workflows ausgelegt ist.

In diesem Leitfaden erfahren Sie mehr:

- Wie sich Agent Browser von Puppeteer und Playwright durch Stealth und Fingerprinting unterscheidet.

- Die integrierten Funktionen von Bright Data, wie z. B. die Proxy-Rotation und die automatische Sitzungsverarbeitung.

- Szenarien, in denen jedes Werkzeug seine Stärken und Schwächen zeigt.

- Die Grenzen von Agent Browser und traditionellen Frameworks und wann man sich für das eine oder das andere entscheidet.

Warum Agent Browser, Puppenspieler und Dramatiker vergleichen?

Die Browser-Automatisierung ist für Entwickler, die Scraper, Bots und KI-Agenten entwickeln, zur Standardlösung geworden. Ob es um das Sammeln von Daten aus dynamischen Webseiten, die Durchführung automatischer Anmeldungen oder die Ausführung sich wiederholender Aufgaben in großem Umfang geht, Browser-Frameworks sind heute ein wichtiger Bestandteil moderner Entwicklungsworkflows.

Zu den beliebtesten Tools in diesem Bereich gehören Puppeteer und Playwright, beides Open-Source-Bibliotheken auf Node.js-Basis, die eine High-Level-API zur Steuerung von Headless- oder Full-Browsern bieten. Puppeteer, das vom Chrome-Team gepflegt wird, ist für seine enge Integration mit Chromium bekannt, und Playwright, das von Microsoft entwickelt wurde, baut auf dieser Grundlage auf, indem es mehrere Browser (Chromium, Firefox und WebKit) unterstützt und fortschrittlichere Funktionen wie Multi-Page-Kontexte und integrierte Wartezeiten ermöglicht. Diese Tools haben sich aufgrund ihrer Flexibilität und Kontrolle, insbesondere bei der Skripterstellung benutzerdefinierter Workflows, weit verbreitet.

Da Websites jedoch immer aggressivere Mechanismen zur Erkennung von Bots entwickeln, verbringen viele Entwickler mehr Zeit damit, sich mit Herausforderungen wie Fingerprinting, CAPTCHA-Lösungen und Proxy-Rotation zu beschäftigen, als Geschäftslogik zu schreiben. An dieser Stelle kommt unser Agent Browser ins Spiel.

Der Agent Browser wurde speziell für KI-Agenten und Automatisierungs-Workflows entwickelt und abstrahiert einen Großteil der Arbeit auf niedriger Ebene, die Puppeteer- und Playwright-Benutzer manuell erledigen müssen. Es handelt sich um eine vollständige Browserumgebung, die entwickelt wurde, um echte Benutzer zu imitieren, mit Stealth, Proxy-Verwaltung, Sitzungspersistenz und CAPTCHA-Behandlung, die integriert sind. Sie ist Teil der breiteren Infrastruktur von Bright Data für die Sammlung von Webdaten im großen Maßstab und soll Entwicklern helfen, sich auf ihre Automatisierungsziele zu konzentrieren, anstatt sich mit den erforderlichen Installationen zu beschäftigen, um unentdeckt zu bleiben.

Hauptunterschiede: Tarnkappe und Fingerabdruck

Eine der größten Herausforderungen bei der Browser-Automatisierung ist heute die Vermeidung von Erkennung. Websites verwenden zunehmend ausgefeilte Bot-Erkennungssysteme, die alles überwachen, von der Abweichung der Browser-Fingerabdrücke bis zu Mausbewegungsmustern usw. Hier stoßen Tools wie Puppeteer und Playwright an ihre Grenzen.

Puppeteer und Playwright verfügen von Haus aus nicht über Stealth- oder Anti-Detection-Funktionen. Entwickler müssen oft manuell Tools wie puppeteer-extra-plugin-stealth einbinden, Proxys rotieren oder Header und Fingerprints ändern, um unerkannt zu bleiben. Selbst dann können die Erkennungsraten hoch bleiben, vor allem auf Websites mit fortgeschrittenem Bot-Schutz.

Agent Browser hingegen wurde mit Stealth als erstklassigem Merkmal entwickelt. Er führt Cloud-basierte Headful-Browsersitzungen aus, die echtes Benutzerverhalten imitieren, komplett mit menschenähnlichen Fingerabdrücken, natürlichen Bildlauf- und Interaktionsmustern und intelligenter Kopfzeilensteuerung. Jede Sitzung wird mit realistischen Browsereigenschaften gestartet, die auf den Standort, den Gerätetyp und die emulierte Browserversion abgestimmt sind.

Hier ist, was es ohne weiteres tut:

- Fingerabdruck-Spoofing: Agent Browser erstellt Browser-Fingerabdrücke, die echten Benutzerumgebungen ähneln (im Gegensatz zu den standardmäßigen Headless-Signaturen).

- CAPTCHA-Auflösung: Es behandelt automatisch Herausforderungen, wenn ein CAPTCHA erscheint, wodurch Unterbrechungen in automatisierten Abläufen reduziert werden.

- Proxy-Rotation: Er rotiert IP-Adressen und wiederholt Anfragen automatisch, wenn eine Blockierung festgestellt wird.

- Cookie- und Sitzungsverfolgung: Der Sitzungsstatus und die Cookies bleiben erhalten, wodurch die Erkennung von wiederholten Anfragen reduziert wird.

Diese Funktionen sind besonders wichtig beim Scraping von Websites mit dynamischen Layouts, Login-Gates oder personalisierten Inhalten. Zum Beispiel ein E-Commerce-Shop, der regionsspezifische Preise oder Verfügbarkeiten anzeigt. Auf solchen Plattformen können selbst kleine Inkonsistenzen im Browserverhalten zu Blockaden oder leeren Antworten führen. Mit Agent Browser müssen Entwickler keine Stealth-Plugins manuell konfigurieren oder Proxys rotieren, alles wird im Hintergrund verwaltet.

Diese enge Integration mit unserer Proxy-Infrastruktur bedeutet auch, dass Entwickler auf Inhalte von bestimmten geografischen Standorten aus zugreifen, Referrer-Header anpassen und langlebige Sitzungen aufrechterhalten können, was es zu einer starken Option für mehrstufige Agenten-Workflows macht.

Sitzungsverarbeitung und Authentifizierung

Die Sitzungsverwaltung erfolgt bei Puppeteer und Playwright größtenteils manuell; Entwickler müssen Cookies oder lokalen Speicher erfassen und wiederverwenden, Logik für die Login-Persistenz und Authentifizierung schreiben und Token oder CSRF-Schutz verwalten. Dies erhöht die Komplexität, insbesondere im großen Maßstab.

Agent Browser automatisiert die Aufrechterhaltung und Rotation von Sitzungen. Cookies und lokaler Speicher werden automatisch in der Cloud verwaltet, so dass der Sitzungsstatus über Seiten und Registerkarten hinweg ohne benutzerdefinierte Logik beibehalten wird. Wenn eine Sitzung blockiert wird, beginnt eine neue Sitzung mit einer neuen IP und einem neuen Fingerabdruck. Es ist kein Code für Wiederholungsversuche oder CAPTCHA-Verarbeitung erforderlich.

Durch diese Automatisierung werden IP-Sperren reduziert, Sitzungsausfälle minimiert und Entwickler können sich auf Automatisierungsaufgaben statt auf die Sitzungsverwaltung konzentrieren. Die Lösung ist außerdem in das Proxy-Netzwerk von Bright Data integriert, um eine einheitliche Identitätskontrolle zu gewährleisten.

Benutzerfreundlichkeit und Entwicklererfahrung

Einer der wichtigsten Faktoren, die Entwickler bei der Auswahl eines Browser-Automatisierungstools berücksichtigen, ist die Geschwindigkeit, mit der sie von der Einrichtung bis zur ersten erfolgreichen Ausführung gelangen. Mit Puppeteer und Playwright ist der Einstieg sehr einfach, wenn Sie bereits mit Headless Browsern gearbeitet haben. Die Installation der Bibliotheken, das Starten einer Browser-Instanz und das Navigieren auf einer Seite erfordert nur ein paar Zeilen Code. Sobald Sie jedoch Proxy-Unterstützung, CAPTCHA-Behandlung, Fingerprinting oder Session-Persistenz hinzufügen müssen, werden die Dinge komplexer. Oft müssen Sie zusätzliche Plugins installieren, Proxy-Bibliotheken konfigurieren, Cookies manuell verwalten und Fehler bei der Erkennung beheben.

Agent Browser wurde entwickelt, um diese Komplexität zu reduzieren. Die Integration kann über die API oder MCP erfolgen, ohne dass eine standortbezogene Konfiguration erforderlich ist. Es besteht keine Notwendigkeit, Ihre eigene Browser-Infrastruktur zu pflegen. Es ist nicht notwendig, Stealth-Plugins zusammenzuflicken oder IPs manuell zu rotieren, alles wird automatisch im Hintergrund erledigt.

Entwickler können zwischen einer Headful- oder Headless-Erfahrung wählen, mit programmatischer Kontrolle über die Sitzung von Anfang bis Ende. Für diejenigen, die codebasierte Workflows bevorzugen, ist Agent Browser mit Playwright, Puppeteer und Selenium kompatibel. Die unten stehenden Codebeispiele helfen Ihnen dabei, Agent Browser mit minimalen Reibungsverlusten in Ihr bestehendes System zu integrieren.

JavaScript:

const pw = require('playwright');

const SBR_CDP = 'wss://brd-customer-CUSTOMER_ID-zone-ZONE_NAME:[email protected]:9222';

async function main() {

console.log('Connecting to Scraping Browser...');

// Scraping browswer here...

const browser = await pw.chromium.connectOverCDP(SBR_CDP);

try {

const page = await browser.newPage();

console.log('Connected! Navigating to <https://example.com>...');

await page.goto('<https://example.com>');

console.log('Navigated! Scraping page content...');

const html = await page.content();

console.log(html);

} finally {

await browser.close();

}

}

main().catch(err => {

console.error(err.stack || err);

process.exit(1);

});

const puppeteer = require('puppeteer-core');

const SBR_WS_ENDPOINT = 'wss://brd-customer-CUSTOMER_ID-zone-ZONE_NAME:[email protected]:9222';

async function main() {

console.log('Connecting to Scraping Browser...');

const browser = await puppeteer.connect({

// Scraping browswer here...

browserWSEndpoint: SBR_WS_ENDPOINT,

});

try {

const page = await browser.newPage();

console.log('Connected! Navigating to <https://example.com>...');

await page.goto('<https://example.com>');

console.log('Navigated! Scraping page content...');

const html = await page.content();

console.log(html)

} finally {

await browser.close();

}

}

main().catch(err => {

console.error(err.stack || err);

process.exit(1);

});

const { Builder, Browser } = require('selenium-webdriver');

const SBR_WEBDRIVER = '<https://brd-customer-CUSTOMER_ID-zone-ZONE_NAME:[email protected]:9515>';

async function main() {

console.log('Connecting to Scraping Browser...');

const driver = await new Builder()

.forBrowser(Browser.CHROME)

// Scraping browswer here...

.usingServer(SBR_WEBDRIVER)

.build();

try {

console.log('Connected! Navigating to <https://example.com>...');

await driver.get('<https://example.com>');

console.log('Navigated! Scraping page content...');

const html = await driver.getPageSource();

console.log(html);

} finally {

driver.quit();

}

}

main().catch(err => {

console.error(err.stack || err);

process.exit(1);

});

Python:

import asyncio

from playwright.async_api import async_playwright

SBR_WS_CDP = 'wss://brd-customer-CUSTOMER_ID-zone-ZONE_NAME:[email protected]:9222'

async def run(pw):

print('Connecting to Scraping Browser...')

# Scraping browswer here...

browser = await pw.chromium.connect_over_cdp(SBR_WS_CDP)

try:

page = await browser.new_page()

print('Connected! Navigating to <https://example.com>...')

await page.goto('<https://example.com>')

print('Navigated! Scraping page content...')

html = await page.content()

print(html)

finally:

await browser.close()

async def main():

async with async_playwright() as playwright:

await run(playwright)

if __name__ == '__main__':

asyncio.run(main())

const puppeteer = require('puppeteer-core');

const SBR_WS_ENDPOINT = 'wss://brd-customer-CUSTOMER_ID-zone-ZONE_NAME:[email protected]:9222';

async function main() {

console.log('Connecting to Scraping Browser...');

const browser = await puppeteer.connect({

# Scraping browswer here...

browserWSEndpoint: SBR_WS_ENDPOINT,

});

try {

const page = await browser.newPage();

console.log('Connected! Navigating to <https://example.com>...');

await page.goto('<https://example.com>');

console.log('Navigated! Scraping page content...');

const html = await page.content();

console.log(html)

} finally {

await browser.close();

}

}

main().catch(err => {

console.error(err.stack || err);

process.exit(1);

});

from selenium.webdriver import Remote, ChromeOptions

from selenium.webdriver.chromium.remote_connection import ChromiumRemoteConnection

SBR_WEBDRIVER = '<https://brd-customer-CUSTOMER_ID-zone-ZONE_NAME:[email protected]:9515>'

def main():

print('Connecting to Scraping Browser...')

# Scraping browswer here...

sbr_connection = ChromiumRemoteConnection(SBR_WEBDRIVER, 'goog', 'chrome')

with Remote(sbr_connection, options=ChromeOptions()) as driver:

print('Connected! Navigating to <https://example.com>...')

driver.get('<https://example.com>')

print('Navigated! Scraping page content...')

html = driver.page_source

print(html)

if __name__ == '__main__':

main()

Das Ziel ist einfach: Die Standardeinstellungen sollen eliminiert werden, damit sich die Entwickler auf die eigentliche Aufgabe der Automatisierung konzentrieren können und nicht auf die Frage, wie man sie zuverlässig am Laufen hält.

Unter der Haube: Eingebaute Funktionen mit brillanten Daten

Was Agent Browser von anderen unterscheidet, ist das, was bereits beim Starten der Sitzung enthalten ist.

- DieProxy-Rotation wird automatisch durchgeführt. Jede Sitzung wird durch unser umfangreiches Proxy-Netzwerk unterstützt, das über 150 Millionen private IPs in 195 Ländern umfasst.

- Browser-Fingerprinting ist vom Design her menschenähnlich, vermeidet kopflose Verräter und emuliert reale Umgebungen (bis hin zu Gerät, Betriebssystem und Browser-Version).

- Die CAPTCHA-Lösung ist integriert, es sind keine externen Dienste erforderlich, und es gibt keine fehlgeschlagenen Sitzungen, die aufgrund von visuellen Herausforderungen hängen bleiben.

- Die Persistenz der Sitzungen ist konsistent. Registerkarten, Cookies und lokaler Speicher werden beibehalten, was für Aufgaben wie authentifiziertes Scraping oder schrittweise Workflows entscheidend ist.

- Mitder Verweis- und Header-Kontrolle können Sie Besuche von bekannten oder vertrauenswürdigen Quellen simulieren, was in Situationen hilfreich ist, in denen HTTP-Header die Seitenauslieferung beeinflussen.

All dies ist in einer standardisierten, cloudbasierten Umgebung verpackt, sodass Sie unabhängig von Ort und Zeit der Sitzung eine konsistente Leistung erhalten. Sie ist skalierbar, API-zugänglich und eng in die breitere Datenpipeline integriert, sodass die Ausgabe sofort KI-fähig ist, egal ob strukturiert oder roh, in Echtzeit oder als Batch.

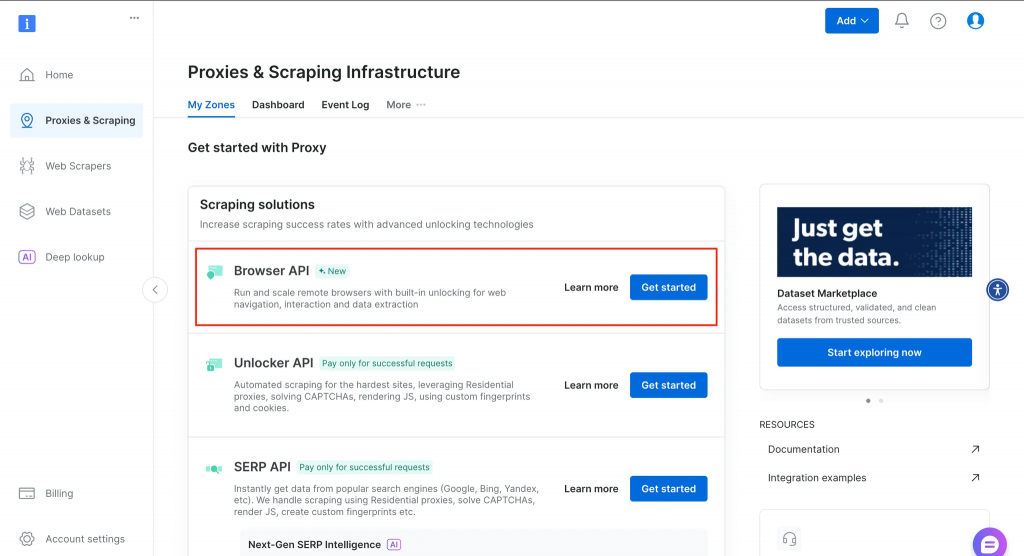

Im Folgenden finden Sie einen Überblick über die Funktionen, die Sie nach der Einrichtung eines Kontos in Ihrem Dashboard finden.

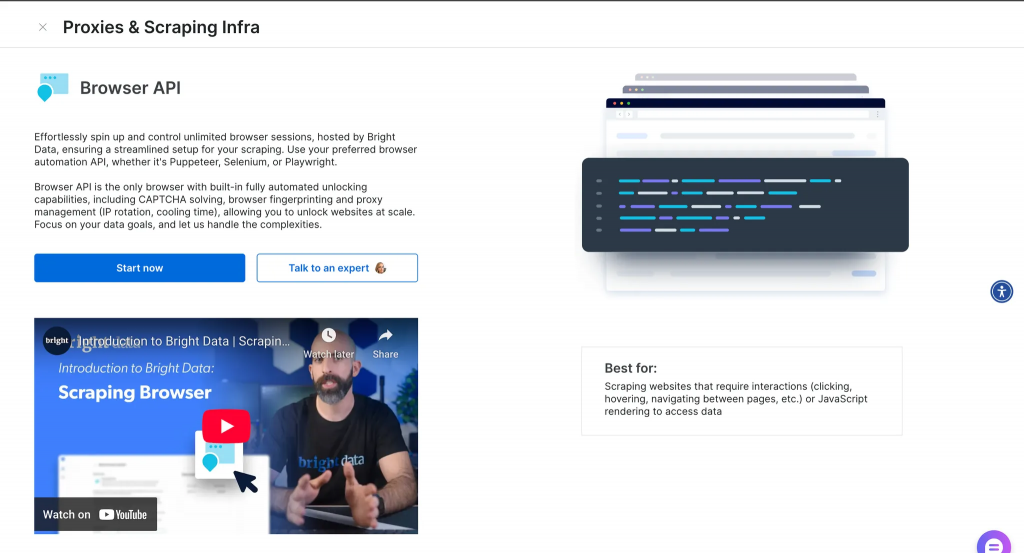

Wenn Sie auf “Mehr erfahren” klicken, erhalten Sie weitere Informationen, wie unten dargestellt.

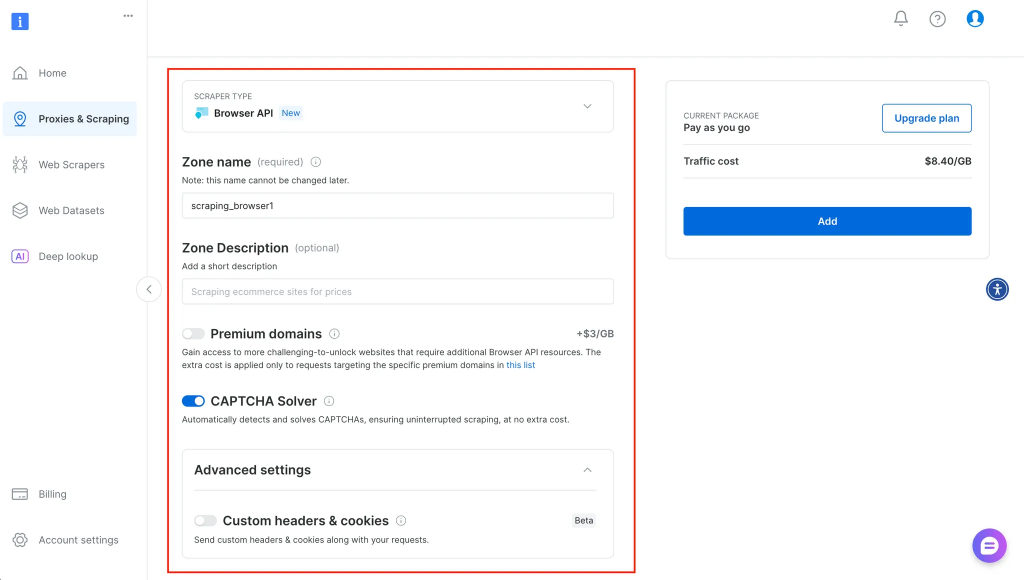

Nachdem Sie auf Start geklickt haben, werden Sie weitergeleitet, wo Sie weitere Informationen über Ihren Dienst eingeben und ihn entsprechend konfigurieren können (siehe unten):

Die Wahl des richtigen Werkzeugs: Wann jedes sinnvoll ist

Jedes Werkzeug hat seine Berechtigung, und wenn man weiß, wann man das eine und wann das andere einsetzen sollte, kann man Zeit und Frustration sparen.

Verwenden Sie Agent Browser, wenn:

- Sie müssen mit fortgeschrittenen Anti-Bot-Mechanismen umgehen können, ohne eigene Tarnschichten zu erstellen.

- Ihre Arbeitsabläufe umfassen mehrstufige Aufgaben, die Sitzungspersistenz erfordern (z. B. Anmeldungen, Formularübertragungen).

- Sie möchten Hunderte oder Tausende von Browsersitzungen über verschiedene Standorte hinweg starten und skalieren.

- Sie sollten sich lieber darauf konzentrieren, was der Agent tut, und nicht darauf, wie Sie seine Infrastruktur verwalten.

Bleiben Sie bei Puppenspieler oder Dramaturg, wenn:

- Ihre Aufgabe ist klein, schnell und lokal, z. B. ein Skript, das ein paar Schlagzeilen abruft oder Tests in CI automatisiert.

- Sie möchten die volle Kontrolle über die Browserumgebung und benötigen keine integrierte Freigabe.

- Sie arbeiten in einer Offline- oder Sicherheitsumgebung, in der die Verwendung eines Remote-Browsers nicht möglich ist.

In manchen Fällen ist ein hybrider Ansatz am besten geeignet. So können Sie beispielsweise Playwright-Skripte lokal ausführen, aber Bright Data-Proxys für die IP-Rotation und das Geotargeting verwenden. Oder Sie verwenden die Web MCP für hochriskante Ziele und Open-Source-Frameworks für reibungsarmes Scraping.

Beschränkungen und Überlegungen

Kein Werkzeug ist perfekt, und jedes bringt Kompromisse mit sich.

Da Agent Browser cloudbasiert ist, eignet er sich nicht für die Offline-Nutzung oder für Umgebungen, in denen die Datenlokalisierung wichtig ist. Für Teams, die in regulierten Branchen oder mit eingeschränkten Netzwerken arbeiten, kann die lokale Ausführung von Browsern immer noch bevorzugt werden.

Puppeteer und Playwright sind zwar flexibel, müssen aber ständig gewartet werden, da sich die Websites weiterentwickeln. Neue Bot-Erkennungstechniken oder Layout-Änderungen machen bestehende Skripte oft unbrauchbar, insbesondere wenn Stealth-Plugins veraltet sind. Und mit zunehmender Größe kann die Wartung der Browser-Infrastruktur, das Rotieren von IPs und das Verhindern von Blockierungen zu einer Vollzeitaufgabe werden.

Es sollte auch bedacht werden, dass Agent Browser für öffentlich zugängliche Websites und Automatisierungsaufgaben im Einklang mit ethischem Scraping entwickelt wurde. Er ist nicht dafür gedacht, Login-Walls ohne Erlaubnis zu umgehen oder Inhalte hinter Paywalls zu scrapen.

Schlussfolgerung und nächste Schritte

Die Wahl zwischen Agent Browser, Puppeteer und Playwright hängt davon ab, was Ihr Arbeitsablauf erfordert. Wenn Sie Unauffälligkeit, Skalierbarkeit und Einfachheit benötigen, bietet Agent Browser Automatisierung ohne großen Aufwand. Wenn Sie etwas Schnelles und Lokales mit voller Kontrolle erstellen möchten, sind Puppeteer und Playwright solide Optionen. In jedem Fall ist es wichtig zu verstehen, wie sie sich unterscheiden, insbesondere in Bezug auf Sitzungsverwaltung, Fingerprinting und Infrastruktur, um Zeitverschwendung und fehlerhafte Abläufe zu vermeiden.

Sie können den Agent Browser erkunden oder ihn mit Playwright, Puppeteer oder sogar MCP mit Ihrem bestehenden Automatisierungsstack verbinden. Weitere Hintergrundinformationen finden Sie in unserem Leitfaden zum Web-Scraping mit ChatGPT oder zur Erstellung von Agenten mit MCP.