In diesem Artikel erfahren Sie Folgendes:

- Die Definition eines No-Code Web-Scraping-Tool

- Wichtige Faktoren, die beim Vergleich von No-Code-Scraping-Tools zu beachten sind

- Die besten No-Code-Web-Scraper am Markt

Dann legen wir mal los!

Was ist No-Code Web-Scraper?

Ein No-Code-Web-Scraper ist ein Tool, mit dem sich Daten von Websites extrahieren lassen, ohne dafür irgendwelche Programmierkenntnisse zu benötigen. Diese Lösungen nutzen eine Point-and-Click-Schnittstelle, um die Scraping-Logik auf Websites visuell zu definieren. Alternativ dazu bieten sie Vorlagen für beliebte Websites an.

No-Code-Web-Scraper generieren den erforderlichen Code im Hintergrund, wodurch die Datenextraktion nahtlos erfolgt. Diese Schlichtheit ermöglicht es Privatpersonen und Unternehmen, schnell und effizient wertvolle Daten zu erfassen.

Gängige Arten von No-Code-Web-Scraping-Lösungen sind:

- Desktop-Anwendungen: Eine Software, die Sie direkt auf Ihrem Computer installieren müssen und die eine Vielzahl von Funktionen für die Datenextraktion bietet.

- Cloud-Anwendungen: Diese werden über das Internet betrieben und müssen nicht auf einem lokalen Rechner installiert werden. Die Anwendungen gewährleisten eine hohe Skalierbarkeit und die Integration mit anderen Online-Diensten.

- Browser-Erweiterungen: Sie lassen sich in Webbrowser wie Chrome oder Firefox integrieren, um Daten direkt aus der von Ihnen angezeigten Website zu extrahieren.

Wenn Sie stattdessen lieber selbst Code schreiben möchten, sollten Sie sich unsere Liste der besten Web-Scraping-Tools ansehen.

Zu berücksichtigende Aspekte beim Vergleich von No-Code-Scrapern

Nachfolgend finden Sie die wichtigsten Elemente, auf die Sie bei der Bewertung von No-Code-Web-Scraping-Tools achten sollten:

- Hauptziel: Eine Kurzbeschreibung dessen, was das Tool erreichen soll.

- Funktionen: Auflistung der wichtigsten Fähigkeiten und Funktionalitäten des Tools.

- Plattformen: Betriebssysteme, Browser und andere Umgebungen, in denen das Tool verfügbar ist.

- Vorlagen: Unterstützte Websites, Plattformen und Dienste, die das Tool scrapen kann.

- Kostenlose Option: Ob das Tool einen kostenlosen Plan oder eine Testphase anbietet, um seine Funktionen zu testen, bevor Sie sich für einen kostenpflichtigen Plan entscheiden.

- Preise: Eine Übersicht der Preisstruktur des No-Code-Web-Scrapers.

- Benutzerbewertungen: Bewertungen und Feedback von Benutzern auf Websites wie Trustpilot, Capterra oder dem Chrome Web Store.

Die besten No-Code Web-Scraping-Tools

Sehen Sie sich unsere Liste der besten No-Code-Web-Scraping-Tools an, die wir anhand der oben genannten Kriterien ausgewählt und eingestuft haben.

1. Bright Data

Bright Data gehört mit seinem ausgedehnten Proxy-Netzwerk aus Millionen von IPs zu den führenden Anbietern bei der Erfassung von Webdaten Gestützt auf diese zuverlässige Infrastruktur, bietet das Unternehmen verschiedene Web-Scraping-Tools an. Dazu gehören No-Code-Scraper, eine Lösung für technisch weniger versierte Benutzer, die auf unkomplizierte Weise Daten aus Websites extrahieren möchten.

Da No-Code-Scraper Dutzende von Vorlagen unterstützt, lassen sich mit nur wenigen Klicks Daten aus vielen Websites extrahieren. Die extrahierten Daten können in verschiedenen Dateitypen formatiert und direkt an Ihren Cloud-Speicher gesendet oder lokal heruntergeladen werden.

Unter all den No-Code-Scraping-Anbietern ist Bright Data der einzige, der ein Pay-as-you-go-Modell anbietet, d. h. Sie zahlen nur das, was Sie nutzen. Bright Data ist außerdem der einzige Anbieter, der die DSGVO- und CCPA-Richtlinien vollständig einhält und ethische Web-Scraping-Praktiken verfolgt.

Integrierte Anti-Bot-Bypass-Funktionen, nahtlose Kompatibilität mit Proxy-Netzwerken, erstklassiger, reaktionsschneller Support sowie eine große Auswahl an Vorlagen machen den No-Code-Scraper von Bright Data zur ersten Wahl für No-Code-Scraping auf dem Markt!

Hauptziel: Vereinfachte, bedarfsorientierte Datenerfassung für jedermann. Behalten Sie die volle Kontrolle, Flexibilität und Skalierbarkeit, ohne sich Gedanken über die Infrastruktur, Proxy-Server oder Blockierungen zu machen

Features:

- Intuitive Benutzeroberfläche zum einfachen Sammeln und Verwalten von Daten

- Bearbeitung von Massenanfragen

- Datenformate: JSON, CSV und weitere

- Integrierte Lösungen zur Umgehung von Bots sowie zur Lösung von CAPTCHAs

- 99,99 % Uptime

- Unterstützt durch ein Netzwerk von über 150 million+ privaten Proxy-IPs in 195 Ländern

- Möglichkeit zur bedarfsorientierten Datenerfassung

- DSGVO- und CCPA-konform

- Globaler Support rund um die Uhr

Plattformen: Plug-and-Play-Cloud-Tool auf allen Browsern verfügbar

Vorlagen: LinkedIn-Scraper, Crunchbase-Scraper, Indeed-Scraper, Twitter-Scraper, Instagram-Scraper, TikTok-Scraper, Shopee-Scraper, Walmart-Scraper, Amazon-Scraper, Social-Media-Scraper, E- Commerce-Scraper, Immobilien-Scraper, und viele mehr.

Kostenlose Option: Kostenlose Testversion verfügbar

Preise: Ab 1 $/1K Datensätze

Benutzerbewertungen: 4,6/5 (756 Bewertungen) auf Trustpilot

2. Octoparse

Octoparse ist ein bedeutender Akteur im Bereich des No-Code Web-Scraping. Es bietet eine Software, mit der unstrukturierte Daten von beliebigen Websites abgerufen und in strukturierte Datensätze umgewandelt werden können. Einmal installiert, können Sie entweder aus Hunderten von verfügbaren Vorlagen wählen oder Ihre eigenen erstellen. Diese benutzerdefinierten Aufgaben zur Datenextraktion werden über eine einfache Point-and-Click-Benutzeroberfläche definiert.

Hauptziel: Eine Web-Scraping-Lösung ohne Programmierung, die Websites mit nur wenigen Klicks in strukturierte Daten umwandelt.

Features:

- Automatische Schleifenfunktionen

- Zahlreiche Vorlagen zum Scrapen von Daten aus beliebten Websites

- KI-gesteuerter Assistent für Web-Scraping

- Cloud-Automatisierung rund um die Uhr zur Planung von Scrapern

- Scraping-Herausforderungen mit IP-Rotation, CAPTCHA-Auflösung

- Automatische IP-Rotation und CAPTCHA-Auflösung

- Unterstützung für endloses Scrollen, Paginierung, Dropdown, Hover und zahlreiche andere Simulationen

Plattformen: Desktop-Anwendung für Windows und macOS

Vorlagen: Hunderte von Vorlagen für Google Maps, Amazon, Twitter, Glassdoor, LinkedIn, Zillow, YouTube und viele andere Websites

Kostenlose Option: Kostenloser Plan mit begrenzten Aufgaben

Preise: Ab 99 $/Mo.

Benutzerbewertungen: 4,6/5 (94 Bewertungen) auf G2

3. Listly

Listly ist eine hoch bewertete No-Code-Scraping-Erweiterung für Google Chrome. Ähnlich wie bei anderen Scraping-Erweiterungen lassen sich hiermit während des Surfens automatisch Daten von Websites abrufen. Zwar bietet die Erweiterung keine Vorlagen für bestimmte Websites, aber dafür unterstützt sie Vorlagen für spezifische Benutzerinteraktionen. Des Weiteren stehen Lernvideos zur Verfügung, mit denen Sie eine effektive Nutzung des Tools erlernen können.

Hauptziel: Scrapen von Daten mit nur einem Klick. Bleiben Sie eingeloggt, um Daten auf Ihrer Datentafel zu verwalten

Features:

- Möglichkeit, Daten aus mehreren Registerkarten zu extrahieren

- Stapelverarbeitung für Datenextraktion aus mehreren URLs

- Aufgabenplanung

- Automatische Scroll- und Klick-Funktionen

- Proxy-Integration

Plattformen: Erweiterung für Google Chrome

Vorlagen: Vorlagen für bestimmte Interaktionen (z. B. Paginierung, Dropdowns usw.), jedoch nicht für bestimmte Websites

Kostenlose Option: Kostenloser Plan mit Beschränkung auf 10 URLs/Tag

Preise: Ab 30 $/Mo.

Benutzerbewertungen: 4,7/5 (625 Bewertungen) auf Google Web Store

4. Apify

Apify ist eine Plattform für die Bereitstellung von Web-Scraping-Agenten, den sogenannten „Akteuren“. Diese können öffentlich zugänglich sein und von der Community zum Erfassen von Daten aus zahlreichen Websites genutzt werden. Derzeit sind über 1.500 Akteure auf dem Marktplatz verfügbar. Diese können direkt vom Apify-Dashboard aus verwendet werden.

Der Funktionsumfang und das Preisniveau dieser No-Code-Lösungen variieren je nach ausgewähltem Akteur, was einen Vergleich von Apify mit anderen No-Code-Web-Scrapern ziemlich erschwert.

Hauptziel: Eine umfassende Plattform, über die Entwickler Web-Scraping- und Browser-Automatisierungstools entwickeln, einsetzen und überwachen können

Features:

- Integrierter Proxy-Pool

- Abhängig vom gewählten Akteur

Plattformen: Serverlose Cloud-Programme, die über den Browser ausgeführt werden können

Vorlagen: Über 1,5k vorgefertigte Web-Scraper-Vorlagen für beliebte Websites

Kostenlose Option: Kostenloser Plan mit eingeschränkten Optionen

Preise: Ab 49 $/Mo.

Benutzerbewertungen: 4,8/5 (192 Bewertungen) auf Capterra

5. Web Automation

Web Automation ist eine Cloud-Plattform, die Websites in Tabellenkalkulationen umwandelt. Anhand von vorgefertigten Vorlagen öffnet sie die Tür zum Daten-Scraping auf über 400 Websites. Die extrahierten Daten können heruntergeladen, an Ihren bevorzugten Cloud-Anbieter gesendet bzw. über eine API abgerufen werden.

Falls Ihre Zielseite nicht unterstützt wird, können Sie über eine intuitive Benutzeroberfläche einen eigenen Scraper erstellen. Die wichtigsten Nachteile dieser Lösung sind die begrenzte Anzahl von Online-Bewertungen und ihr relativ hoher Einstiegspreis.

Hauptziel: Bereitstellung vorgefertigter Web-Scraper und Extraktion von Daten aus jeder beliebigen Website in nur wenigen Klicks, ganz ohne Programmieraufwand

Features:

- Ein-Klick-Scraping auf über 400 Websites

- Erstellung von Extraktoren über eine Point-and-Click-Oberfläche

- Herunterladen von Daten in CSV, Excel, JSON oder XML

- Datenübermittlung an Shopify, Dropbox, Google Sheets und andere

- Integrierte IP-Rotation und reCAPTCHA-Löser

Plattformen: Cloud-Plattform auf allen Browsern verfügbar

Vorlagen: 201 vordefinierte Extraktoren für Amazon-, E-Commerce-, Investment-, Lern-, Marketing-, Marktplatz-, Immobilien-, Rekrutierungs-, Bewertungs-, Social-Media- und Reise-Websites

Kostenlose Option: 14-tägige kostenlose Testversion

Preise: Ab 74 $/Mo.

Benutzerbewertungen: 4,8/5 (24 Bewertungen) auf Capterra

6. Web-Scraper

Der Web-Scraper ist Point-and-Click-Tool zur Datenextraktion und steht als Chrome- und Firefox-Browsererweiterung zur Verfügung. Mit diesem Tool lassen sich Daten sowohl manuell als auch automatisch im Browser extrahieren, mit der Option, diese Aufgaben in der Cloud auszuführen.

Verglichen mit anderen No-Code-Web-Scraping-Erweiterungen der Liste ist es die einzige, die Firefox unterstützt. Negativ anzumerken ist, dass nicht alle Bewertungen im Google Web Store sehr positiv ausfallen.

Hauptziel: Für den regulären und planmäßigen Einsatz zur Extraktion großer Datenmengen und zur einfachen Integration in andere Systeme konzipiert

Features:

- Aufgabenautomatisierung in der Cloud

- Fähigkeit, Aufgaben parallel auszuführen

- Unterstützt die Ausführung von JavaScript

- CSV-, XLSX-, JSON-Export

- Proxy-Integration

- Datenexport aus Dropbox, Google Sheets, Google Drive und Amazon S3

Plattformen: Erweiterung für Google Chrome und Firefox

Vorlagen: Keine Vorlagen

Kostenlose Option: 7-tägige kostenlose Testversion mit eingeschränkten Funktionen

Preise: Ab 50 $/Mo.

Benutzerbewertungen: 4,0/5 (882 Bewertungen) auf Google Web Store

7. Magical

Magical ist eine Google-Chrome-Erweiterung für No-Code-Web-Scraping. Mit dieser Erweiterung können Sie Daten aus einer Website auswählen, diese extrahieren und sie direkt an Google Sheets senden. Obwohl es keine Vorlagen gibt und der Funktionsumfang begrenzt ist, erhält sie viele positive Bewertungen und bietet einen attraktiven Einstiegspreis. Es handelt sich insbesondere um einen der erschwinglichsten No-Code-Scraper der Liste.

Hauptziel: Informationen aus jeder beliebigen Website scrapen und diese per Mausklick in Ihre Datenbank übertragen. Keinerlei Aufwand mit Code oder rechtlich fragwürdigen Umgehungslösungen

Features:

- Klicken Sie einfach auf das, was Sie scrapen möchten

- Integration mit Google Sheet

- Möglichkeit, die gescrapten Daten per Mausklick auf ein Webformular zu übertragen

Plattformen: Erweiterung für Google Chrome

Vorlagen: Keine Vorlagen, jedoch Möglichkeit, eigene Scraper für Millionen von Websites zu erstellen

Kostenlose Option: Kostenloser Plan mit begrenzter Anzahl monatlicher Automatisierungen

Preise: Ab 6,50 $/Mo.

Benutzerbewertungen: 4,5/5 (3,6k Bewertungen) im Chrome Web Store

8. ParseHub

ParseHub ist eine codefreie Desktop-Anwendung für Web-Scraping. Der Prozess der Datenextraktion erfolgt in drei Schritten:

- Navigieren Sie zu den gewünschten Websites in einem integrierten Browser

- Wählen Sie per Mausklick die gewünschten Elemente aus und legen Sie die zu extrahierenden Daten fest.

- Exportieren Sie die gescrapten Daten in für den Menschen lesbare Formate wie CSV oder JSON.

Die Anwendung unterstützt auch macOS und Linux, liegt preislich jedoch weit über dem Marktdurchschnitt.

Hauptziel: Formulare durchsuchen, Dropdown-Menüs öffnen, sich bei Websites anmelden, auf Karten klicken und Websites mit unendlichem Scrollen, Tabs und Pop-ups verwalten, um Ihre Daten zu scrapen

Features:

- Geplante Abläufe

- Automatische IP-Rotation

- Unterstützung für interaktive Websites

- Unterstützung für bedingte Anweisungen und Ausdrücke

- Unterstützt XPath, RegEx und CSS-Selektoren

- Automatische Datenextraktion aus Tabellen

- Datenextraktion aus Node-Text und HTML-Attributen

Plattformen: Desktop-Anwendung für Windows, macOS und Linux

Vorlagen: Keine Vorlagen

Kostenlose Option: Kostenloser Plan mit eingeschränkten Optionen

Preise: Ab 189 $/Mo.

Benutzerbewertungen: 4,5/5 (15 Bewertungen) auf Capterra

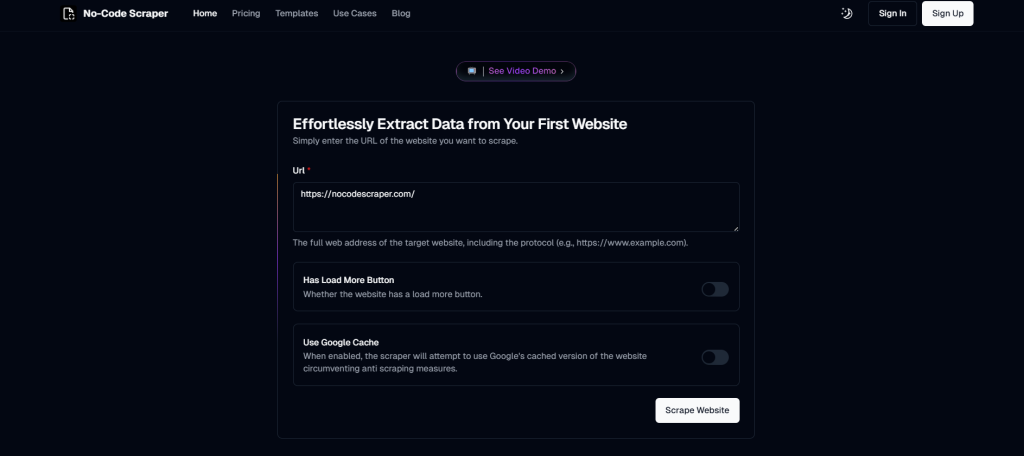

9. No-Code-Scraper

Beim No-Code-Scraper handelt es sich um eine neuartige Lösung in der Scraping-Branche. Das Tool nutzt KI-Modelle, um Scraper zu erstellen, die Daten von den meisten Websites abrufen können. Derzeit sind Dutzende von Vorlagen verfügbar, wobei allerdings noch einige Kernfunktionen fehlen. Obwohl der Preis wettbewerbsfähig ist, gibt es noch keine Bewertungen zu diesem Produkt.

Hauptziel: Nahtlose Extraktion von Daten aus beliebigen Websites anhand von nur wenigen einfachen Eingaben

Features:

- Datenexport nach CSV, JSON oder Excel

- Proxy-Integration

- KI-basierte Datenextraktion

Plattformen: KI-basierte Cloud-Plattform auf allen Browsern verfügbar

Vorlagen: Dutzende von Vorlagen für ProductHunt, Chrome Web Store, Apple App Store und andere

Kostenlose Option: Kostenlose Testversion

Preise: Ab 16,99 $/Mo.

Benutzerbewertungen: – (0 Bewertungen)

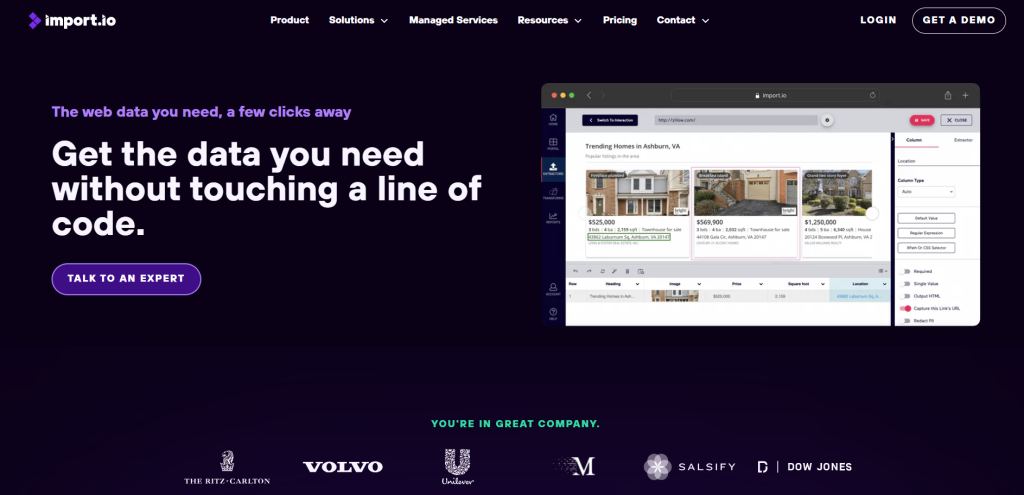

10. Import.io

Import.io ist eine Cloud-basierte Plattform, welche die Umwandlung von halbstrukturierten Informationen aus Webseiten in strukturierte Daten rationalisieren soll. Diese Daten können für beliebige Zwecke verwendet werden, von der Unterstützung bei Geschäftsentscheidungen bis hin zur Integration anderer Plattformen über eine REST-API.

Web-Scraping-Aufgaben können direkt auf der Import.io-Website visuell eingerichtet und verwaltet werden, ohne dass hierfür Code erforderlich ist. Beachten Sie bitte, dass sowohl das Preismodell als auch die Bewertungen nicht unbedingt ideal sind.

Hauptziel: Die benötigten Daten abrufen, ohne eine Zeile Code berühren zu müssen

Features:

- Hochwertige Proxy-Integration

- Länderspezifische Extraktoren

- Automatische CAPTCHA-Auflösung

- E-Mail-Benachrichtigungen

- Aufgabenplanung

- Automatische Paginierung

Plattformen: Webbasierte, auf allen Browsern verfügbare Plattform

Vorlagen: Keine Vorlagen, aber Point-and-Click-Auswahl und Trainingsoberfläche

Kostenlose Option: 14-tägige kostenlose Testversion

Preise: Ab 399 $/Mo.

Benutzerbewertungen: 3,6/5 (16 Bewertungen) auf Capterra

Bester No-Code-Web-Scraper: Übersichtstabelle

Einen kurzen Überblick der besten No-Code-Web-Scraping-Tools finden Sie in der folgenden Tabelle:

| No-Code-Tool | Art des Tools | Features | Vorlagen | Kostenlose Option | Pay-as-you-go-Tarif | Compliance | Plattformen | Bewertungen | Preise |

| Bright Data | Cloud-Anwendung | Unmengen | Viele | ✔️ | ✔️ | DSGVO, CCPA | Alle Browser | 4,6/5 (756 auf Trustpilot) | Ab 1 $/1K Datensätze |

| Octoparse | Desktop-Anwendung | Viele | Viele | ✔️ | ❌ | — | Windows, macOS | 4,6/5 (94 auf G2) | Ab 99 $/Mo. |

| Listly | Chrome-Erweiterung | Viele | Einige, für bestimmte Interaktionen | ✔️ | ❌ | — | Chrome | 4,7/5 (625 im Chrome Store) | Ab 30 $/Mo. |

| Apify | Cloud-Anwendung | Hängt vom gewählten Akteur ab | Viele | ✔️ | ❌ | — | Alle Browser | 4,8/5 (192 auf Capterra) | Ab 49 $/Mo. |

| Web Automation | Cloud-Anwendung | Viele | Viele | ✔️ | ❌ | — | Alle Browser | 4,8/5 (24 auf Capterra) | Ab 74 $/Mo. |

| Web-Scraper | Chrome- und Firefox-Erweiterungen | Viele | ❌ | ✔️ | ❌ | — | Chrome, Firefox | 4,0/5 (882 im Chrome Store) | Ab 50 $/Mo. |

| Magical | Chrome-Erweiterung | Wenige | ❌ | ✔️ | ❌ | — | Chrome | 4,5/5 (3,6k im Chrome Store) | Ab 6,50 $/Mo. |

| ParseHub | Desktop-Anwendung | Viele | ❌ | ✔️ | ❌ | — | Windows, macOS, Linux | 4,5/5 (15 auf Capterra) | Ab 189 $/Mo. |

| No-Code-Scraper | Cloud-Anwendung | Wenige | Einige | ✔️ | ❌ | — | Alle Browser | — | Ab 16.99 $/Mo. |

| Import.io | Webanwendung | Viele | ❌ | ✔️ | ❌ | — | Alle Browser | 3,6/5 (16 auf Capterra) | Ab 399 $/Mo. |

Fazit

In diesem Leitfaden haben Sie einige der besten No-Code-Web-Scraper-Tools auf dem Markt analysiert. Diese Lösungen befähigen Sie, über Desktop-Anwendungen, Cloud-Dienste oder Browser-Erweiterungen Online-Daten von Websites, ganz ohne technische Kenntnisse, zu erfassen.

Der No-Code-Scraper von Bright Data hat sich als die erste Wahl in der Branche erwiesen. Diese ausgereifte Lösung umfasst zahlreiche Vorlagen, mit denen Sie ohne Programmierkenntnisse mühelos Daten abrufen können.

Dank der robusten Infrastruktur, der zuverlässigen Leistung sowie dem Zugang zu einem riesigen Netzwerk von über 150 million+ Proxy-IPs gewährleistet der No-Code-Scraper eine hochwertige und rechtskonforme Datenerfassung bei minimalem Risiko, blockiert zu werden. Datenextraktion war noch nie so einfach!

Wenn Web-Scraping nicht gerade Ihr Thema ist – auch nicht mit No-Code-Tools -, Sie aber dennoch an Online-Daten interessiert sind, sollten Sie unseren Marktplatz für Datensätze erkunden.

Melden Sie sich jetzt an, um herauszufinden, welche der von Bright Data angebotenen Lösungen Ihren Anforderungen am besten entspricht und starten Sie Ihre kostenlose Testversion.