In diesem Artikel werden wir folgende Themen behandeln:

- Was ist Datenextraktion?

- Arten der Datenextraktion und Quellen

- Wie man Daten extrahiert

- Wie Datenextraktion Ihrem Unternehmen helfen kann

- Die besten Tools zur Datenextraktion

Was ist Datenextraktion?

Datenextraktion ist der Prozess der Gewinnung von Zieldaten aus einem Informationspool, beispielsweise aus Open-Source-Daten, die im Internet verfügbar sind. Dies ist der erste Schritt in einem Prozess, der mit dem Akronym „ETL” bezeichnet wird:

- Extrahieren

- Transform

- Laden

Sobald die Zielinformationen, wie z. B. Wettbewerbs- und Marketingdaten, gesammelt sind, können sie analysiert und als Business Intelligence (BI) im Entscheidungsprozess verwendet werden. Dies kann von einem Stakeholder durchgeführt werden, z. B. einem Teamleiter, der eine Änderung der Marketingkampagnenbotschaft beschließt, oder einem Algorithmus, der die Preise auf der Grundlage von Echtzeitänderungen bei Wettbewerbern aktualisiert.

Arten der Datenextraktion und Quellen

Daten können aus einer Vielzahl von Quellen stammen, die fast so zahlreich sind wie die verschiedenen Methoden, mit denen die gewünschten Informationen tatsächlich gewonnen werden.

Arten von Datenquellen

Daten können aus internen Aktivitäten wie Statistiken zur Kundenbindung und -abwanderung, aus staatlichen Datenbanken und Archiven sowie aus dem Internet stammen.

Digitale Datenquellen

Daten, die aus dem Internet gesammelt werden, lassen sich in personenbezogene Daten (PII) und passwortgeschützte Informationen unterteilen – beide sollten besser nicht gesammelt werden, da dies gemäß internationalen Datenschutzbestimmungen wie der Datenschutz-Grundverordnung (DSGVO) in Europa und dem California Consumer Privacy Act (CCPA) illegal ist. Beide sind zu Industriestandards geworden, und es ist sowohl aus rechtlicher als auch aus Verbrauchersicht schlecht für Unternehmen, sich damit zu befassen.

Zu den Open-Source-Plattformen, auf denen Daten gesammelt und für geschäftliche Zwecke genutzt werden können, gehören:

- Soziale Medien

- Suchmaschinen

- Websites von Wettbewerbern

- Diskussionsforen

- Websites von Behörden

- Historische Archive

- E-Commerce-Marktplätze

Physische Datenquellen

Die physische Welt generiert jeden Tag jede Sekunde Milliarden von Datenpunkten, darunter:

- Krankenakten

- Versicherungsanträge und Beschwerden

- Hypotheken-/Kreditanträge

- Transaktionsdaten von Verkaufsstellen (PoS)

- Geolokalisierungsdaten, die von Autos auf den Straßen oder Verbrauchern in Geschäften generiert werden

- Meteorologische Daten zu Wetterbedingungen und Naturphänomenen

Arten der Datenextraktion

Es gibt viele verschiedene Arten vonDatensätzen. Hier sind einige der gängigsten:

Erstens: Vollständige Datensätze

Diese bestehen in der Regel aus allen Datenpunkten einer bestimmten Zielwebsite. Zum Beispiel alle Anbieter, Produkte und Kundenbewertungen eines bestimmten E-Commerce-Marktplatzes.

Zweitens: Differentialdatensätze

Dies sind Datensätze, die auf der Grundlage von Werten, die sich seit der ersten Erfassung geändert haben oder aktualisiert wurden, regelmäßig aktualisiert werden. Dazu können Preise, die Anzahl der Follower (in sozialen Medien)/Mitarbeiter, das gesammelte Startkapital usw. gehören.

Drittens: Intelligente Teilmengen

Hierzu gehört die Verwendung von Filtern, um Zugang zu sehr spezifischen Informationen zu erhalten, die bei der Beantwortung von Geschäftsfragen oder bei Geschäftsentscheidungen hilfreich sein können. Zum Beispiel:„Was macht Unternehmen A falsch?“ und„Was können wir als Risikokapitalgesellschaft anders machen, um einen Mehrwert zu schaffen?“ Ein relevanter Datenpunkt könnte hier die negative Stimmung in den sozialen Medien unter Millennials in Bezug auf Produkte des Unternehmens sein, die die Umwelt nicht berücksichtigen.

Viertens: Angereicherte Datensätze

Diese Datensätze haben einen höheren Wert als andere, da sie Informationen aus mehreren Quellen im Internet zusammenführen und den Beteiligten einen umfassenderen Überblick über das jeweilige Thema ermöglichen. Beispielsweise durch den Abgleich von Bewertungen/Verbraucherstimmungen aus fünf verschiedenen Websites/Diskussionsforen.

Wie man Daten extrahiert

Zunächst einmal ist es wichtig zu verstehen, dass es zwei Hauptkategorien von Daten gibt:

Unstrukturierte Daten: Dies sind Daten in ihrer grundlegendsten/rohesten Form. Oft enthalten sie doppelte Einträge oder beschädigte Dateien und liegen in verschiedenen Formaten vor. Für Systeme und Algorithmen ist es sehr schwierig, Daten in dieser Form zu verarbeiten, zu indizieren und zu verwenden.

Strukturierte Daten: Dies sind Daten in ihrer „reinsten” und „verfeinertesten” Form. Duplikate und beschädigte Dateien wurden entfernt, und alle Datensätze wurden in ein einheitliches Format konvertiert. Für Algorithmen und Systeme ist es sehr einfach, diese Art von Daten zu scannen, zu indizieren, zu analysieren und wertvolle Ergebnisse zu erzielen.

So extrahieren Sie strukturierte/unstrukturierte Daten

Es gibt viele Möglichkeiten, strukturierte/unstrukturierte Daten zu extrahieren, je nach Ihren Fähigkeiten und Ressourcen. Wenn Sie beispielsweise über Programmierkenntnisse verfügen, können Sie Python verwenden, um einen benutzerdefinierten Collector zu erstellen. Alternativ können Sie Structured Query Language (SQL) verwenden, um Daten in einer relationalen Datenbank zu organisieren und abzufragen.

Für Geschäftsleute ohne Programmierkenntnisse ist es jedoch wahrscheinlich am besten, sich für eine vollautomatische Web-Scraping-Lösung wie die Web Scraper API zu entscheiden. Dabei handelt es sich um ein Tool, das die unstrukturierten Zieldaten automatisch bereinigt, abgleicht, synthetisiert, verarbeitet und strukturiert, bevor es sie an Ihre Teams/Systeme weiterleitet. Diese Daten sind bereits in dem von Ihnen gewünschten Format (JSON, CSV, HTML oder Microsoft Excel) strukturiert und können analysiert werden.

Der Prozess der Extraktion strukturierter/unstrukturierter Daten

Personen mit „programmiererischen Neigungen” können sich gerne unseren Python-Leitfaden für Web-Scraping ansehen. Hier finden Sie eine allgemeine Übersicht über die Schritte, die zur Extraktion von Daten mit Python erforderlich sind:

- Schritt 1: Wählen Sie die URL, die Sie als Ziel festlegen möchten.

- Schritt 2: Identifizieren Sie die Daten, die Sie sammeln möchten

- Schritt 3: Schreiben Sie den Code

- Schritt 4: Führen Sie den Code aus, um die Daten zu extrahieren.

- Schritt 5: Speichern Sie die Daten im erforderlichen Format.

Bei einem automatisierten Tool wie der Web Scraper API läuft der Prozess wie folgt ab:

- Wählen Sie die Zielwebsite aus.

- Wählen Sie die gewünschte Erfassungshäufigkeit und das gewünschte Datenformat aus.

- Lassen Sie sich die Daten an den Ort Ihrer Wahl liefern (Webhook, E-Mail, Amazon S3, Google Cloud, Microsoft Azure, SFTP oder API).

Wie die Datenextraktion Ihrem Unternehmen helfen kann

Die Datenextraktion kann auf verschiedene Weise genutzt werden, um Ihnen zu helfen:

- Ihr Unternehmen auszubauen – Identifizieren Sie beispielsweise neue Nutzerbedürfnisse, indem Sie Suchtrends bei Google verfolgen und Ihre Angebote dann auf diese Bedürfnisse zuschneiden.

- Effektiver im Wettbewerb bestehen – Indem Sie sehen, wo Ihre Konkurrenten bei den Zielgruppen am meisten Anklang finden (z. B. in sozialen Medien) und welche Produkte die höchsten Konversionsraten haben, können Sie sich entsprechend ausrichten.

- Optimierung von Marketingkampagnen – Unternehmen können die Stimmung in den sozialen Medien auf ihrer Plattform nutzen und reaktionsschnelle Botschaften in ihre Kampagnen einbauen.

- Investment Intelligence – Investmenthäuser können Nachrichtenartikel, die öffentliche Stimmung und Open-Source-Finanzaktivitäten von Unternehmen verfolgen, um die Entwicklung bestimmter Wertpapiere an der Börse genauer vorherzusagen.

Die größten Herausforderungen für Unternehmen bei der Datenextraktion

Zu den größten Herausforderungen, denen Unternehmen bei der Datenextraktion gegenüberstehen, gehören:

- Mangelnde technische Kenntnisse in Bezug auf Programmierung und/oder Personalmangel in Bezug auf qualifizierte Mitarbeiter/Mitarbeiter für die Datenextraktion (DevOps/IT/Programmierer usw.).

- Unfähigkeit, die erforderliche Hard- und Software aufzubauen, zu kaufen und zu warten, um Echtzeit-Datenerfassungsvorgänge effektiv durchzuführen.

- Unfähigkeit, Daten nach einem Zeitplan zu sammeln, zu bereinigen, zu verarbeiten und zu analysieren, der tatsächlich dazu beiträgt, einen „momentanen Wert” zu schaffen, sodass Entscheidungsträger Kampagnen auf der Grundlage aktueller Aktivitäten von Wettbewerbern/Verbrauchern optimieren können.

Die besten Tools zur Datenextraktion

Es gibt viele Tools zur Datenextraktion. Einige sind besser als andere – relevante Faktoren, die es zu berücksichtigen gilt, sind unter anderem die Qualität der Daten, die Datenquellen, die IP-Adressen und die Peers. Sie müssen sehr sorgfältig auswählen, mit welchem Datenanbieter Sie zusammenarbeiten, um sicherzustellen, dass Sie qualitativ hochwertige, aktuelle Informationen erhalten, die legal beschafft wurden, damit der langfristige Wert Ihrer datengesteuerten Produkte und Dienstleistungen gewährleistet ist.

Die Produkte von Bright Data entsprechen den branchenführenden Standards für ethische Datenerfassung. Alle Peers in unserem Netzwerk haben die Möglichkeit, sich nach eigenem Ermessen anzumelden und abzumelden und werden für die Teilnahme ihrer Geräte an unseren Datenerfassungsnetzwerken vollständig entschädigt.

Wir verfügen über ein engagiertes Team, das die Einhaltung der Vorschriften in Echtzeit überwacht, einschließlich codebasierter Präventions- und technologischer Reaktionsmechanismen.

Und schließlich sind alle Datenerfassungsmaßnahmen zu 100 % konform mit internationalen Datenschutzgesetzen, einschließlich der Datenschutz-Grundverordnung (DSGVO) und dem California Consumer Privacy Act (CCPA).

Die beiden Tools, die bei branchenführenden Unternehmen am beliebtesten sind, sind:

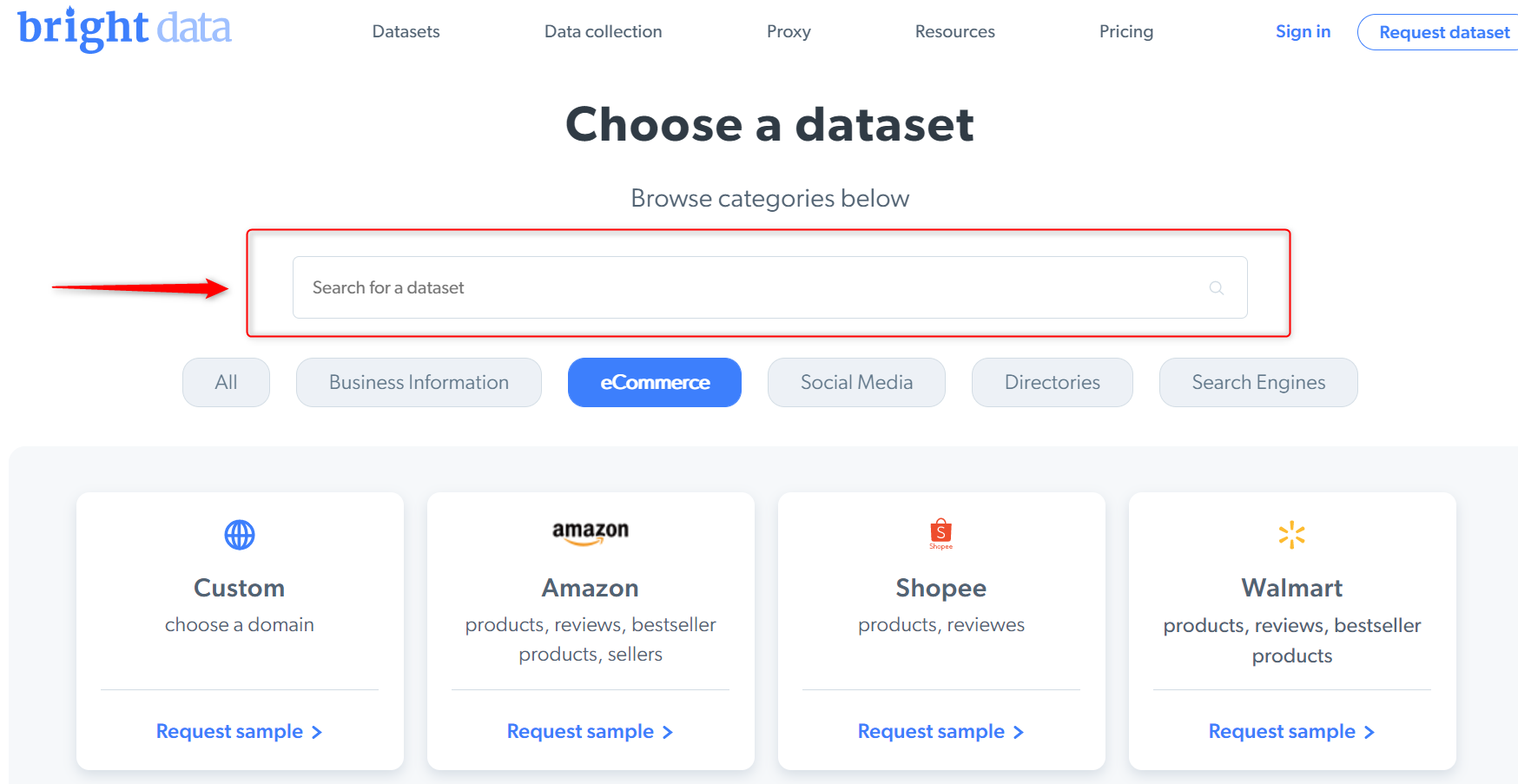

Datensätze

Dies sind vorab gesammelte, gebrauchsfertige Datensätze, die innerhalb weniger Minuten bestellt und bezogen werden können. Sie müssen lediglich den Datensatz auswählen, auf den Sie zugreifen möchten, und ihn direkt an Ihr Team/Ihre Algorithmen liefern lassen.

Web Scraper API

Die Web Scraper API ist ein vollautomatisches Tool, mit dem Geschäftsleute ohne technisches Know-how ohne Programmierkenntnisse Zugriff auf einen Echtzeit-Datenfluss erhalten. Es bereinigt und synthetisiert Zielinformationen und liefert strukturierte Datenpunkte direkt an bestimmte Teams und Algorithmen.

Fazit

Die Datenextraktion ist heutzutage eine der führenden Optionen für die Erfassung und Analyse großer Datenmengen und unterstützt Unternehmen und Einzelpersonen dabei, ihre Dienstleistungen und ihr Wissen über die Erwartungen von Kunden/Projekten zu verbessern. Obwohl die Datenextraktion ohne die Hilfe Dritter durchgeführt werden kann, kann die Auslagerung des Prozesses dazu beitragen, Geld und Zeit zu sparen, die dann für dringlichere geschäftliche Angelegenheiten verwendet werden können.