In diesem Leitfaden erfahren Sie Folgendes:

- Die Definition einer JavaScript-Bibliothek für Web-Scraping

- Elemente, die beim Vergleich dieser Scraping-Bibliotheken zu beachten sind

- Die besten JavaScript-Scraping-Bibliotheken

- Eine Vergleichstabelle mit einer Übersicht aller analysierten Tools

Dann legen wir mal los!

Was ist eine JavaScript-Bibliothek für Web-Scraping?

Bei einer JavaScript-Bibliothek für Web-Scraping handelt es sich um ein Tool, das zum Extrahieren von Daten aus Online-Websites dient. Dieses Tool kann HTTP-Anfragen senden, HTML-Websites analysieren und JavaScript-basierte Inhalte wiedergeben – oder all diese Vorgänge ausführen.

JavaScript-Scraping-Bibliotheken bieten Funktionen zur Kommunikation mit Webservern, zur Navigation in der DOM-Struktur bzw. zur Interaktion mit Websites. Zu den beliebten Arten von Bibliotheken gehören HTTP-Clients, All-in-One-Frameworks und Headless-Browser-Tools. Manche sind auf statische Seiten ausgerichtet, während andere dynamische Websites verarbeiten können.

Eine allgemeine Einführung finden Sie in unserem Leitfaden zu JavaScript-Web-Scraping.

Aspekte, die bei der Bewertung der besten JavaScript-Scraping-Bibliotheken zu beachten sind

Im Folgenden werden die wichtigsten Elemente aufgeführt, die beim Vergleich der besten JavaScript-Scraping-Bibliotheken zu beachten sind:

- Ziel: Hauptziel der JavaScript-Scraping-Bibliothek.

- Funktionen: Hauptfähigkeiten und -funktionen des Tools.

- Typ: Kategorie, zu der die Bibliothek gehört ( z. B. Browser-Automatisierung, HTTP-Client, usw.).

- GitHub-Sterne: Anzahl der für das Projekt vergebenen Sterne auf GitHub.

- Wöchentliche Downloads: Anzahl der wöchentlichen Downloads des Projekts auf npm.

- Zeitplan der Veröffentlichung: Häufigkeit von Aktualisierungen oder Veröffentlichungen der Bibliothek.

- Vorteile: Hauptvorteile der Nutzung der JavaScript-Bibliothek für Web-Scraping.

- Nachteile: Mögliche Nachteile oder Einschränkungen der Bibliothek.

Die 6 besten JavaScript-Bibliotheken für Web-Scraping

Nun wird es Zeit, sich mit den besten Open-Source-JavaScript-Scraping-Bibliotheken aus dem npm-Ökosystem zu befassen

Eine vollständige Liste finden Sie in unserem GitHub-Repository für JavaScript-Scraping-Bibliotheken.

1. Playwright

Playwright gilt derzeit als eine der branchenweit besten Headless-Browser-Bibliotheken. Es handelt sich um eine leistungsstarke JavaScript-Bibliothek für Web-Scraping, die automatisierte Tests mit diversen fortschrittlichen Funktionen ermöglicht. Sie unterstützt zudem das Scraping von dynamischen Websites.

Playwright bietet alles, was Sie für eine Echtzeit-Interaktion mit Websites benötigen, einschließlich der Ausführung von benutzerdefiniertem JavaScript-Code. Sie unterstützt mehrere Browser, darunter Chrome, Firefox und WebKit – welche von Puppeteer nicht unterstützt werden.

Darüber hinaus bietet Playwright fortschrittliche Funktionen wie Screen-Capturing und automatische Wartezeiten beim Laden von Seitenelementen. Dadurch wird diese Bibliothek zu einem umfassenden Instrument für das Web-Scraping in JavaScript.

Eine vollständige Anleitung dazu finden Sie in unserem Artikel über Web-Scraping mit Playwright.

🎯 Ziel: Bereitstellung einer hochwertigen API für die End-to-End-Automatisierung mehrerer Browser bei modernen Web-Apps

🛠️ Funktionen:

- Browserübergreifender Support (Chromium, WebKit, Firefox)

- Plattformübergreifendes Testen (Windows, Linux, macOS, Headless oder Headed)

- Native mobile Web-Emulation (Google Chrome für Android, Mobile Safari)

- Automatische Wartezeit bis zur Aktivierung von Elementen, um fehlerhafte Tests zu vermeiden

- Stealth-Plugin-Unterstützung über Playwright Extra

- Web-First-Assertions mit automatischer Wiederholung, bis die Voraussetzungen erfüllt sind

- Unterstützt mehrere Tabs, Ursprünge, Benutzer und Kontexte in einem Test

- Vertrauenswürdige Ereignisse, die echte Browsereingaben nachbilden

- Fähigkeit, Frames zu testen und Shadow DOM zu durchdringen

- Vollständige Isolierung von Tests mit Browser-Kontexten

- Codegenerierung durch Aufzeichnung von Aktionen und Unterstützung verschiedener Sprachen

- Playwright Inspector zum schrittweisen Durchlaufen von Tests, Generierung von Selektoren und Ausführungsprotokollen

- Trace Viewer zur Ermittlung von Testfehlern, einschließlich DOM-Snapshots und Screencasts

⚙️ Typ: Browser-Automatisierungsbibliothek

⭐ GitHub-Sterne: ~68,3k

📥 Wöchentliche Downloads: ~8,7M

🗓️ Zeitplan der Veröffentlichung: Etwa einmal im Monat

👍 Vorteile:

- Unterstützt mehrerer Browser

- Unterstützt eine Vielzahl leistungsstarker Funktionen, wie etwa die automatische Generierung von Selektoren

- Fortgeschrittene Automatisierungs-API

👎 Nachteile:

- Festplatten- und speicherintensive Bibliothek

- Steile Lernkurve zur Beherrschung sämtlicher Funktionen

- Erfordert die Installation eines Browsers

2. Cheerio

Cheerio ist eine schnelle, flexible und kompakte JavaScript-Bibliothek zum Parsen und Manipulieren von HTML und XML. Sie wird häufig für Web-Scraping eingesetzt und beruht auf einer intuitiven jQuery-ähnlichen API. Diese stellt Methoden zur Verfügung, mit denen Sie das DOM (Document Object Model) durchqueren und manipulieren können.

Anders ausgedrückt, Cheerio ermöglicht Ihnen die effiziente Abfrage von HTML-Elementen, deren Auswahl und die einfache Extraktion von Text, Attributen und vielem mehr. Kein Wunder, dass Cheerio auch auf der Liste der besten HTML-Parser für Web-Scraping erscheint.

Beachten Sie jedoch, dass Cheerio keinen integrierten HTTP-Client enthält. Sie müssen sie also mit Bibliotheken wie Axios oder node-curl-impersonate für den Abruf von HTML-Seiten integrieren. Als statischer HTML-Parser kann er außerdem kein JavaScript rendern.

🎯 Ziel: Bereitstellung einer jQuery-ähnlichen Syntax für die DOM-Exploration von HTML- und XML-Dokumenten

🛠️ Funktionen:

- Kann sowohl mit HTML- als auch mit XML-Dokumenten operieren.

- Implementierung einer Teilmenge der jQuery-API für die serverseitige Verwendung beim Web-Scraping

- Unterstützt das Durchlaufen, Manipulieren und Ändern von DOM-Strukturen

- Geringes Gewicht und minimale Abhängigkeiten für schnelle Leistung

- Kompatibel mit Node.js und Browserumgebungen

⚙️ Typ: HTML-Parser

⭐ GitHub-Sterne: ~28,9k

📥 Wöchentliche Downloads: ~6,9M

🗓️ Zeitplan für die Veröffentlichung: Weniger als einmal im Jahr

👍 Vorteile:

- Einfache jQuery-ähnliche Syntax mit der die meisten JavaScript-Entwickler bereits vertraut sind

- Unterstützt HTML- und XML-Parsing

- Schnelle HTML-Parsing-Funktionen

👎 Nachteile:

- Langsamer Entwicklungsprozess

- jQuery-Syntax könnte veraltet wirken

- Einige wesentliche Neuerungen in der jüngsten Version

3. Axios

Axios ist die beliebteste und am häufigsten verwendete JavaScript-Bibliothek für HTTP-Anfragen. Deshalb wird sie häufig bei Web-Scraping-Aufgaben eingesetzt, um HTML-Daten von Webseiten abzurufen.

Sie unterstützt Promises und eignet sich daher ideal für die asynchrone Programmierung in Node.js. Axios ist leicht, einfach zu benutzen und kann GET-, POST- und andere HTTP-Anfragen senden. Sie ermöglicht die Anpassung von Anfragen und deren Zufallsgenerierung, um Blockaden zu vermeiden.

Axios bietet jedoch kein integriertes HTML-Parsing und keine Browser-Automatisierung, wie dies bei anderen Bibliotheken der Fall ist. Folglich muss sie mit Tools wie Cheerio kombiniert werden.

🎯 Ziel: Erstellung automatisierter HTTP-Anfragen

🛠️ Funktionen:

- Erstellt Anfragen für alle HTTP-Methoden in Node.js und im Browser

- Unterstützt die

Promise-API - Unterstützt das Abfangen von Anfragen und Antworten

- Fähigkeit, Anfrage- und Antwortdaten umzuwandeln

- Unterstützt die Stornierung von Anfragen

- Unterstützt benutzerdefinierte Timeouts

- Unterstützt die Proxy-Integration

- Unterstützt benutzerdefinierte Header, Cookies und vieles mehr

- Unterstützung bei Abfrageparametern

- Automatische Serialisierung von Anfragekörpern in JSON, multipart/

FormDataund URL-kodierte Form - Automatische Verarbeitung von JSON-Daten aus Antworten

- Unterstützung von Bandbreitenbegrenzungen

⚙️ Typ: HTTP-Client

⭐ GitHub-Sterne: ~106k

📥 Wöchentliche Downloads: ~50M

🗓️ Zeitplan der Veröffentlichung: Etwa einmal im Monat

👍 Vorteile:

- Der am häufigsten verwendete HTTP-Client in JavaScript

- Tonnenweise Online-Ressourcen und Tutorials

- Unterstützung für Abfangmechanismen und erweiterte Funktionen

👎 Nachteile:

- Keine Unterstützung für TLS-Fingerprint-Spoofing

- Erfordert einen HTML-Parser für Scraping

- Keine leichtgewichtige Abhängigkeit

4. Puppeteer

Puppeteer ist eine JavaScript-Bibliothek für Tests, die auch für Web-Scraping eingesetzt werden kann. Dies ist dank seiner high-level-API zur Interaktion mit Browsern möglich. Damit lassen sich Browsing-Aufgaben automatisieren und Inhalte auf dynamischen Seiten, die das Rendern oder Ausführen von JavaScript erfordern, scrapen.

Puppeteer kann Schaltflächen anklicken, Formulare ausfüllen, Seiten durchsuchen und vieles mehr. Puppeteer bietet außerdem integrierte Funktionalität für Proxy-Verarbeitung, Headless-Betrieb und das Abfangen von Anfragen.

Sehen Sie sich unser Tutorial zu Web-Scraping mit Puppeteer an.

🎯 Ziel: Bereitstellung einer High-Level-API zur Automatisierung und Verwaltung von Headless Chrome- und Firefox-Browsern für Web-Scraping und Tests

🛠️ Funktionen:

- Funktioniert mit Chromium-basierten Browsern, Chrome und Firefox

- Bietet eine High-Level-API zur Simulation der Benutzerinteraktion auf einer Website

- Erstellt Screenshots und generiert PDFs von Websites

- Unterstützt die Übermittlung von Formularen und andere Automatisierungen

- Anti-Bot-Funktionen mit Puppeteer Extra

- Emuliert Mobilgeräte und benutzerdefinierte User-Agents

- Unterstützt das Abfangen von Netzwerken und die Änderung von Anfragen/Antworten

- Äußerst anpassbar

- Unterstützt benutzerdefinierte User-Agents

- Unterstützt sowohl den Headless- als auch den Headed-Modus

⚙️ Typ: Browser-Automatisierungsbibliothek

⭐ GitHub-Sterne: ~89,3k

📥 Wöchentliche Downloads: ~3,1M

🗓️ Zeitplan der Veröffentlichung: Etwa einmal im Monat

👍 Vorteile:

- Unterstützt Chrome und Firefox für die Verarbeitung von Seiten mit dynamischen Inhalten

- CLI-Befehl zum automatischen Herunterladen von Browsern

- Unterstützt sowohl WebDriver BiDi als auch das Chrome DevTools Protokoll

👎 Nachteile:

- Keine Unterstützung für Safari

- Schwer auf Docker zu implementieren

- Begrenzte Automatisierungs-API

5. Crawlee

Crawlee ist eine JavaScript-Bibliothek zum Web-Scraping für fortgeschrittene Crawling-Anforderungen. Sie verfügt über eine High-Level-API für Web-Scraping, welche auf Puppeteer, Playwright oder Cheerio aufsetzt. Sie dient der Vereinfachung folgender Prozesse:

- Crawling von Websites

- Extrahieren von Daten aus Websites

- Umgang mit JavaScript-Rendering und Simulation der Benutzerinteraktion

Crawlee bewältigt allgemeine Herausforderungen wie Paginierung, Ratenbegrenzung und Proxy-Rotation. Sie unterstützt sowohl Headless-Browser als auch normales HTTP-Parsing. Die Bibliothek lässt sich zudem problemlos in Cloud-Plattformen integrieren und bietet eingebaute Lösungen zur Verarbeitung von Wiederholungen und zum Fehlermanagement.

Weitere Einzelheiten finden Sie in unserer Schritt-für-Schritt-Anleitung zum Web-Scraping mit Crawlee.

🎯 Ziel: Deckung Ihres gesamten Crawling- und Scraping-Bedarfs, um Sie bei der Erstellung zuverlässiger Scraper zu unterstützen

🛠️ Funktionen:

- Einheitliche Schnittstelle für HTTP-Anfragen und Headless Browser Crawling

- Persistente URL-Warteschlange zur Unterstützung von Breadth-First und Deep-First-Crawling

- Pluggable Storage für tabellarische Daten und Dateispeicher

- Automatische Skalierung, optimiert für die verfügbaren Systemressourcen

- Integrierte Proxy-Rotation und Sitzungsverwaltung

- Anpassbare Lebenszyklen mit Hooks für verstärkte Kontrolle

- CLI-Tools zur schnellen Einrichtung neuer Projekte

- Konfigurierbares Routing, Fehlerbehebung und Wiederholungen

- Einsatzbereite Dockerfiles für nahtlose Bereitstellung

- TypeScript-Support mit Generics für Typsicherheit

- Unterstützt die Integration von JavaScript-Rendering

⚙️ Typ: Scraping- und Crawling-Framework

⭐ GitHub-Sterne: ~16,5k

📥 Wöchentliche Downloads: ~15k

🗓️ Zeitplan der Veröffentlichung: Einmal im Monat

👍 Vorteile:

- Eine der wenigen All-in-One-Bibliotheken für JavaScript-Scraping

- Proxy, JavaScript-Rendering und native CLI-Integration

- Einfach zu implementieren

👎 Nachteile:

- Steile Lernkurve für Einsteiger

- Aufgrund ihrer vorgefertigten Beschaffenheit lässt sie sich möglicherweise nur schwer an sehr spezifische Szenarien anpassen

- Eingeschränkter Community-Support

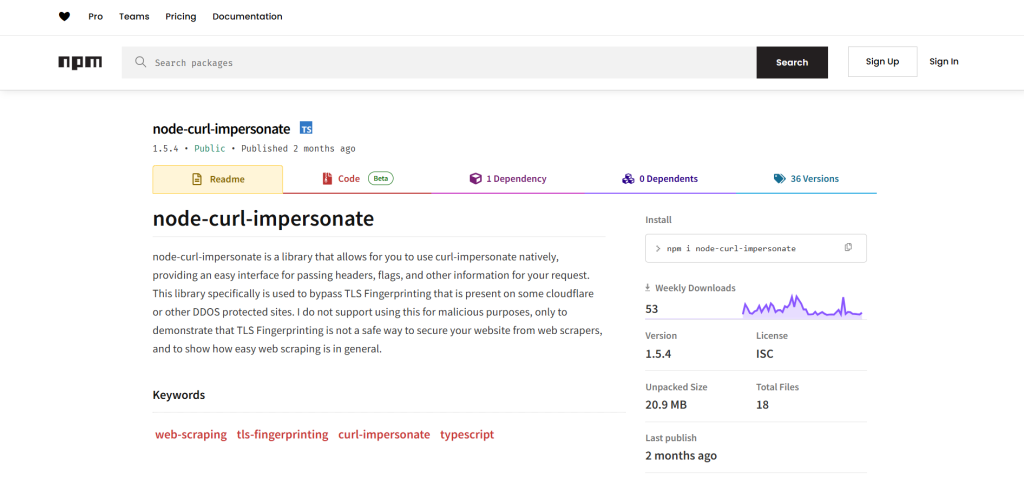

6. node-curl-impersonate

node-curl-impersonate ist eine auf cURL-Impersonate basierende Node.js HTTP-Client-Bibliothek. Sollten Sie mit dieser Technologie nicht vertraut sein, handelt es sich bei cURL-Impersonate um eine spezielle Version von cURL, die für Web Scraping-Aufgaben konzipiert wurde. Sie stützt sich auf die von Browsern und anderen Konfigurationen verwendeten TLS-Bibliotheken, um den Großteil der Anti-Bot-Systeme zu umgehen.

node-curl-impersonate bietet eine Node.js-API, die cURL-Impersonate umfasst. Diese API ermöglicht das Senden von HTTP-Anfragen, während sie gewöhnliche Browser, wie z.B. Chrome und Firefox, nachahmt. Dadurch können Sie CAPTCHA-Abfragen vermeiden, da Sie einen vertrauenswürdigen TLS-Fingerprint erhalten.

🎯 Ziel: Durchführung automatisierter HTTP-Anfragen, als ob sie über einen Browser gestellt wurden, jedoch ohne Verwendung eines Headless-Browsers

🛠️ Funktionen:

- HTTP-Client mit Browser-Identität

- Unterstützt Chome- und Firefox-Identitäten

- Anpassbarer User-Agent und Header

- Eingebauter TLS-Fingerprinting-Abgleich

⚙️ Typ: HTTP-Client

⭐ GitHub-Sterne: –

📥 Wöchentliche Downloads: ~50

🗓️ Zeitplan für die Veröffentlichung: Etwa alle paar Monate

👍 Vorteile:

- HTTP-Client mit Browser-Identität

- Geringer Ressourcenbedarf mit Browser-Funktionen

- Unterstützt mehrere Browser-Identitäten

👎 Nachteile:

- Begrenzte Online-Tutorials und Ressourcen

- Unregelmäßige Aktualisierungen

- Abhängig von älteren Browserversionen

Beste JavaScript-Web-Scraping-Bibliothek

Schauen Sie sich für einen schnellen Vergleich die Übersichtstabelle der JavaScript-Web-Scraping-Bibliotheken unten an:

| Bibliothek | Typ | HTTP-Abfrage | HTML-Parsing | JavaScript-Rendering | Anti-Detektion | Lernkurve | GitHub-Sterne | Downloads |

|---|---|---|---|---|---|---|---|---|

| Playwright | Browser-Automatisierung | ✔️ | ✔️ | ✔️ | Hoch mit dem Stealth-Plugin | Steil | ~68,3k | ~8,7M |

| Cheerio | HTML-Parser | ❌ | ✔️ | ❌ | — | Sanft | ~28,9k | ~6,9M |

| Axios | HTTP-Client | ✔️ | ❌ | ❌ | Begrenzt | Sanft | ~106k | ~50M |

| Puppeteer | Browser-Automatisierung | ✔️ | ✔️ | ✔️ | Hoch mit dem Stealth-Plugin | Steil | ~89,3k | ~3,1M |

| Crawlee | Scraping-Framework | ✔️ | ✔️ | ✔️ | Konfigurierbar | Steil | ~16,5k | ~15k |

| node-curl-impersonate | HTTP-Client | ✔️ | ❌ | ❌ | Hoch | Medium | — | ~50 |

Fazit

In diesem Blogbeitrag haben Sie die besten JavaScript-Scraping-Bibliotheken kennengelernt und erfahren, weshalb sie es auf diese Liste geschafft haben. Dabei haben wir einige der am häufigsten verwendeten HTTP-Clients, Browser-Automatisierungstools und Crawling-Bibliotheken im npm-Ökosystem verglichen.

Diese Bibliotheken helfen beim Web-Scraping in Node.js. Es gibt jedoch viele Hürden, die sie nicht überwinden können, wie z. B.:

- IP-Blöcke

- Erweiterte Anti-Bot-Lösungen

- CAPTCHAs

- Einfache Bereitstellung in der Cloud und Serverwartung

Dies sind nur einige wenige Beispiele für Herausforderungen, denen sich Scraping-Entwickler stellen müssen. Mit Bright-Data-Lösungen können Sie den ganzen Aufwand vergessen:

- Proxy-Dienste: 4 Arten von Proxys zur Umgehung von Standortbeschränkungen, einschließlich über 72 Millionen Privat-IPs

- Web-Scraping-APIs: Spezielle Endpunkte zur Extraktion frischer, strukturierter Webdaten von über 100 beliebten Domains.

- Web-Unlocker: API, die für Sie die Verwaltung der laufenden Freischaltungen von Websites übernimmt und eine URL extrahiert

- SERP-API: API zur Verwaltung aller Freischaltungen für SERP und Extraktion einer Seite

- Scraping-Browser: Puppeteer-, Selenium- und Playwright-kompatibler Browser mit integrierten Freischaltfunktionen

- Scraping-Funktionen: IDE zur Erstellung von JavaScript-Scrapern auf der Bright-Data-Infrastruktur, mit integrierter Freischaltung und Browsern

Alle oben genannten Scraping-Tools, -Lösungen und -Services sind mit JavaScript und jeder anderen Programmiersprache kompatibel.

Erstellen Sie ein Bright-Data-Konto und testen Sie diese Scraping-Services mit einer kostenlosen Testversion!

Keine Kreditkarte erforderlich