Versuchen Sie, mit einem LLM über etwas zu sprechen, das ihm noch nie begegnet ist. Kann er es herausfinden? Dies wird oft als der wahre Intelligenztest angesehen. Wenn ein Modell Schlussfolgerungen und Verallgemeinerungen verwendet, um ohne Trainingsdaten zu lernen, wird dies als Zero-Shot-Lernen bezeichnet.

Traditionell benötigen KI-Modelle riesige Datensätze mit beschrifteten Beispielen. Beim Zero-Shot-Lernen wird erwartet, dass ein Modell im laufenden Betrieb ohne Trainingsdaten lernt. Zero-Shot-Lernen ist kein Ersatz für das Standardtraining. Zero-Shot wird verwendet, um bereits trainierte Modelle auf die nächste Stufe zu heben. Man kann eine KI in etwas hineinwerfen, das sie noch nie gesehen hat, und sie wird trotzdem gute Leistungen erbringen.

Folgen Sie uns und erfahren Sie alles über das Zero-Shot-Lernen.

Wo wird Zero-Shot Learning eingesetzt?

Haben Sie schon einmal jemanden gebraucht, der Ihre Arbeit aus einer anderen Perspektive betrachtet? Genau hier kommt Zero-Shot ins Spiel. Beim Zero-Shot-Lernen nimmt ein KI-Modell Eingaben entgegen, verarbeitet sie und gibt Ihnen eine Meinung ab, ohne dass Sie dafür trainiert wurden. Dies führt zu vielversprechenden Ergebnissen in allen Arten von Branchen. Wenn Sie KI bitten, Unbekanntes zu verarbeiten, und Sie erhalten Ergebnisse – das ist Zero-Shot-Learning in Aktion.

- Gesundheitswesen: Bei der Diagnose von seltenen oder unbekannten Krankheiten verwenden Modelle Zero-Shot, um seltene und noch nie dagewesene medizinische Krankheiten zu diagnostizieren. In diesen Situationen sind die Daten knapp oder gar nicht vorhanden.

- Pharmazeutika: Modelle können bisher ungesehene Daten analysieren, um die Wirksamkeit von Wirkstoffen vorherzusagen, die es noch gar nicht gibt.

- Verarbeitung natürlicher Sprache: Große Sprachmodelle (Large Language Models, LLMs) sprechen den ganzen Tag, jeden Tag, nonstop mit Menschen. Wenn ein neuer Slang auftaucht oder jemand über seine individuellen Probleme spricht, nutzen Modelle Zero-Shot, um Schlussfolgerungen und Verallgemeinerungen zu ziehen, wie es Menschen tun würden.

- Computer Vision und Robotik: Es ist praktisch unmöglich, ein Modell auf jedes Bild zu trainieren, dem es in der realen Welt begegnen könnte. Modelle erkennen neue Bilder und finden heraus, was sie mit ihnen anfangen sollen. Ein selbstfahrendes Auto hält an einer Kreuzung, die es noch nie gesehen hat. Ein Roomba sieht Ihre Möbel und weicht ihnen aus.

- Unterhaltung und Kreativwirtschaft: Mit Zero-Shot können Modelle einzigartige Spielfiguren erschaffen. DALL-E und ähnliche Modelle erzeugen einzigartige Kunstwerke, die noch nie jemand gesehen hat.

Zero-Shot-Learning wird bereits überall auf der Welt eingesetzt. Je mehr KI wir einsetzen, desto mehr wird Zero-Shot weiter wachsen.

Zero-Shot vs. andere Paradigmen

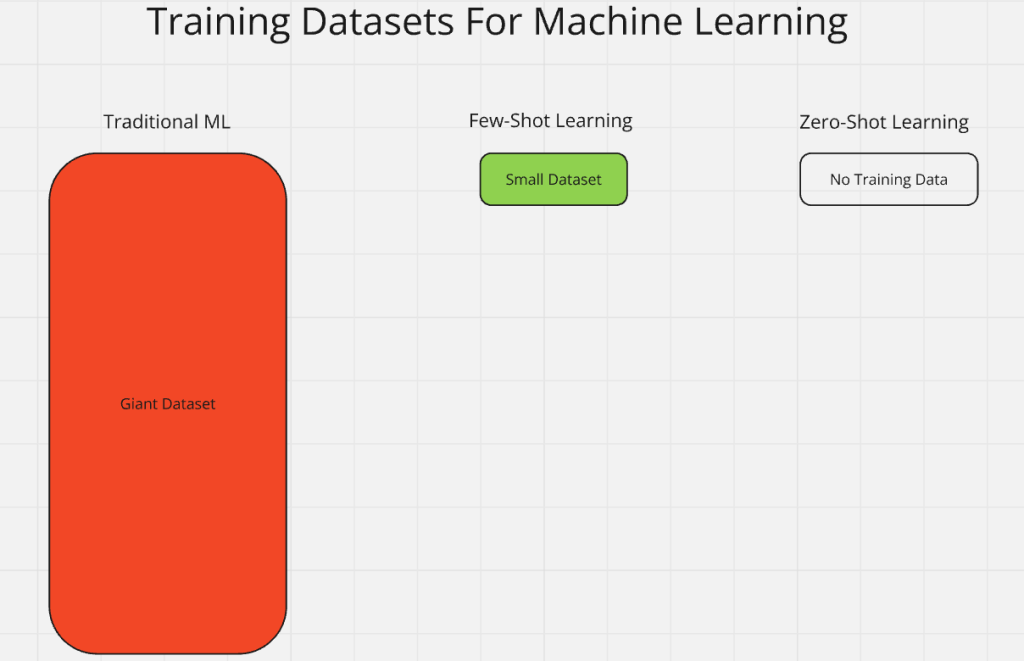

Haben Sie schon einmal in einem Job gearbeitet, in dem es kein richtiges Management und keine richtige Ausbildung gab? Wenn ja, dann haben Sie Zero-Shot-Learning eingesetzt. Zero-Shot-Lernen ist Teil eines größeren Paradigmas, das als “n-Shot”-Lernen bezeichnet wird. N steht für die Anzahl der markierten Beispiele. Zero-Shot-Lernen bedeutet, dass es kein vorheriges Training gibt. Beim traditionellen maschinellen Lernen werden riesige Datensätze mit markierten Eingaben verwendet.

- Ein-Schuss-Lernen: Ein Modell wird auf Daten mit nur einer markierten Probe pro Klasse trainiert.

- Few-shot Learning: Das Modell wird mit einer kleinen Anzahl von markierten Beispielen trainiert.

- Traditionelles maschinelles Lernen: Beim traditionellen Lernen wird ein Modell auf riesigen Datensätzen mit markierten Beispielen trainiert. Dies ist das Gegenteil von Zero-Shot.

- Zero-Shot Learning: Das Modell sieht Dinge, die es nie zuvor gesehen hat oder die ihm beigebracht wurden. Es wird einfach in den Mix geworfen und soll Dinge herausfinden und lernen.

Zero-Shot-Learning ist vergleichbar mit dem Lernen in der realen Welt. Ihr Chef wirft Sie ins Getümmel und erwartet einfach, dass Sie es herausfinden.

Konventionelles Zero-Shot Learning (ZSL)

Suchen Sie nach einer Quelle nutzloser Informationen, um eine einzige praktische Frage zu beantworten? Ein LLM kann dies für Sie tun. LLMs sind klassische Beispiele für konventionelle ZSL. Diese Modelle werden mit mehr Daten trainiert, als Sie und ich uns vorstellen können. Denken Sie an die gesamte Wikipedia, an alle sozialen Medien, die das Unternehmen für geeignet hält, an Tausende von Büchern – und vieles, vieles mehr.

Wenn man eine künstliche Intelligenz formell ausbildet, erhält sie eine Reihe von Kursen. Wenn wir eine KI mit Pferden trainieren wollen, können wir ihr Bilder und Bücher über Pferde geben. Wenn wir dies tun, erstellen wir eine Klasse: “Pferd”. Das Modell entwickelt dann interne Regeln und Verallgemeinerungen für den Umgang mit Informationen, die sich auf seine Pferdeklasse beziehen.

Sobald ein Modell ein angemessenes Vortraining erhalten hat, kann es neue Daten erhalten und seine eigenen Klassen erstellen. Wenn wir unserem auf Pferde trainierten Modell ein Bild eines Zebras geben, kann es daraus schließen, dass ein Pferd mit Streifen ein Zebra ist. Obwohl es nicht auf Zebras trainiert wurde, ist es intelligent genug, um eine neue interne Zebra-Klasse zu erstellen und Regeln für den Umgang mit Zebras aufzustellen.

Aufgrund der hohen Anforderungen an das Vortraining ist ZSL mit ziemlich hohen Kosten verbunden. Unser Modell mag Zebras verstehen, aber wir haben es auf die halbe Welt trainiert, um dorthin zu gelangen! Aufgrund des Vortrainings ist ZSL nicht sehr effizient. Wenn Sie ChatGPT das nächste Mal etwas Sinnloses fragen, denken Sie daran, was die Maschine durchmachen musste, nur um Ihre einfache Frage zu beantworten.

Verallgemeinertes Zero-Shot-Lernen (GZSL)

GZSL übernimmt die Konzepte von ZSL und vereinfacht sie, um effizienter zu sein. Mit GZSL nutzen wir das Chaos, um den Lernprozess zu vereinfachen. Beim verallgemeinerten Zero-Shot-Lernen werden mehrere Unbekannte in den Trainingsprozess gemischt. Das Modell verwendet dann Verallgemeinerungen, um aus diesen Unbekannten interne Klassen und Regeln zu erstellen.

Warum geben wir unserem Modell nicht ein einzelnes Bild mit Pferden und einem Zebra, anstatt es vorher mit Pferden zu trainieren? Wir können es auch mit ein wenig Text füttern: “Das Bild, das ich dir gebe, enthält mehrere Pferde und ein Zebra. Ein Zebra ist ein gestreiftes Pferd.”

Das Modell kann diese kurze Beschreibung und ein einziges Bild verwenden, um sowohl eine Pferdeklasse als auch eine Zebraklasse zu erstellen.

- Pferdeklasse: Das Modell erstellt eine Pferdeklasse und speichert die Daten der nicht gestreiften Pferde auf dem Bild.

- Zebra-Klasse: Es wird eine Zebraklasse erstellt, die nur unsere kurze Beschreibung und das gestreifte Pferd aus dem Bild verwendet.

Dadurch wird die Größe unserer Trainingsdaten drastisch reduziert. Wir haben unser Modell nun darauf trainiert, mehrere Pferde und ein Zebra aus einem einzigen Bild mit Text zu erkennen. Wenn unser durchschnittliches Bild etwa 4kb groß ist, würden wir beim Training mit vier Pferden einen Datensatz von mindestens 16kb erhalten. Wenn wir etwas Chaos hinzufügen und alle Tiere in ein Bild einbeziehen, beträgt unser Trainingsdatensatz nur 4kb. Mit GZSL liefern wir schlankere, qualitativ hochwertige Daten für einen schnelleren Trainingsprozess und ein kleineres Modell.

Wie Zero-Shot Learning funktioniert

Lassen Sie uns das Gehirn unseres hypothetischen LLM sezieren, um zu sehen, was wirklich vor sich geht. Wir wissen, dass ein Modell Eingabedaten entgegennimmt. Dann erstellt es selbständig neue Regeln und Klassen. Lassen Sie uns besser verstehen, wie es dies tut.

Etiketten

Die Vorschulung ist eine Art Schule. Das Modell lernt die Grundlagen der Informationsverarbeitung und des “Denkens”. Nach Abschluss des Pre-Trainings hat das Modell von uns alle Arten von beschrifteten Klassen und Regeln gelernt. In dieser Phase versorgen wir das Modell mit Klassen und Bezeichnungen. Wenn es seinen Abschluss gemacht hat, weiß es, wie es lernen kann. Wir müssen es nicht mehr mit Löffeln füttern, so wie wir es am Anfang getan haben.

Unser Modell wartet nicht darauf, dass wir Etiketten bereitstellen. Erinnern Sie sich an unser Beispiel mit dem Pferd und dem Zebra von vorhin? Das Modell erstellt die Klassen und beschriftet sie ohne unsere Hilfe. Das spart uns wertvolle Zeit beim Training und erlaubt dem Modell, ein gewisses Maß an Autonomie zu praktizieren.

Lernen übertragen

Modelle ziehen Schlüsse. Wenn unser mit dem Pferd trainiertes Modell das Zebra lernt, wird es viele (wenn nicht alle) der bestehenden Regeln aus der Pferdeklasse auf die neue Zebraklasse übertragen. Das Lernen wird von einem Teil des Modells auf den anderen übertragen.

Stellen Sie sich vor, Sie trainieren ein Modell, um Hoteldaten von Google zu scrapen (wie man das manuell macht, erfahren Sie hier). Dann bringen Sie ihm bei, Booking.com zu scrapen (wie das manuell geht, erfahren Sie hier). Wenn es Booking.com durchsucht, nutzt es sein Wissen über die Hotels von Google, um die neuen Hotels von Booking.com zu durchsuchen.

Begründung

Das Herzstück des Zero-Shot-Lernens ist die Fähigkeit zu denken. Wie haben Sie überlebt, als Sie ohne Ausbildung oder Erfahrung in diesen schrecklichen Job geworfen wurden? Wahrscheinlich haben Sie es mit logischem Denken und gesundem Menschenverstand herausgefunden. Stellen Sie sich vor, wir geben unserem KI-Kleinkind einen “See and Say”-Datensatz. Wir würden eine Klasse und Regeln für jede Klasse aufstellen. Denken Sie: “Die Kuh sagt muh!”. Wir würden eine Kuhklasse erstellen und die Regel aufstellen, dass sie “muh” sagt.

Sobald unsere KI erwachsen ist, brauchen wir das nicht mehr zu tun. Unser Modell sieht ein Bild von einem Huhn mit schlechten Beschriftungen wie “gackern” oder “Federn”. Anhand dieser einfachen Hinweise findet das vortrainierte Modell heraus, dass es sich um ein Huhn handelt. Dann erstellt es eine Klasse Huhn mit Regeln wie “gackern” und “Federn”. Bei der Argumentation nutzt unser Modell den gesunden Menschenverstand und den Straßenverstand, um reale Probleme zu lösen (ganz gleich, wie landwirtschaftlich sie auch sein mögen).

Vorgefertigte Foundation-Modelle

Unser Modell ist zu Beginn einem neugeborenen Baby sehr ähnlich. Es ist völlig hilflos und kann nichts für sich selbst tun. Mit Hilfe des Pre-Trainings wächst unser Modell heran und kann selbständig denken. Bevor es mit Zero-Shot lernen kann, muss das Modell “lernen, wie man lernt”.

Alle Menschen tun dies, wenn sie aufwachsen. Zuerst lernen wir, wie man sich ernährt. Dann lernen wir, feste Nahrung zu essen und uns aufzusetzen. Im Alter von etwa einem Jahr lernen wir dann laufen und sprechen. Anstatt zu lernen, wie man läuft, spricht und aufs Töpfchen geht, lernen KI-Modelle zunächst grundlegende Dinge wie Mathematik und Sprachverarbeitung. Dann lernen sie, wie man Daten aufnimmt.

Sobald ein Modell weiß, wie es Daten verarbeiten kann, füttern wir es mit allen Daten, die wir finden können. Dann füttern wir es mit mehr Daten! Schließlich lernt es, wie es auf seine eigenen internen Klassen zugreifen kann. Sobald das Modell Klassen lesen und schreiben kann, beginnt es, Verallgemeinerungen vorzunehmen, die sich im Laufe der Zeit zu Schlussfolgerungen weiterentwickeln. Mit einem effektiven Pre-Training können die Modelle dann Zero-Shot verwenden, um selbständig zu lernen.

Zero-Shot-Learning-Methoden

Von außen betrachtet sieht Zero-Shot-Learning wie Magie aus. Aber wie jeder Zaubertrick ist auch dies eine Illusion. KI-Modelle sind auf eine ganz bestimmte Art von Fähigkeiten angewiesen. Sie nehmen Rohdaten und wandeln sie in echte Antworten um, die wir lesen oder hören können. Schauen wir uns an, was passiert, bevor das Kaninchen aus dem Hut gezogen wird.

Attribute

Unser Modell entschlüsselt verschiedene Tiere anhand von Merkmalen oder Attributen. Attribute sind so einfach, wie sie klingen. Wenn unser Modell ein Bild mit einer Vielzahl von Tieren betrachtet, verwendet es deren Eigenschaften, um herauszufinden, was was ist.

- Pferd: Wiehern, 4 Beine, Hufe.

- Huhn: Gackern, 2 Beine, Flügel.

- Kuh: Muh, 4 Beine, Hufe.

Attribute ermöglichen es der Maschine, fundierte Vermutungen anzustellen – so wie es ein Mensch tun würde.

Einbettungen

Maschinen sehen Daten nicht so, wie Sie und ich sie sehen. Stattdessen verfügen sie über numerische Datenlisten, sogenannte Matrizen. Nehmen wir an, wir wollen unsere Pferde-, Hühner- und Kuhattribute als Zahlen wiedergeben.

| Tier | Ton | Beine | Eigenschaften |

|---|---|---|---|

| Pferd | Wiehern | 4 | Hufe |

| Huhn | Cluck | 2 | Flügel |

| Kuh | Muh | 4 | Hufe |

Jede Zeile dieser Tabelle kann als Liste dargestellt werden.

- Pferd:

[Wiehern, 4, Hufe] - Hühner:

[Gackern, 2, Flügel] - Kuh:

[Muhen, 4, Hufe]

Die obigen Listen sind jedoch noch nicht maschinenlesbar. Maschinen können Zahlen sehr gut verstehen. Für Geräusche kodieren wir 1, 2 und 3, um “Wiehern”, “Gackern” und “Muhen” darzustellen. Da wir uns nur um zwei Merkmale kümmern müssen (Hufe und Flügel), wird 1 für Hufe und 2 für Flügel stehen.

Unser Modell könnte diese Informationen folgendermaßen sehen.

- Pferd:

[1, 4, 1] - Huhn:

[2, 2, 2] - Kuh:

[3, 4, 1]

Indem wir unsere Daten in Zahlen einbetten, können KI-Modelle sie effizient verarbeiten, um Beziehungen und Regeln zu entdecken. Dies ist die Grundlage für ihre Verallgemeinerungs- und Schlussfolgerungsfähigkeiten. Erfahren Sie mehr über Einbettungen in ML.

Generativ

Modelle erfinden neue Klassen aus dem Nichts. Generative Methoden ermöglichen es dem Modell, eine Schlussfolgerung zu ziehen, indem es Beziehungen in den eingebetteten Attributen erkennt. Wenn unser Modell das Zebra ohne Training identifiziert, ist dies generativ. Das Modell hat gesehen, dass es sich um ein gestreiftes Pferd handelt. Es hat dann die Schlussfolgerung gezogen, dass ein gestreiftes Pferd ein Zebra ist.

Wenn Sie Hoteldaten auslesen, aber keine Bewertung haben, kann ein KI-Modell eine solche auf der Grundlage der bereitgestellten Informationen erstellen. KI-Modelle nutzen ihre Fantasie, um neue Daten zu generieren. Das Modell könnte entscheiden, dass ein Zimmer, das ein großes Bett und einen Whirlpool hat, 5 Sterne verdient. Das ist unglaublich leistungsfähig, kann aber auch zu Halluzinationen führen.

Bei der Verwendung generativer Methoden ist Vorsicht geboten. Es ist toll, wenn ein Modell Hotelbewertungen zuordnen kann. Wenn Sie Ihr Modell fragen: “Was ist das letzte, was Konfuzius 2026 geschrieben hat? Konfuzius ist schon seit Tausenden von Jahren tot, aber KI-Modelle werden Ihnen selten sagen: “Ich weiß es nicht”. Es besteht die Möglichkeit, dass Sie eine Antwort wie die folgende erhalten.

Die obige Ausgabe ist eigentlich eher taoistisch als konfuzianisch. Moderne KIs haben ziemlich starke Schutzmechanismen gegen Halluzinationen. Ich musste ChatGPT sogar die Erlaubnis erteilen, zu halluzinieren! Wenn Sie jemals mit der Vorstellungskraft eines Modells experimentieren wollen, sagen Sie ihm, es solle “völlig aus den Angeln heben” und beobachten Sie, wie es in den totalen Wahnsinn verfällt.

Kontrastives Lernen

Wie kann eine KI ohne Training eine Katze von einem Hund unterscheiden? Die Antwort liegt im kontrastiven Lernen. Im Folgenden unterteilen wir Hund und Katze in Attribute, wie wir es bereits bei anderen Tieren getan haben.

- Hund: Wuff, 4 Beine, Pfoten

- Katze: Miau, 4 Beine, Pfoten

Die Tiere oben sind fast identisch, aber nicht ganz. Diese Tiere geben unterschiedliche Laute von sich. Der Hund sagt “Wuff”, während die Katze “Miau” sagt. Das Modell wandelt diese Daten in Zahlen um. Dann findet es schnell den Unterschied zwischen den beiden Tieren. Mithilfe von Zero Shot filtern KI-Modelle ihre Einbettungen schnell nach kontrastierenden Informationen durch.

Schnelles Engineering

Promptes Engineering ist die Kunst, mit der KI zu sprechen. Wenn man weiß, was man sagen muss, kann man das Modell dazu bringen, genau die gewünschte Ausgabe zu erzeugen. In einem früheren Artikel über Web-Scraping mit Claude habe ich die folgende Eingabeaufforderung verwendet.

"""Hello, please parse this chunk of the HTML page and convert it to JSON. Make sure to strip newlines, remove escape characters, and whitespace: {response.text}"""Die Eingabeaufforderung ist klar und das Modell weiß genau, was es tun soll. Es spuckt eine Liste von Zitaten aus der Seite zurück. Hier ist nur ein Ausschnitt davon.

"quotes": [

{

"text": "The world as we have created it is a process of our thinking. It cannot be changed without changing our thinking.",

"author": "Albert Einstein",

"tags": ["change", "deep-thoughts", "thinking", "world"]

},

{

"text": "It is our choices, Harry, that show what we truly are, far more than our abilities.",

"author": "J.K. Rowling",

"tags": ["abilities", "choices"]

},Wenn ich das Datenformat nicht angegeben hätte, würde ich wahrscheinlich die gesamte Ausgabe im Klartextformat erhalten. Klartext ist gut für die menschliche Lesbarkeit, aber wenn Sie ein Programm schreiben, ist JSON viel besser zu arbeiten. Das Modell liefert mir, was ich will, weil ich die Eingabeaufforderung so geschrieben habe, dass sie genau das ausspuckt, was ich will. Prompt Engineering sorgt dafür, dass die generative Ausgabe sachlich und korrekt formatiert ist.

Herausforderungen und Grenzen des Zero-Shot Learning

Zero-Shot-Lernen hat seinen Preis. Wie wir bereits erwähnt haben, lässt Zero-Shot Raum für Halluzinationen. KI-Modelle sagen nicht gerne “Ich weiß es nicht” oder geben zu, wenn sie sich irren.

Um Halluzinationen vorzubeugen, verlassen wir uns in hohem Maße auf das Vortraining. Trainingsdaten sind teuer und oft unübersichtlich. Wenn Sie die Daten selbst erheben, müssen Sie eine ETL-Pipeline erstellen. ETL steht für “Extrahieren, Übertragen, Laden”. In großem Maßstab ist ETL kein Kinderspiel. Sie müssen Terabyte um Terabyte relevanter Daten auslesen. Dann müssen Sie sie bereinigen und formatieren (Übertragung). Und schließlich müssen sie in das Modell geladen werden. Erfahren Sie mehr über die Fallstricke der KI.

Wir von Bright Data bieten saubere, vorgefertigte Datensätze an. Diese können Ihr Pre-Training auf die nächste Stufe heben und Ihnen Stunden (sogar Tage) für Extraktion, Bereinigung und Formatierung ersparen. Werfen Sie einen Blick auf unsere strukturierten Datensätze.

Schlussfolgerung

Zero-Shot-Learning revolutioniert die KI, indem es Modelle in die Lage versetzt, neue Informationen ohne vorheriges Training zu verarbeiten. Mit der zunehmenden Verbreitung von KI wird diese Technik in allen Branchen noch wichtiger werden.

Sind Sie bereit, Ihre KI mit hochwertigen Daten zu unterstützen? Starten Sie Ihren kostenlosen Test mit Bright Data und greifen Sie noch heute auf erstklassige Datensätze zu!